写在前面:

本篇文章是对个人学习的笔记记录,仅用于学习使用。

中间可能会存在错别字、描述不准确的地方,欢迎各位网友指正。

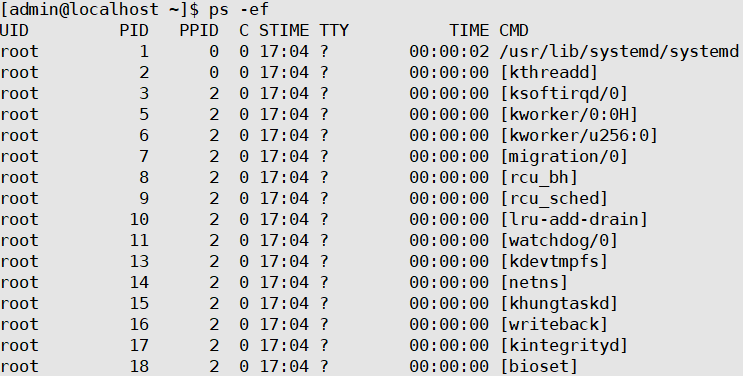

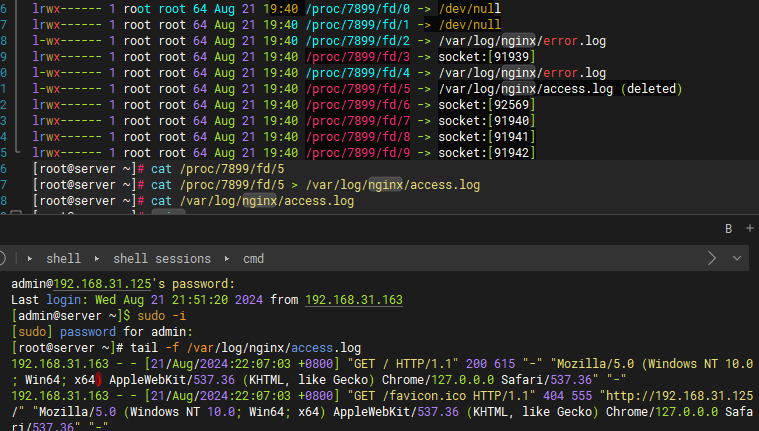

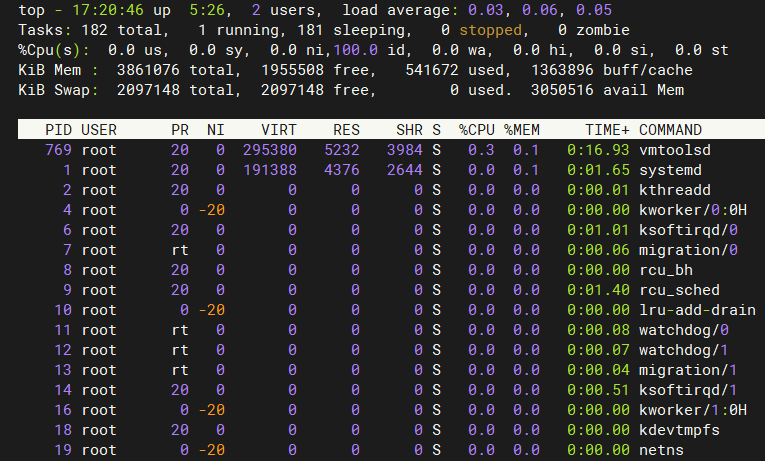

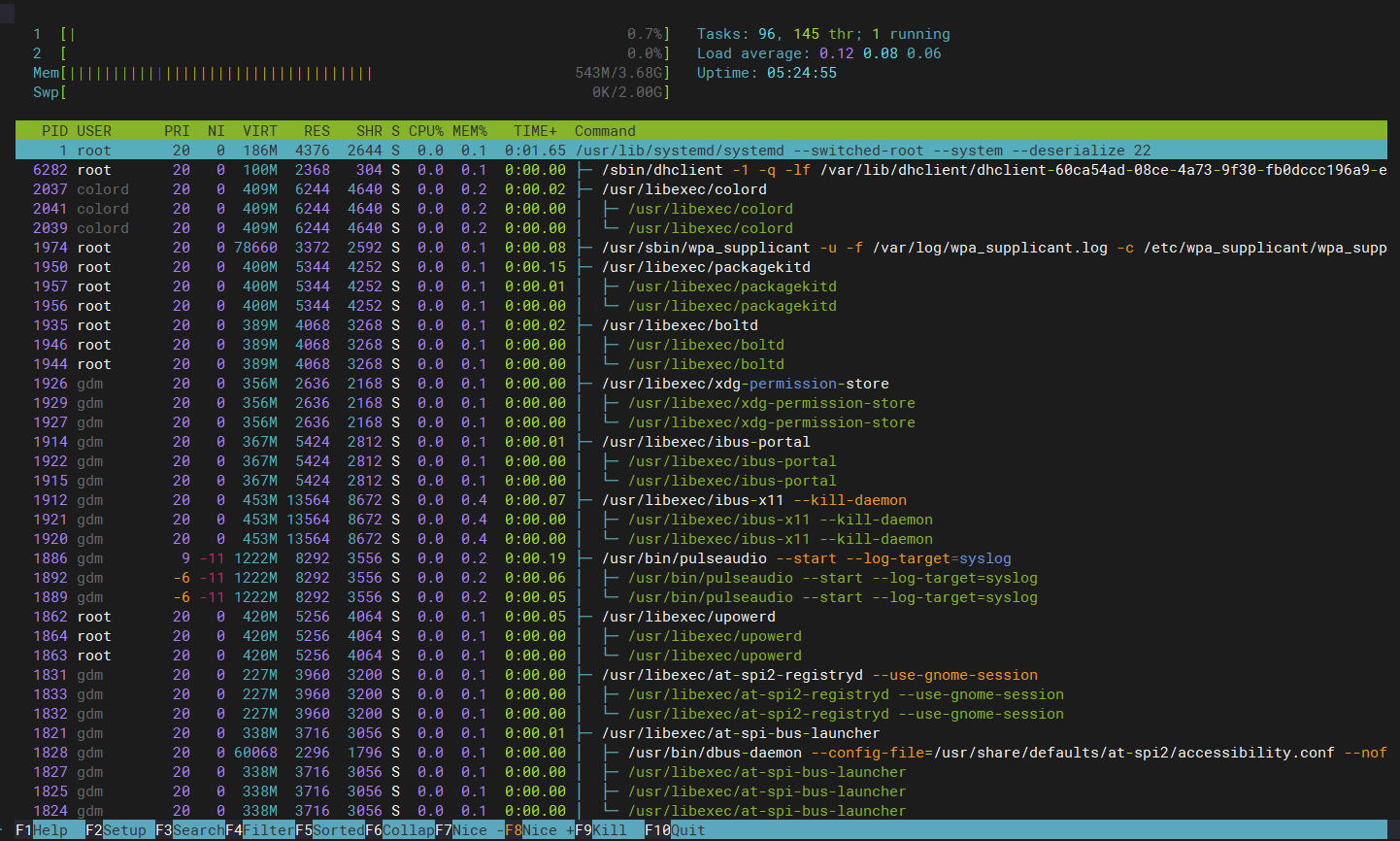

Linux基本命令

Linux启动过程

Linux手册

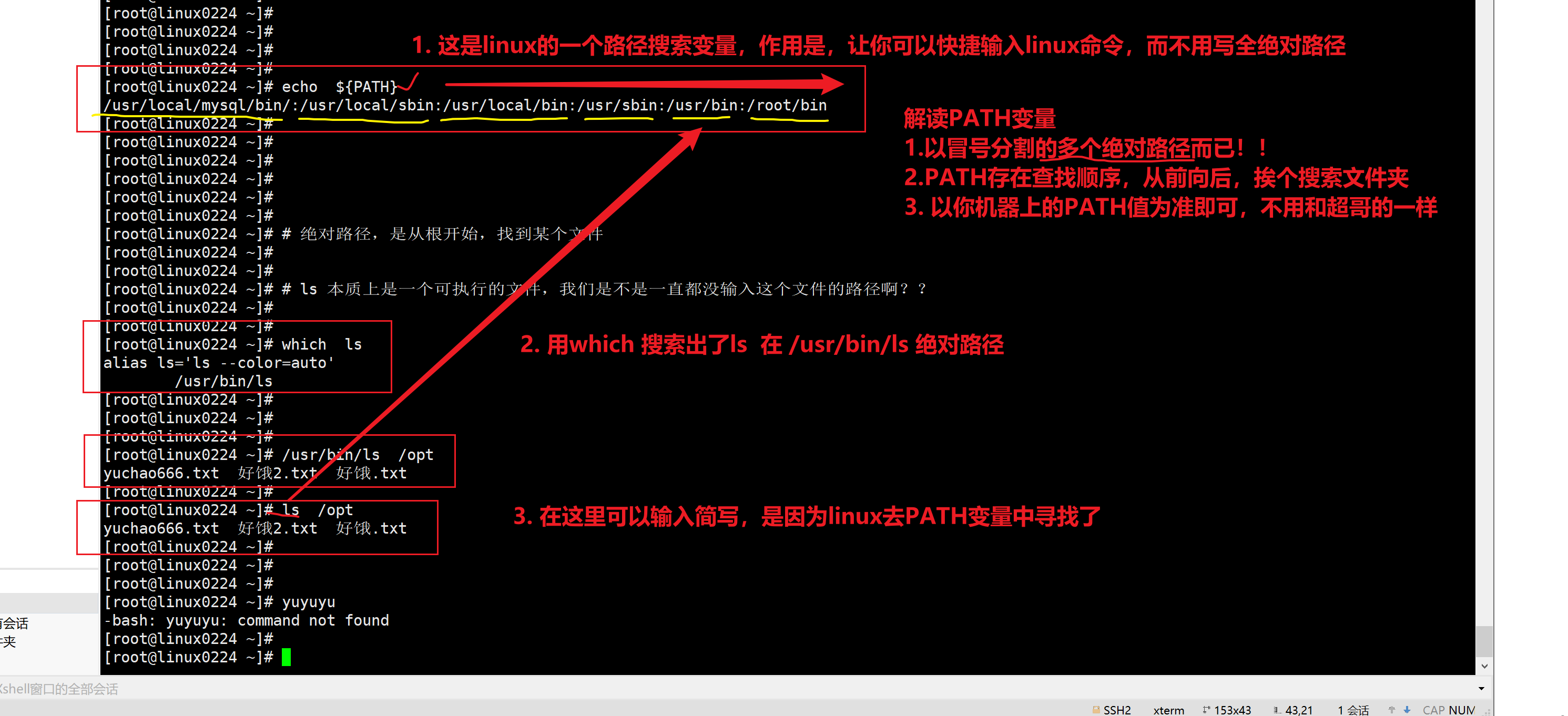

man -ls Linux提供的帮助手册,按下q退出手册which查找命令

which 去PATH路径中,找到命令的绝对路径,并输出。

[admin@server ~]$ which pwd

/usr/bin/pwdclear清屏命令

clear 清屏

Ctrl+lshutdown关机命令

shutdown 关机命令reboot重启系统

reboot 重启Linux系统history查看命令历史记录

history 显示今天敲了哪些命令,默认300条。

history -c 清空历史命令记录捋一捋

1.你登录了一个机器,你的操作,都会被history记录,临时存储在哎内存中

2.退出登录后,记录被写入到文件,永久存储,下一次登录 ,系统会去加载家目录中的资料,也包括 ~/.bash_hisotry

彻底清空的动作

> .bash_history

1.你登录了某机器,做了某操作,不想被记录, 直接hisotry -c ,清空你当前登录后,执行的所有操作

2. 把当前的历史记录,写入到文件中,强制写入(退出登录)

history -w # 把当前的历史记录,内存中的数据,写入到文件里

同时敲下面这两条命令

history -c

history -w

下次再登录,啥也看不到了!!执行上一条命令

!+[字母] 执行最近以[字母]开头的命令。

!+[number] 执行历史命令列表的第几条命令。 Ctrl+r 进入搜索命令行使用过得历史命令记录模式Ctrl+g 从执行Ctrl+r的搜索命令模式中退出Linux定时计划任务crontab

在线工具

什么是计划任务:后台运行,到了预定的时间就会自动执行的任务,前提是:事先手动将计划任务设定好。

周期性任务执行

清空/tmp目录下的内容

mysql数据库备份

redis数据备份

这就用到了crond服务。

计划任务的作用

操作系统不可能24 小时都有人在操作,有些时候想在指定的时间点去执行任务(例如:每天凌晨2 点去重新启动Apache),此时不可能真有人每天夜里2点去执行命令,这就可以交给计划任务程序去执行操作了。

查看计划任务

语法:

# crontab [选项]常用选项:

-l: list,列出指定用户的计划任务列表

-e : edit,执行文字编辑器来设定时程表,内定的文字编辑器是VI, 如果你想用别的文字编辑器,则请先设定VISUAL环境变数来指定使用那个文字编辑器(比如说setenv VISUAL joe)

-u : user,指定的用户名,如果不指定,则表示当前用户

-r : remove,删除指定用户的计划任务列表

示例代码:列出当前用户的计划任务列表

[root@server ~]# crontab -l

no crontab for root默认应该是没有设置定时任务的。

命令功能

通过crontab命令,我们可以在固定的间隔时间执行指定的系统指令或shell script脚本。时间间隔的单位可以是分钟、小时、日、月、周及以上的任意组合。这个命令非常设合周期性的日志分析或数据备份等工作。

编辑计划任务(重点)

进入计划任务编辑文件

[root@server ~]# crontab -e打开计划任务编辑文件后,可以在此文件中编写我们自定义的计划任务

计划任务的规则语法格式,以行为单位,一行则为一个计划:

分 时 日月周 需要执行的命令

例如:0 0* * * reboot ,代表每天0时0分执行reboot指令。

语法

[root@server ~]# cat /etc/crontab

SHELL=/bin/bash #定时任务,是帮我们去执行shell语句的,因此必须得有bash解释器,以及系统上有很多的解释器类型/bin/bash

PATH=/sbin:/bin:/usr/sbin:/usr/bin #注意:crontab自己定义了PATH变量,写在定时任务里面的命令,必须是绝对路径,不如容易出错

MAILTO=root #定时任务执行后,会给系统用户发一个邮件

# For details see man 4 crontabs

# Example of job definition:

# .---------------- minute (0 - 59) #分钟

# | .------------- hour (0 - 23) #小时

# | | .---------- day of month (1 - 31) #日

# | | | .------- month (1 - 12) OR jan,feb,mar,apr ... #月

# | | | | .---- day of week (0 - 6) (Sunday=0 or 7) OR sun,mon,tue,wed,thu,fri,sat #周

# | | | | |

# * * * * * user-name command to be executed

分 时 日 月 周 用户名 需要执行的命令

* * * * * 是命令的绝对路径取值范围(常识):

分 : 8 ~ 59

时 : 8 ~ 23

日 : 1 ~ 31

月 : 1 ~ 12

周 : 0 ~ 7,0和7表示星期天

#注意:日期和星期几是不能同时写得。

四个符号:

* : 表示取值范围中的每一个数字

- : 做连续区间表达式的,要想表示1~7,则可以写成: 1 - 7

/ : 表示每多少个,例如:想每10分钟一次,则可以在分的位置写: */10

, : 表示多个取值,比如想在1点,2点6点执行,则可以在时的位置写: 1 , 2 , 6并且在定时任务里,命令,请写上绝对路径。

通过whereis命令搜索绝对路径

如:

[root@server ~]# whereis systemctl

systemctl: /usr/bin/systemctl /usr/share/man/man1/systemctl.1.gz实例

* * * * *

分 时 日 月 周 命令绝对路径

[root@server ~]# crontab -e问题1:每月1、10、22 日的4:45 重启network 服务

45 4 1,10,20 * * /user/bin/systemctl restart network问题2:每周六、周日的下午1:10 重启network 服务

10 1 * * 6,7 /user/bin/systemctl restart network问题3:每天18:00 至23:00 之间每隔30 分钟重启network 服务

*/30 18-23 * * * /user/bin/systemctl restart network问题4:每隔两天的上午8点到11点的第3和第15分钟执行一次重启

3,15 8-11 */2 * * /usr/sbin/reboot问题5 :每天凌晨整点重启nginx服务。

0 0 * * * /user/bin/systemctl restart nginx问题6:每周4的凌晨2点15分执行命令

15 2 * * 4 command问题7:工作日的工作时间内的每小时整点执行my.sh脚本。

0 9-18 * * 1-5 /usr/bin/bash my.sh问题8:如果定时任务的时间,没法整除,定时任务就没有意义了,得通过其他手段,自主控制定时任务频率。

问题9:crontab提供最小分钟级别的任务,想完成秒级别的任务,得通过编程语言自己写。

问题10:每1分钟向文件里写入一句话"超哥666",且实时监测文件内容变化。

* * * * * /usr/bin/echo "超哥666" >> /tmp/666.txt

1.写入计划任务

[root@server ~]# crontab -e

2.写入语句

[root@server ~]# crontab -e

no crontabfor root-using an empty one

crontab: installing new crontab

[root@server ~]# crontab -l

* * * * * /usr/bin/echo "超哥666" >> /tmp/666.txt

3.等待定时任务执行

[root@server ~]# tail -F /tmp/666.txt

tail: cannot open '/tmp/666.txt’ for reading: No such file or directory

tail:“/tmp/666.txt"has appeared; following end of new file

超哥666

超哥666问题11:每天凌晨2点30,执行ntpdate命令同步 ntp.aliyun.com,并且sys同步到硬件时钟,且不输出任 何信息。

30 2 * * * /usr/sbin/ntpdate -u ntp.aliyun.com &> /dev/null

1.ntpdate同步成功后,会生成同步的结果日志

[root@server ~]# ntpdate u ntp.aliyun.com

可以重定向标准输出结果到照洞文件,

ntpdate -u ntp.aliyun.com &> /dev/nu1l

2.编写定时任务语句

30 2 * * * /usr/sbin/ntpdate untp.aliyun,com &> /dev/null;/usr/sbin/hwclock -w &> /dev/null问题12:1.每天的凌晨3点12分 备份整个/mysql_data目录到/opt/mysql_back.tgz,并且要求定时任务无信息输出。

备份整个文件夹,成为一个压缩文件

打包,且压缩文件夹,生成压缩文件

建议,这样去备份

方法一:

[root@server ~]# vim /scripts/mysql_bak.sh

cd /

tar -zcf /opt/mysql_back.tgz ./mysql_data

这样就是俩语句了得写入脚本文件中,再去执行文件

定时任务,执行这个脚本即可

[root@server ~]# 12 3 * * * /bin/bash /scripts/mysql_bak.sh

方法2

[root@server ~]# tar -zcf /opt/mysql_back.tgz /mysql_data

建议使用方法一问题13:由于jerry01业务需要创建定时任务,以root用户给jerry01创建如下定时任务。

* * * * * echo 'i am jerry01 , how are you' >> /tmp/jerry01.log

[root@server ~]# crontab -u jerry01 -e

crontab:installing new crontab

[root@server ~]# crontab-u jerry01 -l #查看定时任务

*****/usr/bin/echo 'i am jerry0l ,how are you' >> /tmp/jerry01.log扩展(黑白名单)

① crontab 权限问题

crontab是任何用户都可以创建的计划任务,但是超级管理员可以通过配置来设置某些用户不允许设置计划任务。 黑名单配置文件位于:/etc/cron.deny 里面写用户名,一行只能写一个

#禁止yuchao01用户设置定时任务

[root@yuchao-linux01 ~]# vim /etc/cron.deny

[root@yuchao-linux01 ~]#

[root@yuchao-linux01 ~]# cat /etc/cron.deny

yuchao81

#切换yuchao01用户登录

[yuchao01@yuchao-linux01 ~]$ crontab -e

You(yuchao01)are not allowed to use this program(crontab)

See crontab(1)for more information白名单还有一个配置文件,/etc/cron.allow(本身不存在,自己创建) 注意:白名单优先级高于黑名单,如果一个用户同时存在两个名单文件中,则会被默认允许创建计划任务。

#添加白名单后,会立即更新权限

[rootyuchao-linux01 ~]#echo'yuchao01"> /etc/cron.allow

# yuchao01就可以写入了

[yuchao01@yuchao-linux01 ~]$ crontab -e②查看计划任务文件保存路径

问题:计划任务文件具体保存在哪里呢? 答:/var/spoo1/cron/用户名文件中 ,如果使用root用户编辑计划任务,则用户文件名为root。 有图可见,该目录存放用户的定时任务信息,

③查看计划任务日志

问题:在实际应用中,我们如何查看定时任务运行情况? 答:通过计划任务日志,日志文件位于/var/log/cron

④定时任务,crontab会在系统中,生成大量的邮件日志,会占用磁盘,因此我们都会关闭邮件服务即可。

[root@server ~]# find / -type f -name 'post*.service'

/usr/lib/systemd/system/postfix.service

systemctl服务管理命令

[root@server ~]# systemctl list-units |grep post

postfix.service

loaded active running Postfix Mail Transport Agent

[root@server ~]# systemctl status postfix

[root@server ~]# systemctl stop postfix

[root@server ~]# systemctl is-enabled postfix

[root@server ~]# systemctl disable postfixDiff命令对比两个文件

语法

diff [-abBcdefHilnNpPqrstTuvwy][-<行数>][-C <行数>][-D <巨集名称>][-I <字符或字符串>][-S <文件>][-W <宽度>][-x <文件或目录>][-X <文件>][--help][--left-column][--suppress-common-line][文件或目录1][文件或目录2]参数

-<行数> 指定要显示多少行的文本。此参数必须与-c或-u参数一并使用。

-a或--text diff预设只会逐行比较文本文件。

-b或--ignore-space-change 不检查空格字符的不同。

-B或--ignore-blank-lines 不检查空白行。

-c 显示全部内文,并标出不同之处。

-C<行数>或--context<行数> 与执行"-c-<行数>"指令相同。

-d或--minimal 使用不同的演算法,以较小的单位来做比较。

-D<巨集名称>或ifdef<巨集名称> 此参数的输出格式可用于前置处理器巨集。

-e或--ed 此参数的输出格式可用于ed的script文件。

-f或-forward-ed 输出的格式类似ed的script文件,但按照原来文件的顺序来显示不同处。

-H或--speed-large-files 比较大文件时,可加快速度。

-I<字符或字符串>或--ignore-matching-lines<字符或字符串> 若两个文件在某几行有所不同,而这几行同时都包含了选项中指定的字符或字符串,则不显示这两个文件的差异。

-i或--ignore-case 不检查大小写的不同。

-l或--paginate 将结果交由pr程序来分页。

-n或--rcs 将比较结果以RCS的格式来显示。

-N或--new-file 在比较目录时,若文件A仅出现在某个目录中,预设会显示:

Only in目录:文件A若使用-N参数,则diff会将文件A与一个空白的文件比较。

-p 若比较的文件为C语言的程序码文件时,显示差异所在的函数名称。

-P或--unidirectional-new-file 与-N类似,但只有当第二个目录包含了一个第一个目录所没有的文件时,才会将这个文件与空白的文件做比较。

-q或--brief 仅显示有无差异,不显示详细的信息。

-r或--recursive 比较子目录中的文件。

-s或--report-identical-files 若没有发现任何差异,仍然显示信息。

-S<文件>或--starting-file<文件> 在比较目录时,从指定的文件开始比较。

-t或--expand-tabs 在输出时,将tab字符展开。

-T或--initial-tab 在每行前面加上tab字符以便对齐。

-u,-U<列数>或--unified=<列数> 以合并的方式来显示文件内容的不同。

-v或--version 显示版本信息。

-w或--ignore-all-space 忽略全部的空格字符。

-W<宽度>或--width<宽度> 在使用-y参数时,指定栏宽。

-x<文件名或目录>或--exclude<文件名或目录> 不比较选项中所指定的文件或目录。

-X<文件>或--exclude-from<文件> 您可以将文件或目录类型存成文本文件,然后在=<文件>中指定此文本文件。

-y或--side-by-side 以并列的方式显示文件的异同之处。

--help 显示帮助。

--left-column 在使用-y参数时,若两个文件某一行内容相同,则仅在左侧的栏位显示该行内容。

--suppress-common-lines 在使用-y参数时,仅显示不同之处。实例1:比较两个文件

[root@localhost test3]# diff log2014.log log2013.log

3c3

< 2014-03

---

> 2013-03

8c8

< 2013-07

---

> 2013-08

11,12d10

< 2013-11

< 2013-12上面的"3c3"和"8c8"表示log2014.log和log20143log文件在3行和第8行内容有所不同;"11,12d10"表示第一个文件比第二个文件多了第11和12行。

实例2:并排格式输出

[root@localhost test3]# diff log2014.log log2013.log -y -W 50

2013-01 2013-01

2013-02 2013-02

2014-03 | 2013-03

2013-04 2013-04

2013-05 2013-05

2013-06 2013-06

2013-07 2013-07

2013-07 | 2013-08

2013-09 2013-09

2013-10 2013-10

2013-11 <

2013-12 <

[root@localhost test3]# diff log2013.log log2014.log -y -W 50

2013-01 2013-01

2013-02 2013-02

2013-03 | 2014-03

2013-04 2013-04

2013-05 2013-05

2013-06 2013-06

2013-07 2013-07

2013-08 | 2013-07

2013-09 2013-09

2013-10 2013-10

> 2013-11

> 2013-12说明:

"|"表示前后2个文件内容有不同

"<"表示后面文件比前面文件少了1行内容

">"表示后面文件比前面文件多了1行内容

文件目录篇

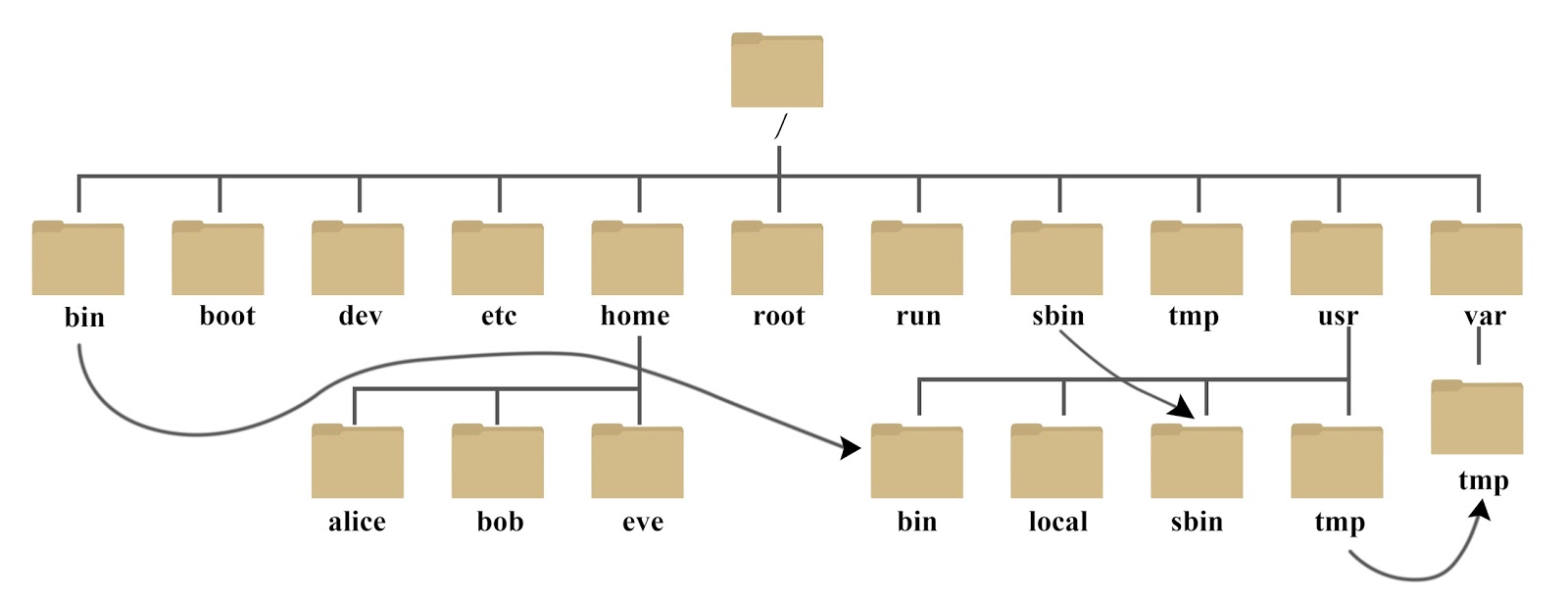

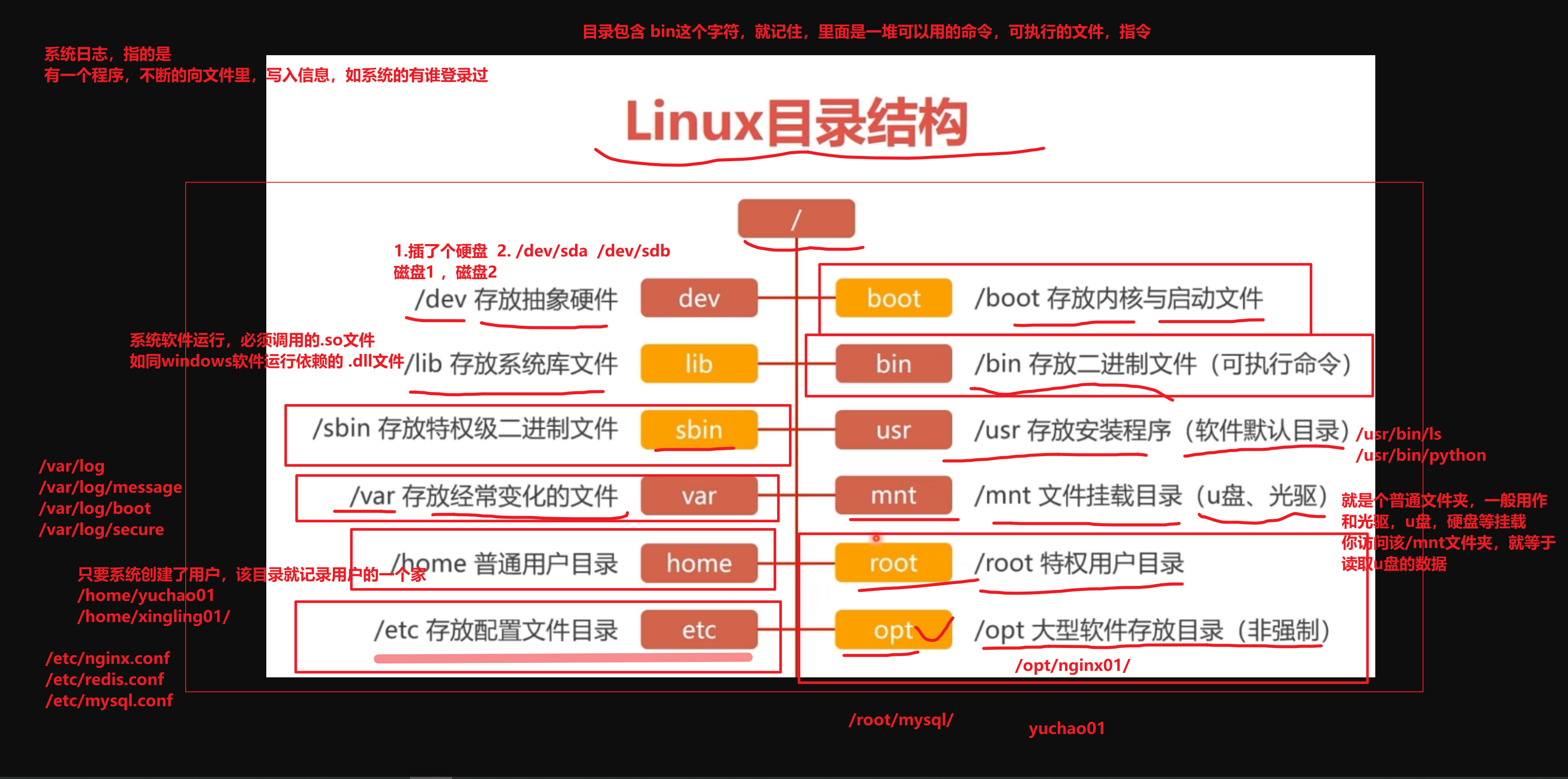

Linux目录树状图

常见目录(需记忆)

以下是对这些目录的解释:

/bin: bin 是 Binaries (二进制文件) 的缩写, 这个目录存放着最经常使用的命令。

/boot: 这里存放的是启动 Linux 时使用的一些核心文件,包括一些连接文件以及镜像文件。

/dev : dev 是 Device(设备) 的缩写, 该目录下存放的是 Linux 的外部设备,在 Linux 中访问设备的方式和访问文件的方式是相同的。

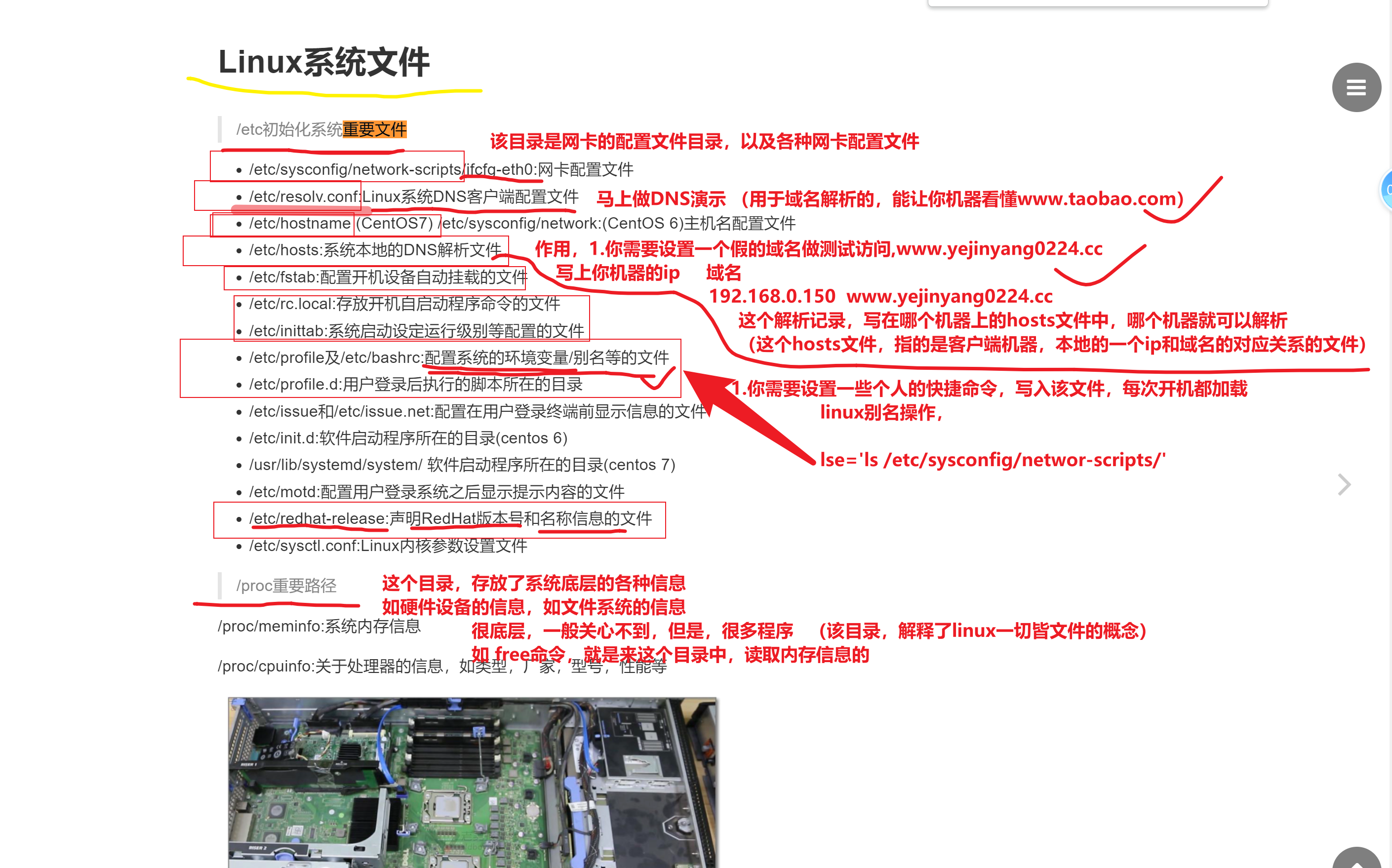

/etc: etc 是 Etcetera(等等) 的缩写,这个目录用来存放所有的系统管理所需要的配置文件和子目录。

/home: 用户的主目录,在 Linux 中,每个用户都有一个自己的目录,一般该目录名是以用户的账号命名的,如上图中的 alice、bob 和 eve。

/lib: lib 是 Library(库) 的缩写这个目录里存放着系统最基本的动态连接共享库,其作用类似于 Windows 里的 DLL 文件。几乎所有的应用程序都需要用到这些共享库。

/lost+found: 这个目录一般情况下是空的,当系统非法关机后,这里就存放了一些文件。

/media: linux 系统会自动识别一些设备,例如U盘、光驱等等,当识别后,Linux 会把识别的设备挂载到这个目录下。

/mnt: 系统提供该目录是为了让用户临时挂载别的文件系统的,我们可以将光驱挂载在 /mnt/ 上,然后进入该目录就可以查看光驱里的内容了。

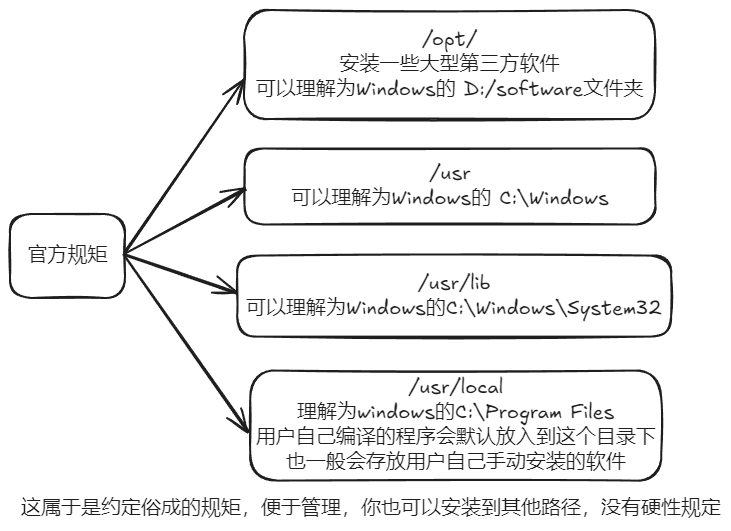

/opt: opt 是 optional(可选) 的缩写,这是给主机额外安装软件所摆放的目录。比如你安装一个ORACLE数据库则就可以放到这个目录下。默认是空的。

/proc: proc 是 Processes(进程) 的缩写,/proc 是一种伪文件系统(也即虚拟文件系统),存储的是当前内核运行状态的一系列特殊文件,这个目录是一个虚拟的目录,它是系统内存的映射,我们可以通过直接访问这个目录来获取系统信息。 这个目录的内容不在硬盘上而是在内存里,我们也可以直接修改里面的某些文件,比如可以通过下面的命令来屏蔽主机的ping命令,使别人无法ping你的机器:

echo 1 > /proc/sys/net/ipv4/icmp_echo_ignore_all/root: 该目录为系统管理员,也称作超级权限者的用户主目录。

/sbin: s 就是 Super User 的意思,是 Superuser Binaries (超级用户的二进制文件) 的缩写,这里存放的是系统管理员使用的系统管理程序。

/selinux: 这个目录是 Redhat/CentOS 所特有的目录,Selinux 是一个安全机制,类似于 windows 的防火墙,但是这套机制比较复杂,这个目录就是存放selinux相关的文件的。

/srv: 该目录存放一些服务启动之后需要提取的数据。

/sys:

这是 Linux2.6 内核的一个很大的变化。该目录下安装了 2.6 内核中新出现的一个文件系统 sysfs 。

sysfs 文件系统集成了下面3种文件系统的信息:针对进程信息的 proc 文件系统、针对设备的 devfs 文件系统以及针对伪终端的 devpts 文件系统。

该文件系统是内核设备树的一个直观反映。

当一个内核对象被创建的时候,对应的文件和目录也在内核对象子系统中被创建。

/tmp: tmp 是 temporary(临时) 的缩写这个目录是用来存放一些临时文件的。

/usr: usr 是 unix shared resources(共享资源) 的缩写,这是一个非常重要的目录,用户的很多应用程序和文件都放在这个目录下,类似于 windows 下的 program files 目录。

/usr/bin: 系统用户使用的应用程序。

/usr/sbin: 超级用户使用的比较高级的管理程序和系统守护程序。

/usr/src: 内核源代码默认的放置目录。

/usr/local/:

用户自己编译的程序会默认放在该目录下。

/var: var 是 variable(变量) 的缩写,这个目录中存放着在不断扩充着的东西,我们习惯将那些经常被修改的目录放在这个目录下。包括各种日志文件。

/var/cache/:

Linux缓存目录。

/run: 是一个临时文件系统,存储系统启动以来的信息。当系统重启时,这个目录下的文件应该被删掉或清除。如果你的系统上有 /var/run 目录,应该让它指向 run。

在 Linux 系统中,有几个目录是比较重要的,平时需要注意不要误删除或者随意更改内部文件。

/etc: 上边也提到了,这个是系统中的配置文件,如果你更改了该目录下的某个文件可能会导致系统不能启动。

/bin, /sbin, /usr/bin, /usr/sbin: 这是系统预设的执行文件的放置目录,比如 ls 就是在 /bin/ls 目录下的。

值得提出的是 /bin、/usr/bin 是给系统用户使用的指令(除 root 外的通用用户),而/sbin, /usr/sbin 则是给 root 使用的指令。

/var: 这是一个非常重要的目录,系统上跑了很多程序,那么每个程序都会有相应的日志产生,而这些日志就被记录到这个目录下,具体在 /var/log 目录下,另外 mail 的预设放置也是在这里。

特殊目录

. 当前工作目录

.. 上一级的目录

.filename 以.开头的文件,表示隐藏文件

- 上一次工作目录

~ 当前登陆用户的家目录

cd 在目录之间移动

[root@localhost ~]# cd /etc/yum

[root@localhost yum]#

[root@localhost yum]# cd /~ #或者cd

[root@localhost ~]

cd - 短横线表示上一次的工作目录

[root@localhost yum]# cd -

/root

[root@localhost ~]# cd -

/etc/yum

[root@localhost yum]#

作业:假如我当前在/root/desktop/apple/xiaomi目录,我要进入到/desktop/huawei目录,怎么实现?

[root@root ~]# cd desktop/

[root@root desktop]# ls

apple huawei

方法一:绝对路径

[root@root xiaomi]# cd /root/desktop/huawei/

[root@root huawei]#

方法二:相对路径

[root@root xiaomi]# pwd

/root/desktop/apple/xiaomi/redmi

[root@root xiaomi]# cd ../../huawei

[root@root huawei]# tree命令——显示目录结构

tree命令使用示例

查看命令版本

[root@root ~]# tree --version

tree v1.7.0 (c) 1996 - 2014 by Steve Baker, Thomas Moore, Francesc Rocher, Florian Sesser, Kyosuke Tokoro查看目录/opt目录结构

[root@root ~]# tree -N /opt/

/opt/

├── rh

├── 璃月

│ └── 岩神

│ └── 钟离.png

├── 稻妻

│ └── 雷神

│ └── 雷电将军.png

├── 蒙德

│ └── 风神

│ └── 巴巴托斯.png

└── 须弥

└── 草神

└── 纳西妲.png

9 directories, 4 files使用语法

tree [选项] [目录]

tree [选项] [目录] -o filename参数说明

展示参数说明

文件参数说明

排序参数说明

图形选项参数说明

XML/HTML选项参数说明

特殊文件

/dev/null

/dev/null代表linux的空设备文件,所有往这个文件里面写入的内容都会丢失,俗称“黑洞”。比较常见的用法是把不需要的输出重定向到这个文件。

ping yuchaoit.cn > /dev/null &/dev/zero

零”设备,可以无限的提供空字符(0x00,ASCII代码NUL)。常用来生成一个特定大小的文件。

dd if=/dev/zero of=test.log bs=1M count=50/dev/random和/dev/urandom

/dev/random和/dev/urandom是Linux系统中提供的随机伪设备,这两个设备的任务,是提供永不为空的随机字节数据流。很多解密程序与安全应用程序(如SSH Keys,SSL Keys等)需要它们提供的随机数据流。危险玩法,比如实现类似于shred粉碎文件的作用

dd bs=1M count=30 if=/dev/urandom of=./t1

也可以销毁硬盘分区数据

dd if=/dev/urandom of=/dev/sda5实例

如何生成一个5G大小的文件,提示(dd命令)

dd if=/dev/zero of=/opt/5G.txt bs=100M count=50用户管理篇

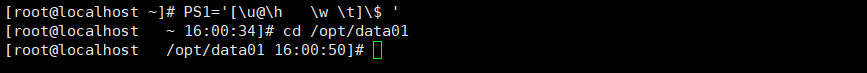

Linux登陆与退出登陆

远程登录方式Win/Linux

Xshell/Windows

ssh [主机名]@[要登陆的主机IP的地址][:端口号 默认:22]

如:[C:\~]$ssh admin@10.0.0.129:22Linux终端

ssh -p [端口号] [主机名]@[要登陆的主机IP的地址]

如:[admin@localhost ~]$ssh -p 20 admin@10.0.0.130远程登录ubuntu

ubuntu乌班图下,都是普通用户操作,必须加sudo

1.默认拿到一个新机器,可能没开启ssh服务,无法远程连接

2.或许需要升级下软件仓库

sudo apt update

3.需要安装ssh服务

sudo apt install openssh-server

#查询安装好ssh没有

#dpkg -l | grep ssh

4.启动ssh服务,即可远程连接

sudo service sshd start

5.查看该端口

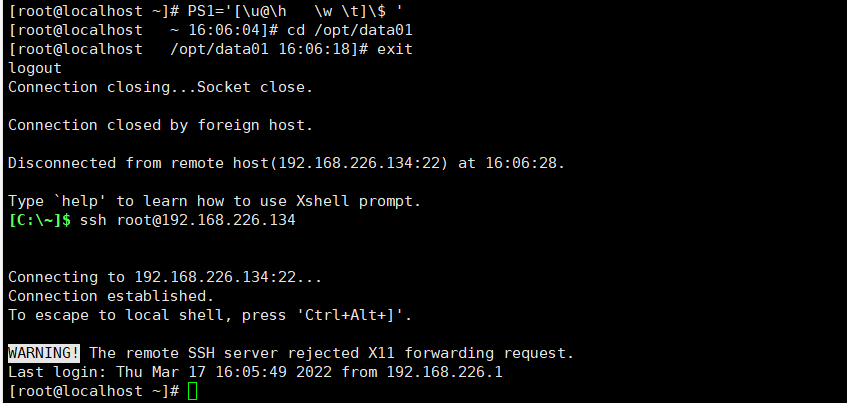

sudo ss -tunlp|grep 22exit/logout退出登陆

exit 退出登陆

logout 退出该会话登陆id/whomai命令,查看用户信息

验证该用户名是否存在

id [用户名]

[admin@localhost ~]$ id root

uid=0(root) gid=0(root) groups=0(root)

[admin@localhost ~]$ id admin

uid=1000(admin) gid=1000(admin) groups=1000(admin),10(wheel)

[admin@localhost ~]$ id admin01

id: admin01: no such user查看系统中的当前用户信息

id

[root@localhost ~]# id

uid=0(root) gid=0(root) groups=0(root)

whoami

[root@localhost ~]# whoami

rootlast显示登录记录

last -5 显示最近的5条登录记录

lastlog 显示关于用户的登录记录useradd创建新用户

用户与用户组在Linux中的记录

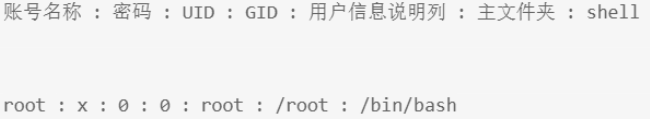

Linux将用户账号、密码等相关信息分别存储在四个文件夹下:

/etc/passwd 管理用户UID/GID重要参数

/etc/shadow 管理用户密码

/etc/group 管理用户组相关信息

/etc/gshadow 管理用户组管理员相关信息(给组设置密码)

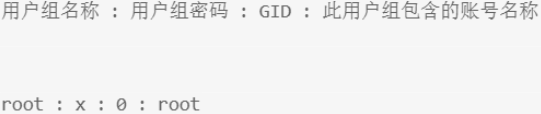

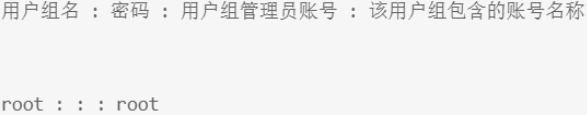

自动创建用户的家目录,默认在/home下,与用户名同名,如/home/root/etc/passwd存储格式

其中,

密码项显示"x” 是出于安全考虑, Linux 将密码信息移到/etc/shadow 进行存储;

每一个用户都有一一个 UID、GID,对应的含义就是UserID、GrouplD, UID会映射到/etc/shadow以获得密码信息,GID会映射到/etc/group以获取用户的用户组信息。

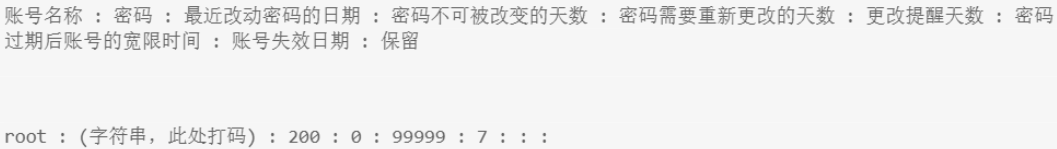

/etc/shadow存储格式

其中,

第二列表示密码加密后的字符串。

/etc/passwd通过UID, 在该文件中找出对应UID 的用户,并提取对应密码用于登陆验证。

/etc/group存储格式

其中,用户组密码通常是为了设置用户组管理员存在的,其信息也移动到/etc/gshadow中;/etc/passwd通过GID,在该文件中找到对应的用户组,并提取用户组相关信息;

另外,由于一一个用户可以在多个用户组中,因此就有一一个初始用户组的有效用户组的概念。

所谓的初始用户组,就是用户所记录的GID, 是在创建用户时生成或指定的用户组;所谓的有效用户组,就是利用命令groups 查看并输出的首个用户组,即有效用户组;用户在登录的时候,以初始用户组身份工作,用户可以用newgrp命令实现有效用户组的切换。

/etc/gshadow存储格式

般用户组不使用用户组管理员,相应地也就不需要设置密码。

Linux用户账号管理

在此部分,会分别介绍新增、修改、删除用户及用户组,用户身份切换,查询用户信息等多种用户账号的管理操作。

命令行格式

Linux命令行格式: command [-options] [parameter]

command:命令名,相应功能的英文单词或单词的缩写

[-options]:选项,可用来对命令进行控制,也可以省略

[parameter]:传给命令的参数,可以是0个、1个或多个useradd新增、修改、删除用户

可选参数

-c<备注> 加上备注文字。备注文字会保存在passwd的备注栏位中。

-d<登入目录> 指定用户登入时的起始目录。

-D 变更预设值.

-e<有效期限> 指定帐号的有效期限。

-f<缓冲天数> 指定在密码过期后多少天即关闭该帐号。

-g<群组> 指定用户所属的群组。

-G<群组> 指定用户所属的附加群组。

-m 制定用户的登入目录。

-M 不要自动建立用户的登入目录。

-n 取消建立以用户名称为名的群组.

-r 建立系统帐号。

-s<shell> 指定用户登入后所使用的shell。

-u<uid> 指定用户ID。

新增用户 useradd

useradd [-options] [username]在使用useradd 时,可以通过不同的参数options, 达到不同的创建用户的效果,例如指定UID、指定初始用户组、指定次要用户组、指定主文件夹等。具体参数请利用man命令进行查询。useradd在不指定任何参数的时候,会参考两个主要配置文件的默认值来新增用户。

[admin@localhost ~]$ cat /etc/default/useradd

# useradd defaults file

GROUP=100 #默认的用户组

HOME=/home #默认的主文件夹所在目录

INACTIVE=-1 #密码失效日

EXPIRE= #账号失效日

SHELL=/bin/bash #默认shell

SKEL=/etc/skel #用户主文件夹的内容数据参考目录

CREATE_MAIL_SPOOL=yes #是否创建邮件信箱[admin@localhost ~]$ cat /etc/login.defs

PASS_MAX_DAYS 99999 #多久必须重设密码(天)

PASS_MIN_DAYS 0 #距上次修改密码多久不可重设密码(天)

PASS_MIN_LEN 5 #密码最短的字符长度

PASS_WARN_AGE 7 #距离多少天过期会报警提示

UID_MIN 1000 #创建用户的UID默认最小值

UID_MAX 60000 #创建用户的UID上限

GID_MIN 1000 #创建用户的GID默认最小值

GID_MAX 60000 #创建用户的GID上限

CREATE_HOME yes #创建家目录

USERGROUPS_ENAB yes #删除用户时是否删除初始用户组(组内不再有其他成员)useradd通过参考这两个文件的配置信息,赋予创建的用户默认值。另外,useradd默认会在/home下创建用户同名的主目录;同时,useradd创建的用户还没有设置登录密码,需要利用passwd进行密码设置。

设置密码 passwd

利用passwd命令,可以设置或重置密码

passwd [-options] [username]与useradd相同,不同的options参数能够满足不同的密码设置需求,包括失效时间、密码改动时间等。

修改用户

chage命令用来修改与用户密码相关的过期信息,如密码失效日、密码最短保留天数、失效前警告天数等。

chage [-options] [username]当然,passwd也可以做相应的修改.

usermod

用来修改用户信息

usermod [-options] [username]

将用户yang加入到devops组里

usermod -G devops yangusermod通过选用不同的options 参数,可以修改存储在/etc/passwd内的用户信息。

删除用户

userdel命令用来删除用户的相关的所有数据。

userdel [-options] [username]

options:

-r:同时删除用户的家目录groupad新增、修改、删除用户组

可选参数

-g 设置id号,默认从1000开始,1~999是系统预留的组。

groupadd -g 1001 yanghonqiang

-n 设置组名新增用户组

使用方式与useradd 非常相似,与useradd 不同的是,新建的用户组通常不需要设置密码。

groupadd [-options] [username]修改用户组

groupmod命令用来修改group相关的参数,不过通常不建议修改GID

groupmod [-options] [username]删除用户组

groupdel删除用户组之前,必须保证没有任何-个用户使用这个用户组作为初始用户组,否则无法删除。

groupdel [options] [groupname]su命令,用户名切换,sudo -i用户切换

su [-options] [系统中存在的用户名]

#短横线"-"表示切换用户且加载该用户的环境变量PATH,且进入该用户的家目录。

#不加短横线,为不完全切换,不加载该目标用户的环境变量。

su - 切换到root用户命令等同于 sudo -i命令

[admin@localhost ~]$ su - root

Password: #root

Last login: Fri Jul 12 16:25:59 CST 2024 from 10.0.0.1 on pts/1

Last failed login: Tue Jul 16 20:28:27 CST 2024 on pts/1

There was 1 failed login attempt since the last successful login.

[root@localhost ~]# su - admin

Last login: Tue Jul 16 20:30:23 CST 2024 on pts/1

[admin@localhost ~]$

options:

-: 代表使用login-shell 的变量文件读取方式来登录系统.

-l: 同上.

-m: 表示使用当前的环境设置,而不读取新用户的配置文件.

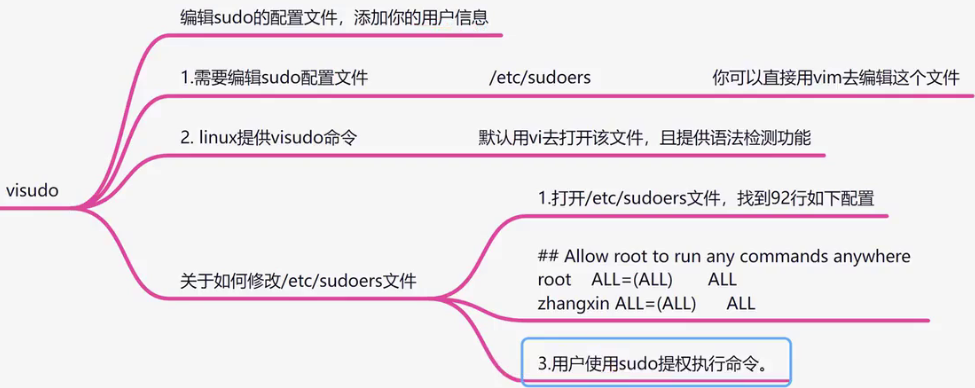

-C: 仅进行一-次命令,执行完后直接回到目前的用户身份.visudo

who/w查看当前登陆系统终端

[admin@root ~]$ who

admin :0 2024-07-20 19:06 (:0)

admin pts/0 2024-07-20 19:06 (:0) #VMware

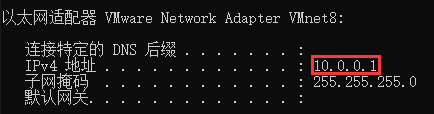

admin pts/1 2024-07-20 19:35 (10.0.0.1) #Xshell 7 通过物理机的以太网卡VMnet8进来的。Windows->Linux

[admin@root ~]$ w

19:39:35 up 34 min, 3 users, load average: 0.04, 0.03, 0.05

USER TTY FROM LOGIN@ IDLE JCPU PCPU WHAT

admin :0 :0 19:06 ?xdm? 39.14s 0.12s /usr/libexec/gnome-session-binary

admin pts/0 :0 19:06 1:59 0.26s 1.89s /usr/libexec/gnome-terminal-server

admin pts/1 10.0.0.1 19:35 7.00s 0.03s 0.01s w主要涉及用户信息查询的命令

id <user> #展示指定user的UID、GID、用户组信息等,默认为当前有效用户

who am i #等同于who -m,仅显示当前登录用户相关信息

whoami #仅显示当前有 效用户的用户名

W #展示当前正在登录主机的用户信息及正在执行的操作

who #展示当前正在登录主机的用户信息

last <user> #展示指定用户的历史登录信息,默认为当前有效用户

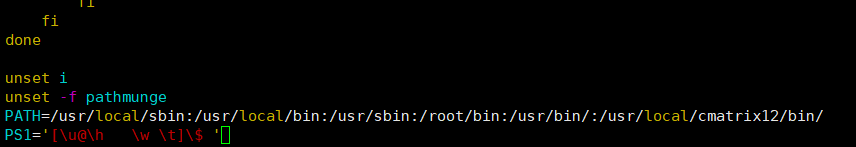

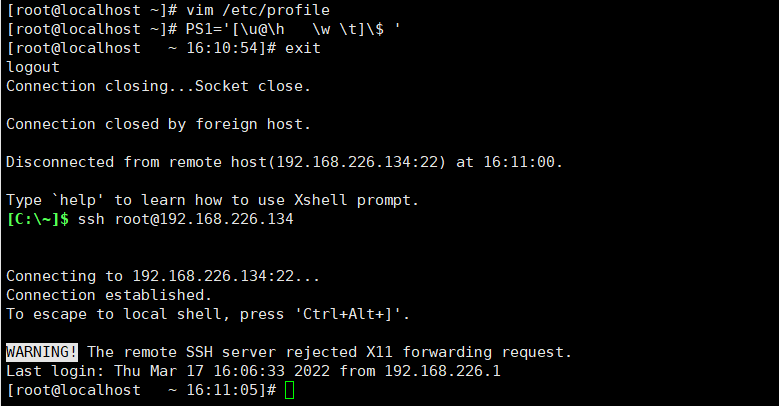

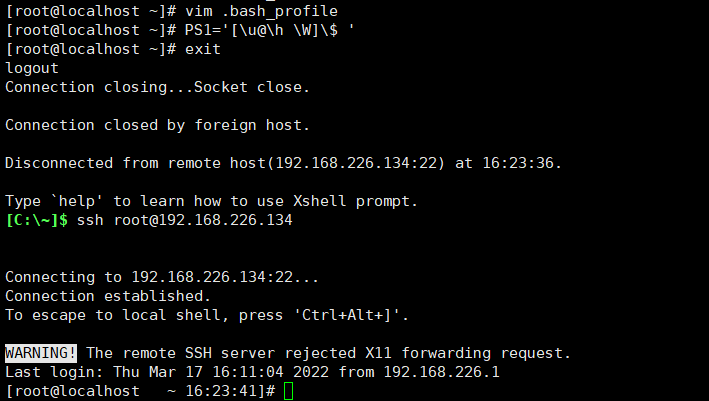

lastlog -u <user> #展示指定用户最近的一次登录信息,默认显示所有用户hostname修改主机名

主机名

[root@localhost ~]# hostname #查看当前主机名

localhost.localdomain

[root@localhost ~]# hostname linux01 #临时修改主机名

[root@localhost ~]# hostname

linux01

[root@localhost ~]# hostnamectl set-hostname [主机名] #修改主机名

[root@localhost ~]# vi /etc/hostname #修改主机名 永久

[root@localhost ~]# cat /etc/hostname

linux01

#1,退出登陆实现修改

[root@linux01 ~]# exit

logout

[admin@localhost ~]$ su - root

Password:

Last login: Tue Jul 16 21:22:08 CST 2024 on pts/1

[root@linux ~]#

#2,重新加载该系统的环境变量(建议使用这个)

[root@localhost ~]# bash

[root@linux01 ~]#

#3,--reboot 重启生效(生产环境中慎用)

[root@linux01 ~]# uname查看内核信息

查看内核信息 name

[admin@localhost ~]$ uname

Linux

[admin@localhost ~]$ uname -a

Linux localhost.localdomain 3.10.0-862.el7.x86_64 #1 SMP Fri Apr 20 16:44:24 UTC 2018 x86_64 x86_64 x86_64 GNU/Linux

uname常见命令参数

-a, --all print all information, in the following order,

except omit -p and -i if unknown://显示全部信息

-s, --kernel-name print the kernel name // 显示内核名称

-n, --nodename print the network node hostname //显示主机名

-r, --kernel-release print the kernel release //显示内核的发行版本

-v, --kernel-version print the kernel version //显示内核版本

-m, --machine print the machine hardware name //显示硬件名

-p, --processor print the processor type or "unknown" //显示处理器名称

-i, --hardware-platform print the hardware platform or "unknown" //显示硬件平台类型

-o, --operating-system print the operating system //显示操作系统名文件管理篇

文件命名规则

除了字符/之外,所有的字符都可以使用,但要注意,在目录名或文件名中,不建议使用某些特殊字符例如:< > ? 、 *等。如果一个文件名包含了特殊字符,例如空格,那么在访问这个文件时需要使用引号``将文件名括起来。

建议文件命名规则

由于Linux严格区分大小写,因此建议使用小写字母命名。

如果必须对文件进行分割,建议使用_来进行分割,如:

manba_out.txt创建和删除文件夹

mkdir命令

mkdir 创建文件夹(只有创建文件夹的作用) mkdir [文件名]

在root目录下创建Desktop文件夹 mkdir /root/Desktop

mkdir [文件夹1] [文件夹2] [文件夹3] 在当前目录下一次性创建多个文件夹

[root@root desktop]# mkdir txt01 txt02 txt03

[root@root desktop]# ls

hello world! txt01 txt02 txt03

mkdir -p [文件夹/文件夹/文件夹] 一次性递归创建多个文件夹

[root@root desktop]# mkdir -p txt01/ops/nginx

[root@root nginx]# pwd

/root/desktop/txt01/ops/nginx

可以同时创建多个文件夹,且注意绝对,相对路径。

如:一次性在当前目录下创建 原神,在/opt下创建gensin并在其文件夹里再创建game文件夹,在/根目 录下创建star,在上一级目录创建zzz。

[root@root desktop]#mkdir -p ./原神 /opt/gensin/game /star ../zzz rmdir命令

rmdir 删除空目录 rmdir [文件名] rmdir /root/Desktop

在root目录下删除Desktop文件夹rmdir [文件夹1] [文件夹2] [文件夹3] #删除的是最后一个文件夹3.rmdir -p [文件夹1] [文件夹2] [文件夹3] #递归删除改路径下的所有文件夹,前提是文件夹里没文件。创建和删除文件

touch命令

touch 创建文本(1.创建文件 2.修改时间戳) touch {文本名}[.txt]

1.该文件名不存在,则创建该文件

创建一个happy.txt文件 touch happy.txt

1.1 touch '[filename!!]' 加上单引号可以命名特殊符号,"/"除外。

[root@root desktop]# touch hello world!

[root@root desktop]# ll

total 0

-rw-r--r--. 1 root root 0 Jul 16 22:07 hello

-rw-r--r--. 1 root root 0 Jul 16 22:07 world!

[root@root desktop]# touch 'hello world!'

[root@root desktop]# ll

total 0

-rw-r--r--. 1 root root 0 Jul 16 22:07 hello world!

2.该文件名存在,则是修改他的文件时间属性(被访问的时间是什么时候)例题一

修改 /desktop/happy.txt 的访问时间为 2018-08-08:13:00

touch -d "2018-08-08:13:00" -a /desktop/happy.txt例题二

修改 /desktop/happy.txt 的数据修改时间为 2018-08-08:13:00

touch -d "2018-08-08:13:00" -m /desktop/happy.txt在同级目录下创建多个文件,文件夹也同样适用

[root@root ~]# touch desktop/game/mihoyo/{gemsin,star,zzz}

[root@root ~]# mkdir -p desktop/mingcaho/{今夕,长离}

[root@root ~]# tree -FN desktop/

desktop/

├── game/

│ └── mihoyo/

│ ├── gemsin

│ ├── star

│ └── zzz

└── mingcaho/

├── 今夕/

└── 长离/

5 directories, 3 files

# "/"表示文件夹类型,没有"/"表示文件类型花括号{ }结合touch命令,创建多个连续文件

创建1~10个game.log文件

[root@root desktop]# touch game{1..10}.log

[root@root desktop]# ls

game10.log game2.log game4.log game6.log game8.log

game1.log game3.log game5.log game7.log game9.log

删除1~10个game.log文件

[root@root desktop]# sudo rm game{1..10}.logstat命令可以查看文件详细信息

stat是status英文单词的缩写,表示状态的意思。

这里用于证明touch命令可以修改时间戳

[root@root desktop]# echo "原神启动" > hello\ world\!

[root@root desktop]# cat hello\ world\!

原神启动

[root@root desktop]# stat hello\ world\!

File: ‘hello world!’

Size: 13 Blocks: 8 IO Block: 4096 regular file

Device: fd00h/64768d Inode: 18217622 Links: 1

Access: (0644/-rw-r--r--) Uid: ( 0/ root) Gid: ( 0/ root)

Context: unconfined_u:object_r:admin_home_t:s0

Access: 2024-07-16 22:15:39.109795966 +0800

Modify: 2024-07-16 22:15:36.060796166 +0800

Change: 2024-07-16 22:15:36.060796166 +0800

Birth: -

#stat命令可以查看文件的详细信息,

#Access 访问时间

#Modify 文件内容修改变化时间

#Change 文件的权限,文件名,文件大小等变化时间。vim也可以创建文件

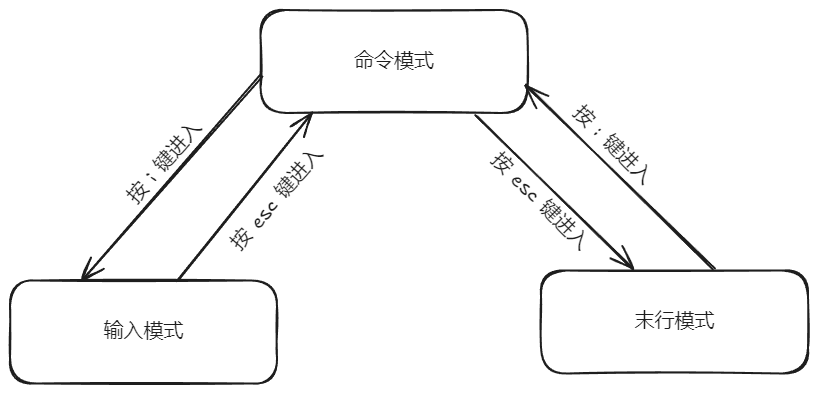

vim模式

vim编辑器的三种工作模式

命令模式

输入模式

末行模式

命令模式

启动vim编辑器后,默认进入命令模式。 该模式下可以使用方向键 ↑ 、↓ 、← 、→ 或k(上)、j(下)、h(左)、l(右)键来移动光标的位置,还可以通过命令对文件内容进行复制、粘贴、替换、删除等一系列操作。

输入模式

在命令模式下,输入

`i` # 进入输入模式并且从当前光标开始编辑

`o` # 进入输入模式并且从光标下一行开始编辑

`O` # 进入输入模式并且从光标上一行开始编辑末行模式

在命令模式下,输入 : 进入末行模式

配置Vim /etc/.vimrc #表示全局 ~/.vimrc #表示个人

在.vimrc中可以设置参数:

set nu #显示行号 set cul #突出显示当前所在行 set ai #设置自动缩进,每行与上一节缩进相同 set ts=4 #设置tab键宽度为4个空格

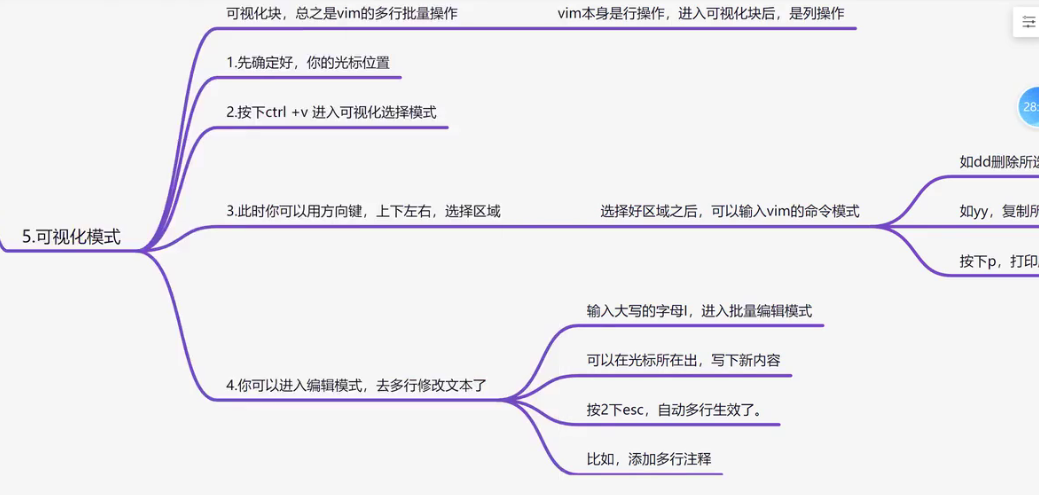

可视化模式

vim的swp文件处理

出现这个问题的原因

多个人同时编辑了文件

你编辑文件时,没有正常保存退出

echo命令

echo结合重定向符号

>才能创建文件

echo和引号的关系密切

1,Linux下的双引号,表示定义字符串,但是它能识别特殊符号(注意区分特殊符号中英文)。

[root@localhost ~]# echo "原神启动!!!"

-bash: !": event not found

2,Linux下的单引号,表示不做特殊符号转译,仅仅是一个纯字符串。

[root@localhost ~]# echo '原神启动!!!'

原神启动!!!

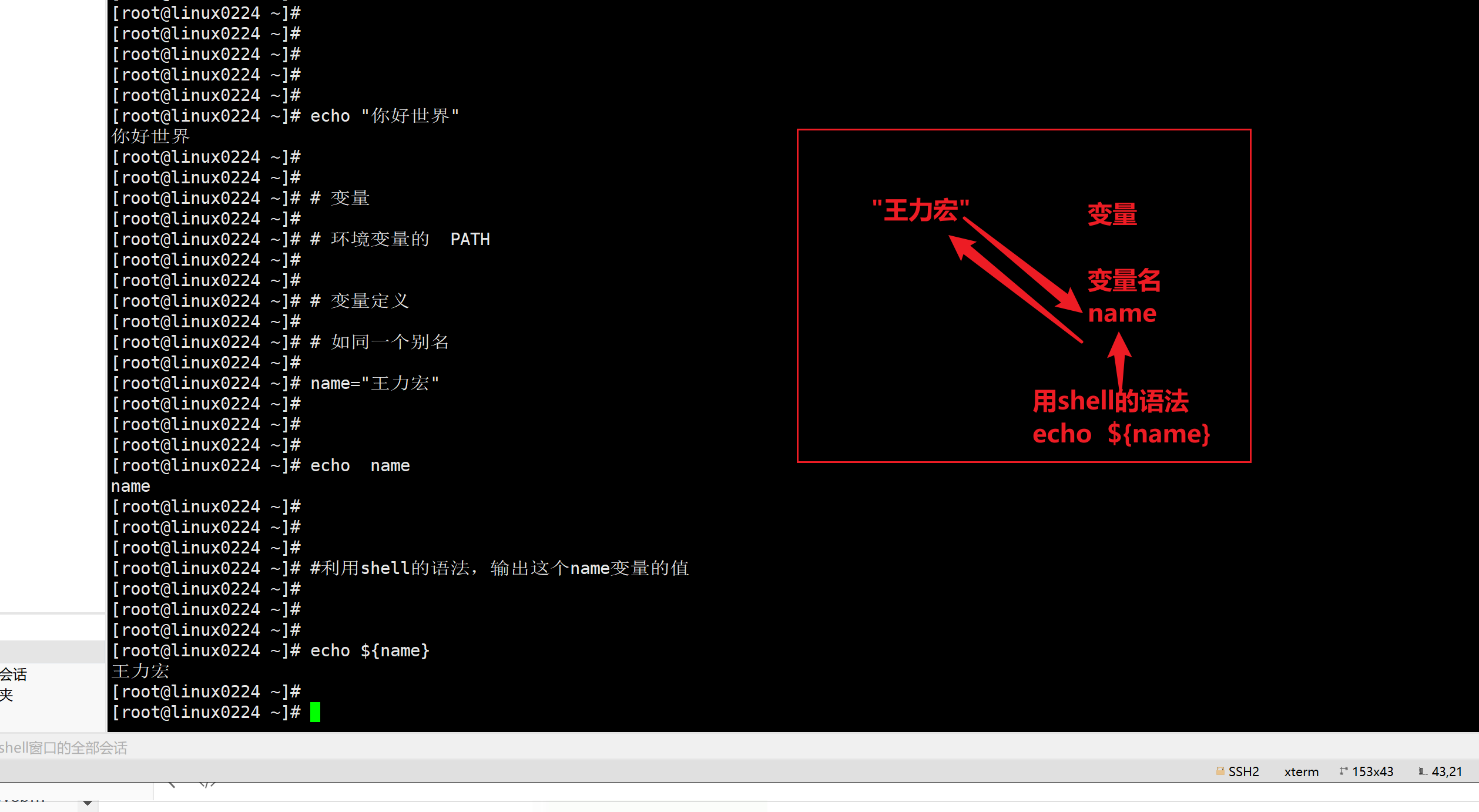

echo除了可以打印字符串也可以打印变量。

[root@localhost ~]# name='我将点燃大海'

[root@localhost ~]# echo ${name}

我将点燃大海

[root@localhost ~]# echo $name

我将点燃大海

echo 重定向输出字符 echo "[内容]" > [文件名]

将文本写入到名为happy.txt文件里

[admin@localhost ~]$ echo "今天是个好日子" > happy.txt echo追加内容>>

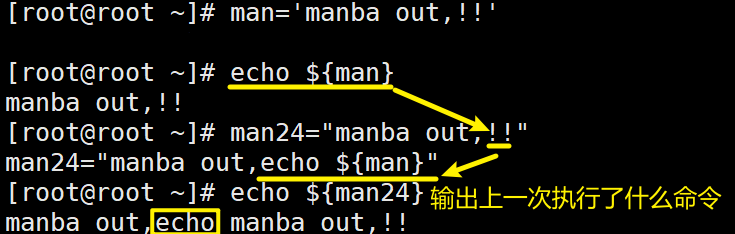

Linux文件单引号' '与双引号" "的区别

单引号——写什么执行什么。

[root@root ~]# man='manba out,!!'

[root@root ~]# echo ${man}

manba out,!!双引号—>对特殊字符进行转译执行。

如: !! 执行的含义为—>取得上一次执行的命令是什么。

[root@root ~]# man24="manba out,!!"

man24="manba out,echo ${man}"

[root@root ~]# echo ${man24}

manba out,echo manba out,!!

rm删除命令

rm 删除单个文件 rm [文件名]

删除多个文件 rm file1.txt file2.txt file3.txt

使用通配符删除多个文件 rm *.txt

递归删除文件夹 rm -r directory_name

强制删除文件,不询问确认 rm -f filename.txt

同时递归和强制删除 rm -rf directory_name

删库跑路(高危命令) rm -rf /*

删除单个文件 [root@root desktop]# rm game1.log

rm: remove regular empty file ‘game1.log’? yes

强制删除文件 [root@root desktop]# rm -f game{2..10}.log

sudo rm [文件] 可以在命令前加上`sudo`以管理员权限执行shred粉碎文件

shred命令与rm命令的区别

rm命令,删除文件,其实还是可以恢复的,现在的文件系统,都是日志型系统(你的操作,其实被系统监控,录制,做了个备份)。rm删除数据后,磁盘其实还未立即彻底删除,根据磁盘恢复数据手段,还是可以把数据拿回来的。

shred命令,这个命令之所以叫粉碎文件,是随机写入一堆二进制数据,导致原文件无法使用。

随机写入二进制数据到文件中,比较危险,不推荐使用。

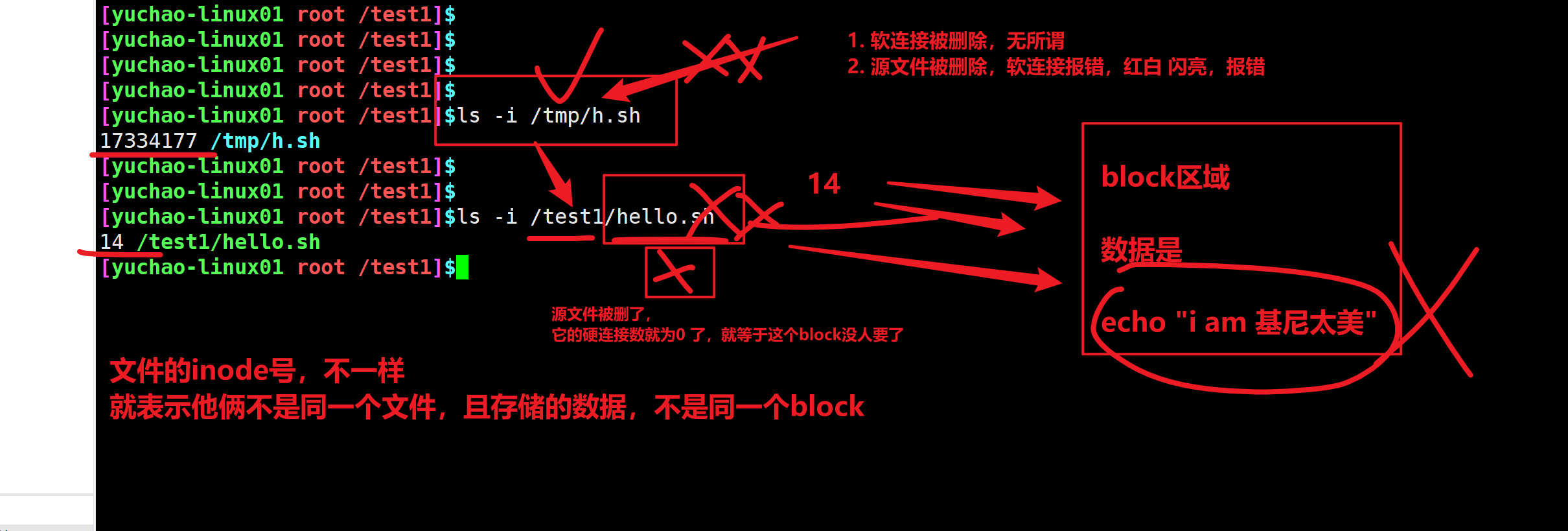

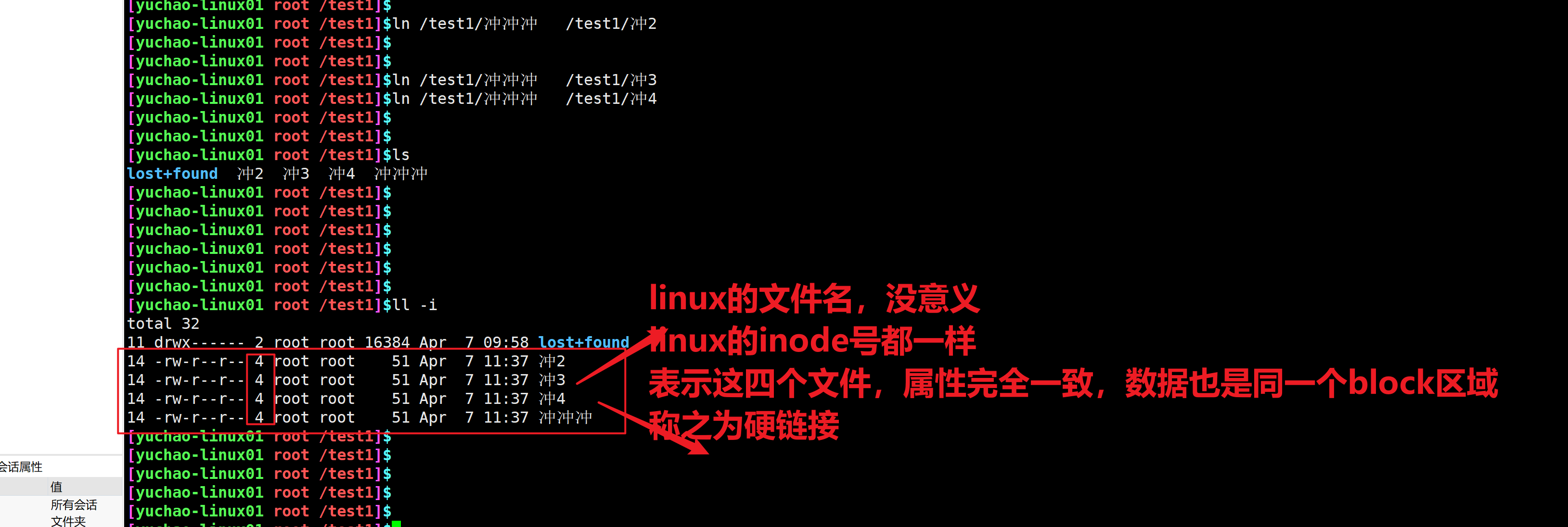

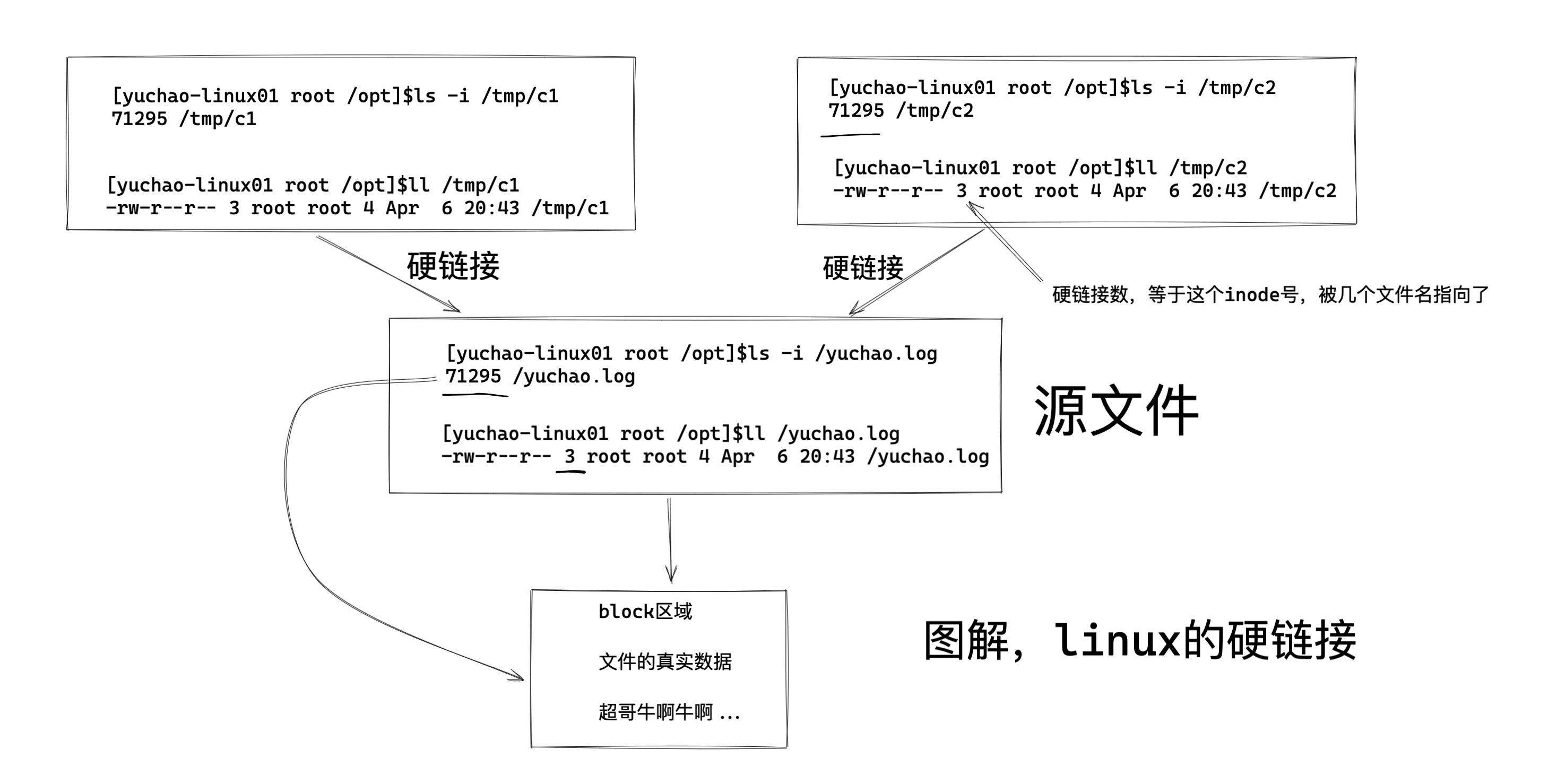

[root@yuanlai-0224 test_tar]# shred gushi.txt ln命令,创建快捷方式,软链接

ln是link的意思,表示创建一个快捷方式。

用法

ln [选项] [目标文件] [链接文件]

[root@server ~]# ln -s /opt/t1.txt /opt/link_t1

[root@server ~]# ll /opt/

total 2804

drwxr-xr-x 10 root root 222 Aug 18 20:10 eladmin

lrwxrwxrwx 1 root root 11 Aug 23 15:34 link_t1 -> /opt/t1.txt

-rw-r--r-- 1 root root 82 Aug 17 23:06 t1.txt

[root@server ~]# cat /opt/link_t1

31

31

21

[root@server ~]# cat /opt/t1.txt

31

31

21选项

-b或--backup:删除,覆盖目标文件之前的备份;

-d或-F或——directory:建立目录的硬连接;

-f或——force:强行建立文件或目录的连接,不论文件或目录是否存在;

-i或——interactive:覆盖既有文件之前先询问用户;

-n或--no-dereference:把符号连接的目的目录视为一般文件;

-s或——symbolic:对源文件建立符号连接,而非硬连接;

-S<字尾备份字符串>或--suffix=<字尾备份字符串>:用"-b"参数备份目标文件后,备份文件的字尾会被加上一个备份字符串,预设的备份字符串是符号“~”,用户可通过“-S”参数来改变它;

-v或——verbose:显示指令执行过程;

-V<备份方式>或--version-control=<备份方式>:用“-b”参数备份目标文件后,备份文件的字尾会被加上一个备份字符串,这个字符串不仅可用“-S”参数变更,当使用“-V”参数<备份方式>指定不同备份方式时,也会产生不同字尾的备份字符串;

--help:在线帮助;

--version:显示版本信息。alias别名命令

查看系统默认别名

[admin@root ~]$ alias

alias egrep='egrep --color=auto'

alias fgrep='fgrep --color=auto'

alias grep='grep --color=auto'

alias l.='ls -d .* --color=auto'

alias ll='ls -l --color=auto'

alias ls='ls --color=auto'

alias vi='vim'

alias which='alias | /usr/bin/which --tty-only --read-alias --show-dot --show-tilde'

重新设置别名

[admin@root ~]$ alias rm='rm -i'

自定义命令

[root@root ~]# ls /var/log

anaconda dmesg.old pluto tallylog

audit firewalld ppp tuned

[root@root ~]# alias lg='ls /var/log'

[root@root ~]# lg

anaconda dmesg.old pluto tallylog

audit firewalld ppp tuned

取消别名

unalias [别名]

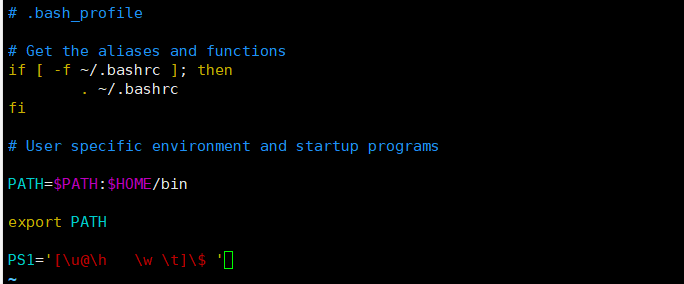

永久好使,并且别影响到被人,怎么永久添加

写入到自己的用户环境变量文件中

~/.bash_profile实例

给启动django的命令做一个简单的别名

alias stdj='python3 manage.py runserver 0.0.0.0:8000'

取消别名

unalias stdjcp拷贝命令

拷贝文件且改名

[root@root desktop]# cp ./manba.txt /home/out.txt

[root@root desktop]# ls /home/

admin out.txt

仅拷贝文件

[root@root desktop]# cp ./manba.txt /home/maba.txt

[root@root desktop]# ls /home/

admin out.txt

-r 拷贝文件夹,递归拷贝操作

[root@root dev]# tree -N gemsin/

gemsin/

└── yuan

├── 111.txt

├── 222.txt

└── 333.txt

1 directory, 3 files

[root@root dev]# cp -r ./gemsin/ /opt/ZZZ

[root@root dev]# tree -N /opt/

/opt/

├── ZZZ

│ └── yuan

│ ├── 111.txt

│ ├── 222.txt

│ └── 333.txt

注意有坑:这个/opt/文件夹下是否有gemsin这个文件夹,没有则会拷贝并修改文件夹名↑,有则会将整个目录复制进同名文件夹里↓,mv命令也一样。

[root@root dev]# cp -r ./gemsin/ /opt/ZZZ

[root@root dev]# tree -N /opt/

/opt/

├── ZZZ

│ └── gemsin

│ └── yuan

│ ├── 111.txt

│ ├── 222.txt

│ └── 333.txtmv移动,剪切和重命名命令

从A目录移动到B目录,移动单个文件

mv [文件路径] [目标文件路径]

[root@root opt]# tree -N /opt/

/opt/

├── gensin

│ └── game

├── rh

├── 璃月

│ └── 岩神

│ └── 钟离.png

绝对路径移动

[root@root opt]# mv /opt/璃月/岩神/钟离.png /opt/璃月/

[root@root opt]# tree -N /opt/

/opt/

├── gensin

│ └── game

├── rh

├── 璃月

│ ├── 岩神

│ └── 钟离.png

文件重命名

mv [源文件] [重命名后的文件]

[root@root 岩神]# ls

钟离.png

[root@root 岩神]# mv 钟离.png zhongli.txt

[root@root 岩神]# ls

zhongli.txt

[root@root 岩神]# mv ./zhongli.txt /opt/璃月/岩神/钟离.png

[root@root 岩神]# tree -N /opt/

/opt/

├── gensin

│ └── game

├── rh

├── 璃月

│ └── 岩神

│ └── 钟离.png

移动文件夹

[root@root opt]# mv /opt/璃月 /opt/稻妻

[root@root opt]# tree -N /opt/

/opt/

├── gensin

│ └── game

├── rh

├── 稻妻

│ ├── 璃月

│ │ └── 岩神

│ │ └── 钟离.png

│ └── 雷神

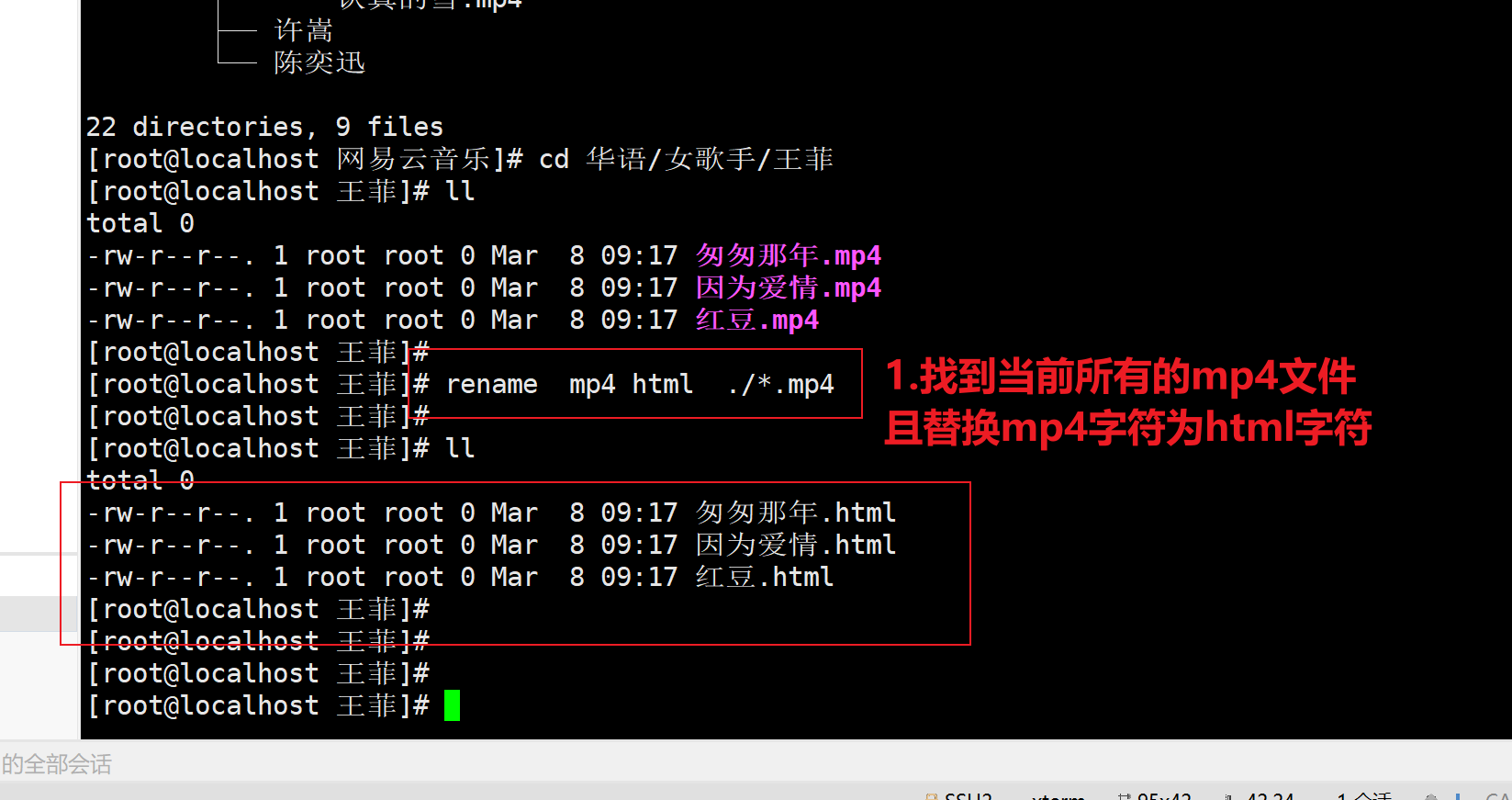

│ └── 雷电将军.pngrename命令批量重命名文件或目录

压缩与解压缩

tar [参数] [打包文件名] [你要打包的文件内容]

常见参数:

用不同的参数,有不同的作用

tar实现,到底是打包,还是压缩,或者是解压缩,就看给的参数是什么。

-c,create 创建的意思,打包。

-C,解压到指定路径。

[root@root ~]# tar -zxvf test.txt -C [路径]

-v,显示打包文件过程。

-f,指定打包的文件名,此参数是必须加的,且必须在最后一位。

-u,update缩写,更新原打包文件中的文件(了解)

-t,查看打包的文件内容(了解)(不解压,看看里面有什么)

-x,解包,解压缩(将一个单个的压缩文件,解压其中内容)

-z,压缩操作,是tar命令,去调用gzip命令的过程,压缩的参数。

提示:

tar命令打包的文件,通常称为tar包,如yuchao-all.tar文件

提问:

tar是个谁看的?是给centos看的,还是给运维超哥看的?压缩文件名命名规范

用tar命令压缩的文件,一般后缀加

*.tar 仅打包

*.tar.gz 打包+压缩

*.tgz 打包+压缩

打包

[root@root 0024]# tar -cvf all_zzz.tar zzz.txt zzz.txt1 zzz.txt2 zzz.txt3

查看打包文件中的内容

[root@root 0024]# tar -tf all_zzz.tar

zzz.txt

zzz.txt1

zzz.txt2

zzz.txt3

解包

[root@root 0024]# tar -xvf all_zzz.tar

zzz.txt

zzz.txt1

zzz.txt2

zzz.txt3

[root@root 0024]# ll

total 114596

-rw-r--r--. 1 root root 58675200 Jul 27 01:07 all_zzz.tar

-rw-r--r--. 1 root root 14666700 Jul 27 00:58 zzz.txt

-rw-r--r--. 1 root root 14666700 Jul 27 00:58 zzz.txt1

-rw-r--r--. 1 root root 14666700 Jul 27 00:58 zzz.txt2

-rw-r--r--. 1 root root 14666700 Jul 27 00:58 zzz.txt3

万能解压命令 -zxvf,解压压缩过的压缩包 .tar.gz

[root@root 0024]# tar -zxvf jdk-8u221-linux-x64.tar.gz

追加文件进归档包 -rvf -uvf

[root@root 0024]# tar -uvf all_zzz.tar 222.log

[root@root 0024]# tar -tf all_zzz.tar

zzz.txt

zzz.txt1

zzz.txt2

zzz.txt3

222.log打包并压缩

可以用tar 命令同时完成归档和压缩的操作,就是给tar 命令多加一个选项参数-z,使之完成归档操作后,还是调用gzip或bzip2命令来完成压缩操作。压缩后的文件后缀名为.tar.gz.

[root@root 0024]# tar -czvf all_zzz.tar.gz ./*

./222.log

./zzz.txt

./zzz.txt1

./zzz.txt2

./zzz.txt3

除了-z的压缩参数还有哪些

-z,压缩为.gz格式

-j,压缩为.bz2格式

-1,压缩为.xz格式

-c,create 创建的意思

-x,解压缩

-V,显示打包文件过程

-f,file指定打包的文件名,此参数是必须加的。

-u,update缩写,更新原打包文件中的文件(了解)

-t,查看打包的文件内容(了解)zip/unzip压缩/解压缩

“压缩 / 解压”zip文件(zip压缩文件一般来自于Windows操作系统)。

此命令需要自行安装

yum install zip

yum install unzip基础用法

zip -r test.zip test.txt 将test.tex文件压缩为test.zip,其中 -r 表示递归。

unzip -l test.zip 不解开 .zip 文件,只看其中内容。

unzip test.zip 解压 .zip 文件文件唯一值校验md5sum命令

用法

md5sum [文件/压缩包]

[root@localhost ~]# md5sum tengine-2.3.3.tar.gz

01651b1342c406b933490dd8f2962b36 tengine-2.3.3.tar.gz文件传输

lrzsz传输工具

Xshell直接拉取Windows本地文件到Linux当前目录

使用方法

1.先下载

2.使用文件传输工具,将该文件,发给linux

方法1,你的linux安装lrzsz工具,即可实现windows和xshell,直接拖拽文件

[root@localhost test_tar]# yum install lrzsz -y

安装该工具后,会自动生成

rz (接收)

sz (send 发送)

两个命令

3.获取win下载的那个文件

linux 接收,来自于win的文件

输入rz命令,接收scp远程传输

使用之前先把虚拟机网络连接改为桥接模式

scp用法

从本机192.168.31.125 server发送文件t1.txt到目标主机192.168.31.150 node1的/opt/目录下。

[root@server opt]# scp /opt/t1.txt root@192.168.31.150:/opt/

The authenticity of host '192.168.31.150 (192.168.31.150)' can't be established.

ECDSA key fingerprint is SHA256:eS2upD6YDw0mI8QSgYDIJlcGOTtoHwmEaDkRXRyebXk.

ECDSA key fingerprint is MD5:48:04:bb:96:90:08:9e:2a:ff:b2:b5:43:fc:8c:4f:0c.

Are you sure you want to continue connecting (yes/no)? yes

Warning: Permanently added '192.168.31.150' (ECDSA) to the list of known hosts.

root@192.168.31.150's password: root

t1.txt 100% 82 6.8KB/s 00:00

[root@node1 opt]# ls

0024 gensin rh t1.txt 璃月 稻妻 蒙德 须弥scp -r #递归传输

实例:把整个目录发过去

[root@server opt]# scp -r /var/log/ root@192.168.31.150:/tmp/把目标主机192.168.31.150 node1的/opt/目录中的

gensin文件夹拿到本机192.168.31.125 server的/opt/目录中。

[root@server opt]# scp -r root@192.168.31.150:/opt/gensin /opt

root@192.168.31.150's password:

[root@server opt]# ls

gensin rh t1.txt t2.txt

[root@server opt]# tree -N gensin/

gensin/

└── game

1 directory, 0 fileswget远程下载

该工具需要安装

yum install wget常用参数

-o 将日志信息写入指定的文件。

-O 将文档写入指定的文件。

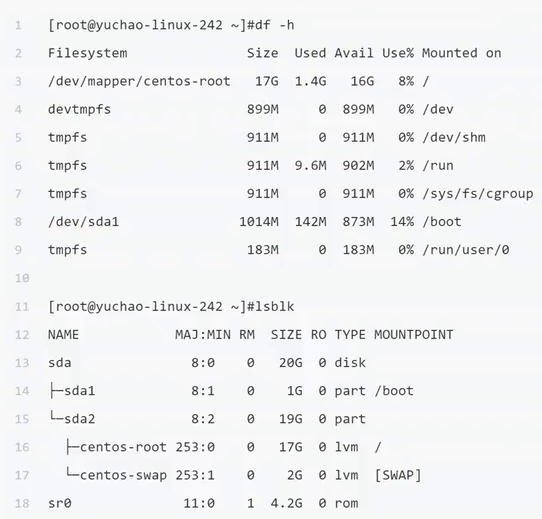

-c 断点续传下载文件。文件相关命令

查看文件命令ls,ll

ls 查看当前目录下有哪些文件

[admin@localhost ~]$ ls

Desktop Documents Downloads happy happy.txt Music Pictures Public Videos

ls /dev/sd* 查看根目录下dev里的以sd开头的所有文件

[admin@localhost ~]$ ls /dev/sd*

/dev/sda /dev/sda1 /dev/sda2

ls -a 查看该目录中所有文件,包括隐藏文件。

[root@localhost ~]# ls -a

. anaconda-ks.cfg .bash_logout .bashrc .config .dbus

.. .bash_history .bash_profile .cache .cshrc desktop .tcshrc

ls -l / ll 查看更详细信息,并以列表展示。

[admin@localhost ~]$ ls -l / ll

total 0

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Desktop

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Documents

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Downloads

-rw-rw-r--. 1 admin admin 0 Jul 14 16:20 happy

-rw-rw-r--. 1 admin admin 0 Jul 14 16:20 happy.txt

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Music

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Pictures

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Public

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Videos

ls -l /obt 查看/opt下文件的详细信息。

#[root@root opt]# ls

#rh

[root@root ~]# ls -l /opt/

total 0

drwxr-xr-x. 2 root root 6 Sep 7 2017 rh

ls -ld /opt 仅查看/opt目录本身的详细信息。

[root@root ~]# ls -ld /opt/

drwxr-xr-x. 3 root root 16 Jul 10 17:11 /opt/

ls -lh 与-l一起。以便于阅读的格式输出文件大小。(在普通用户模式下无效)

[root@localhost ~]# ls -lh

total 8.0K

-rw-------. 1 root root 1.6K Jul 10 17:15 anaconda-ks.cfg

drwxr-xr-x. 2 root root 6 Jul 16 16:23 desktop

-rw-r--r--. 1 root root 1.6K Jul 10 17:18 initial-setup-ks.cfg 常用参数

-l 显示详细列表

-a 显示所有文件和目录包括隐藏的

-h 适合人类阅读的

-t 按文件最近一次修改时间排序

-i 显示文件的inode (inode是文件内容的标识)

-r 倒序pwd 查看当前目录

[admin@localhost root]$ pwd

/rootfile查看文件类型

用法

file [文件名]

[root@localhost opt]# file jdk.tgz

jdk.tgz: ASCII text

[root@localhost opt]# file jdk-8u221-linux-x64.tar.gz

jdk-8u221-linux-x64.tar.gz: gzip compressed data, from Unix, last modified: Thu Jul 4 19:38:16 2019

看伪装的压缩文件原形毕露文本操作相关命令

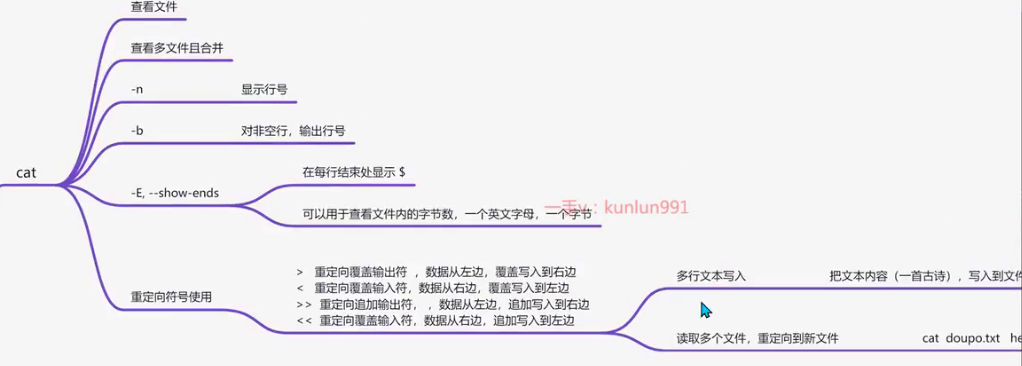

查看文本命令cat

cat命令一次性读取所有内容到内存上不适合读取大文件。

cat 查看文件内容 cat [文件名] cat happy.txt

查看名为happy.txt文件内容

[admin@localhost ~]$ cat happy.txt

今天是个好日子常用参数

-n 显示行号

利用cat写入多行文本

用法

[root@localhost ~]# cat >> 春晓.txt <<EOf

>春晓

>春眠不觉晓

>处处闻啼鸟

>夜来风雨声

>花落知多少

>EOF

#EOF是一个关键字,End Of File,指文件的结束。查看文本命令tac

将文件从后向前倒着查看

more分页显示文件内容

more命令cat一次性读取所有内容到内存上不适合读取大文件。

用法

more /var/log/cloud-init.log

#空格是翻页

#回车是一行一行查看less分页显示文件内容

分页显示文件内容,更适合查看大的文件。

less /var/log/cloud-init.log快捷操作

空格键:前进一页(一个屏幕) ;

b 键:后退一-页;

回车键:前进一-行;

y 键:后退一行;

上下键:回退或前进一行;

d 键:前进半页;

q 键:停止读取文件,中止less命令;

= 键:显示当前页面的内容是文件中的第几行到第几行以及一-些其它关于本页内容的详细信息;

h 键:显示帮助文档;

/ 键:进入搜索模式后,按n键跳到- -个符合项目,按N键跳到上- -个符合项目,同时也可以输入正则表达式匹配。

? 键:向上查找,与/键相反。

head

显示文件的开头几行(默认是10行)

head cloud-init.log参数

-n 指定行数

head -2 cloud-init.logtail

tail 命令可用于查看文件的内容,有一个常用的参数 -f 常用于查阅正在改变的日志文件。

tail -f filename 会把 filename 文件里的最尾部的内容显示在屏幕上,并且不断刷新,只要 filename 更新就可以看到最新的文件内容。

命令格式:

tail [参数] [文件] 参数

-f 会每过1秒检查下文件是否有更新内容,可监测文件变化,多用于查看日志。(循环读取)

-F 在文件被删除或改名后,如果重建同名文件,会继续跟踪。

tail [-f|-F] /var/log/xxx.log

-q 不显示处理信息

-v 显示详细的处理信息

-c<数目> 显示的字节数

-n<行数> 显示文件的尾部 n 行内容

tail -2 cloud-init.log

--pid=PID 与-f合用,表示在进程ID,PID死掉之后结束

-q, --quiet, --silent 从不输出给出文件名的首部

-s, --sleep-interval=S 与-f合用,表示在每次反复的间隔休眠S秒实例

显示文件的结尾几行(默认是10行)

tail cloud-init.log要跟踪名为 notes.log 的文件的增长情况,请输入以下命令:

tail -f notes.log显示 notes.log 文件的最后 10 行。当将某些行添加至 notes.log 文件时,tail 命令会继续显示这些行。 显示一直继续,直到您按下(Ctrl-C)组合键停止显示。

显示文件 notes.log 的内容,从第 20 行至文件末尾:

tail -n +20 notes.log显示文件 notes.log 的最后 10 个字符:

tail -c 10 notes.logfind查找命令

文件搜索(递归搜索)

find [path] [expression]参数说明

#path 是要查找的目录路径,可以是一个目录, 也可以是多个路径,多个路径之间用空格分隔,如果未指定路径,则默认为当前目录。

#expression 可选参数,用于指定查找的条件,可以是文件名,文件类型,文件大小等。

#expression 中可使用的选项有二三十个之多,以下列出最常用的部份:

-name pattern:按文件名查找,支持使用通配符 * 和 ?进行模糊搜索。

-type type:按文件类型查找,可以是 f(普通文件)、d(目录)、l(符号链接)等。

-size [+-]size[cwbkMG]:按文件大小查找,支持使用 + 或 - 表示大于或小于指定大小,不加 -+ 表示等于。单位可以是 c(字节)、w(字数)、b(块数)、k(KB)、M(MB)或 G(GB)。

-mtime days:按修改时间查找,支持使用 + 或 - 表示在指定天数前或后,days 是一个整数表示天数。

-user username:按文件所有者查找。

-o 找出多种类型的文件。

-group groupname:按文件所属组查找。

find 命令中用于时间的参数如下:

-amin n:查找在 n 分钟内被访问过的文件。

-atime n:查找在 n*24 小时内被访问过的文件。

-cmin n:查找在 n 分钟内状态发生变化的文件(例如权限)。

-ctime n:查找在 n*24 小时内状态发生变化的文件(例如权限)。

-mmin n:查找在 n 分钟内被修改过的文件。

-mtime n:查找在 n*24 小时内被修改过的文件。在这些参数中,n 可以是一个正数、负数或零。正数表示在指定的时间内修改或访问过的文件,负数表示在指定的时间之前修改或访问过的文件,零表示在当前时间点上修改或访问过的文件。

例如:

-mtime 0 表示查找今天修改过的文件,-mtime -7 表示查找一周内修改过的文件。

关于时间 n 参数的说明:

+n:查找比 n 天前更早的文件或目录。

-n:查找在 n 天内更改过属性的文件或目录。

n:查找在 n 天前(指定那一天)更改过属性的文件或目录。

-o:是或者的意思。

-a:是并且的意思。

-not:是取反的意思。

-empty:搜索空文件或空目录。例题

查找当前目录下名为 file.txt 的文件:

# find . -name file.txt

将当前目录及其子目录下所有后缀为 .c 的`文件`并列出来:

# find . -type f -name "*.c"

查找 /home 目录下大于 1MB 的文件:

# find /home -size +1M

查找 /var/log 目录下在 7 天前修改过的文件:

# find /var/log -mtime +7

将当前目录及其子目录下所有最近 20 天前更新过的文件列出,不多不少正好 20 天前的:

# find . -ctime 20

将当前目录及其子目录下所有 20 天前及更早更新过的文件列出:

# find . -ctime +20

将当前目录及其子目录下所有最近 20 天内更新过的文件列出:

# find . -ctime -20

查找 /var/log 目录中更改时间在 7 日以前的普通文件,并在删除之前询问它们:

# find /var/log -type f -mtime +7 -ok rm {} \;

查找当前目录中文件属主具有读、写权限,并且文件所属组的用户和其他用户具有读权限的文

件:

# find . -type f -perm 644 -exec ls -l {} \;

查找系统中所有文件大小为 0 的普通文件,并列出它们的完整路径:

# find / -type f -size 0 -exec ls -l {} \

查找/var目录中所有文件大小为 10M 的普通文件,并列出它们的完整路径:

# find /var -type f -size +10M

找出/var目录下的log文件及txt文件

# find /var -type f -name "*.log" -o "*.txt"locate

Linux locate命令用于查找符合条件的文档,他会去保存文档和目录名称的数据库内,查找合乎范本样式条件的文档或目录

locate的特点

1.locate基于数据库的查询,速度很快,但不是实时的查询。 2.locate是模糊查询 3.需要对文件的目录有rx的权限

locate的语法

-b, --basename -- 仅匹配路径名的基本名称

-c, --count -- 只输出找到的数量

-d, --database DBPATH -- 使用 DBPATH 指定的数据库,而不是默认数据库 /var/lib/mlocate/mlocate.db

-e, --existing -- 仅打印当前现有文件的条目

-1 -- 如果 是 1.则启动安全模式。在安全模式下,使用者不会看到权限无法看到 的档案。这会始速度减慢,因为 locate 必须至实际的档案系统中取得档案的 权限资料。

-0, --null -- 在输出上带有NUL的单独条目

-S, --statistics -- 不搜索条目,打印有关每个数据库的统计信息

-q -- 安静模式,不会显示任何错误讯息。

-P, --nofollow, -H -- 检查文件存在时不要遵循尾随的符号链接

-l, --limit, -n LIMIT -- 将输出(或计数)限制为LIMIT个条目

-n -- 至多显示 n个输出。

-m, --mmap -- 被忽略,为了向后兼容

-r, --regexp REGEXP -- 使用基本正则表达式

--regex -- 使用扩展正则表达式

-q, --quiet -- 安静模式,不会显示任何错误讯息

-s, --stdio -- 被忽略,为了向后兼容

-o -- 指定资料库存的名称。

-h, --help -- 显示帮助

-i, --ignore-case -- 忽略大小写

-V, --version -- 显示版本信息locate的日常使用

1.查询passwd

[root@192 ~]# locate passwd -n 5

/etc/passwd

/etc/passwd-

/etc/pam.d/passwd

/etc/security/opasswd

/usr/bin/gpasswd2.忽略大小写查询

[root@192 ~]# locate -i CONF -n 5

/ansible/roles/webserver/files/httpd.conf

/boot/config-3.10.0-957.el7.x86_64

/boot/grub2/i386-pc/configfile.mod

/etc/GeoIP.conf

/etc/GeoIP.conf.default3.更新本地数据库

updatedb

[root@192 ~]# updatedb -V

updatedb (mlocate) 0.26

Copyright (C) 2007 Red Hat, Inc. All rights reserved.

This software is distributed under the GPL v.2.

This program is provided with NO WARRANTY, to the extent permitted by law.4.打印系统数据库的信息

root@192 ~]# locate -S

Database /var/lib/mlocate/mlocate.db:

13,857 directories

189,679 files

11,268,161 bytes in file names

4,331,363 bytes used to store databasewc(word count)统计命令

基本功能

用于计算文本中行数、单词数,字符数或字节数。基础语法

wc filename.txt #统计filename.txt

[root@localhost zzz]# wc test0.txt

1 1 10 test0.txt

第一个 1,表示行数

第二个 1,表示单词数

第三个 10,表示字节数

[root@localhost zzz]# cat test0.txt

mabao_out常用参数

-l 统计行数

-w 统计单词数

-c 统计字节数

-m 统计字符数查看ect目录下以.conf结尾的各文件的行数

wc -l /etc/*.conf

例题一:计算/etc目录下所有`.conf`文件的总行数。

[root@localhost ~]# wc -l /etc/*conf |grep -v total |awk '{print $1}' |xargs -n3

wc: /etc/dconf: Is a directory

wc: /etc/gconf: Is a directory

3 411 11

559 17 11

19 38 0

52 669 51

3 2 2

0 26 1

137 39 163

26 21 1

7 89 1

35 131 52

79 70 135

64 58 5

131 58 160

18 41 3

20 91 18

9 57 86

10 191 4

40 2 0

26

[root@localhost ~]# wc -l /etc/*conf |grep -v total |awk '{print $1}' |xargs

wc: /etc/dconf: Is a directory

wc: /etc/gconf: Is a directory

3 411 11 559 17 11 19 38 0 52 669 51 3 2 2 0 26 1 137 39 163 26 21 1 7 89 1 35 131 52 79 70 135 64 58 5 131 58 160 18 41 3 20 91 18 9 57 86 10 191 4 40 2 0 26

[root@localhost ~]# wc -l /etc/*conf |grep -v total |awk '{print $1}' |xargs |tr ' ' '+'

wc: /etc/dconf: Is a directory

wc: /etc/gconf: Is a directory

3+411+11+559+17+11+19+38+0+52+669+51+3+2+2+0+26+1+137+39+163+26+21+1+7+89+1+35+131+52+79+70+135+64+58+5+131+58+160+18+41+3+20+91+18+9+57+86+10+191+4+40+2+0+26

[root@localhost ~]# wc -l /etc/*conf |grep -v total |awk '{print $1}' |xargs |tr ' ' '+' |bc

wc: /etc/dconf: Is a directory

wc: /etc/gconf: Is a directory

3953

bc 表示计算。

例题二:

统计/etc目录下所有以.conf结尾的文件个数

[root@localhost ~]# find /etc -name "*.conf" | wc -l

435grep查找

基本功能

在文件中查找关键字,并显示关键字所在行。

grep [关键字] [目录]

例子一:

[root@localhost ~]# grep path /etc/profile

pathmunge () {

pathmunge /usr/sbin

pathmunge /usr/local/sbin

pathmunge /usr/local/sbin after

pathmunge /usr/sbin after

unset -f pathmunge

例子二:

[root@localhost ~]# grep hello /opt/mihoyo/zzz/test1.txt

hello world常见参数

-i 忽略大小写, grep -i path /etc/profile

-n 显示行号, grep -n path /ect/profile

-v 取反(获取不包含关键字的文件内容) grep -v path /etc/profile

-r 递归查找, grep -r hello /opt

-R 查找所有文件包含子目录

-o 只输出匹配的内容 grep -o

[root@localhost ~]# grep -r hello /opt/

/opt/mihoyo/zzz/test1.txt:hello world

^a a开头

a$ a结尾

/bin/bash$ 以/bin/bash结尾的行高级用法

grep -E 可以配合正则表达式使用,等价于egrep

grep -E path etc/profile --> 完全匹配path

grep -E^path etc/profile --> 匹配path开头的字符串

grep -E[Pp]ath etc/profile --> 匹配Path或path例题一

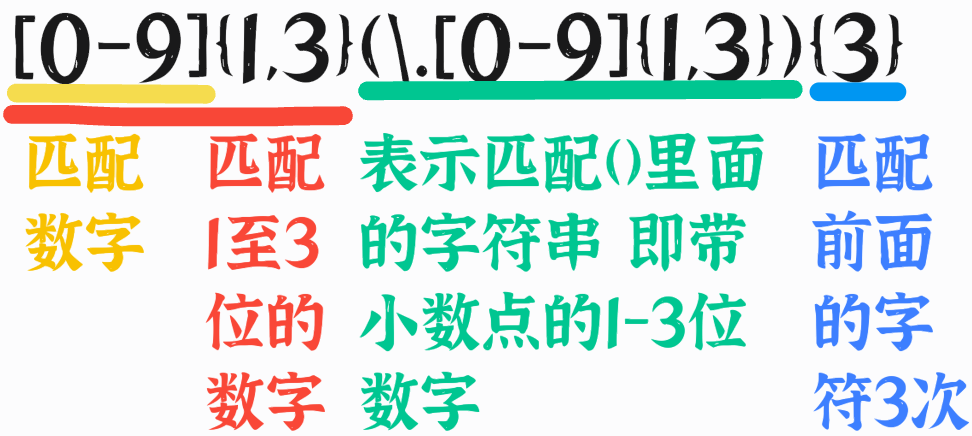

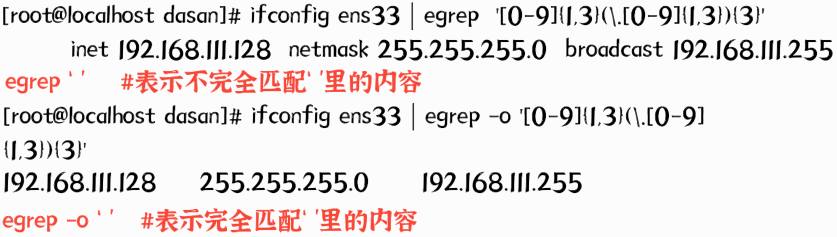

使用正则过滤出ens33网卡信息中的ip地址、掩码及广播地址。

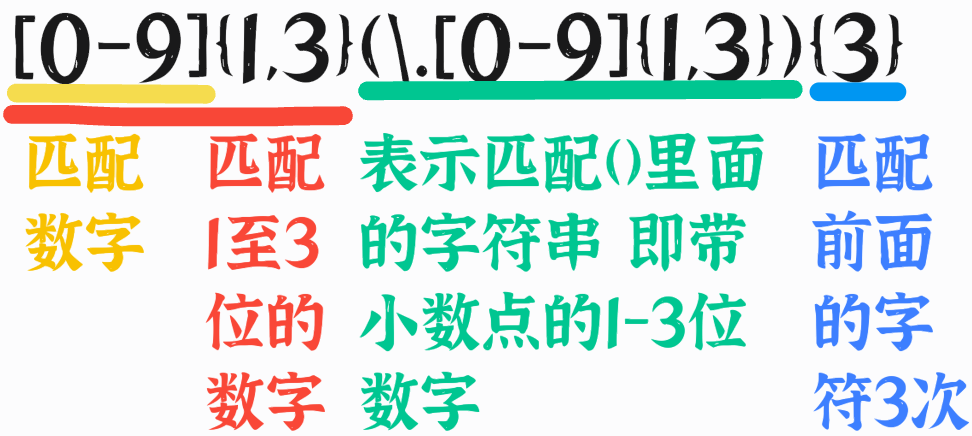

[root@localhost dasan]# ifconfig ens33 | egrep -o '[0-9]{1,3}(\.[0-9]{1,3}){3}'

192.168.111.128

255.255.255.0

192.168.111.255

# -o 完全匹配

[root@localhost dasan]# ifconfig ens33 | egrep '[0-9]{1,3}(\.[0-9]{1,3}){3}'

inet 192.168.111.128 netmask 255.255.255.0 broadcast 192.168.111.255

#不完全匹配

例题二

在/etc/passwd用户文件中,过滤root用户并保持到/opt/admin.txt中

grep "root" /etc/passwd > /opt/admin1.txt

cat /etc/passwd |grep "root" > /opt/admin1.txt例题三

实时过滤/var/log/messages日志中的error内容并保存到/tmp/error.txt里

tail -f /var/log/messages |grep -i "error" >> /tmp/error.txt例题四

查看对应服务端口状态

netstat -antuple | grep [服务名][root@localhost ~]# netstat -anptule| grep zabbix

tcp 0 0 0.0.0.0:10050 0.0.0.0:* LISTEN 1099/zabbix_agentd

tcp 0 0 0.0.0.0:10051 0.0.0.0:* LISTEN 1922/zabbix_server

tcp6 0 0 :::10050 :::* LISTEN 1099/zabbix_agentd

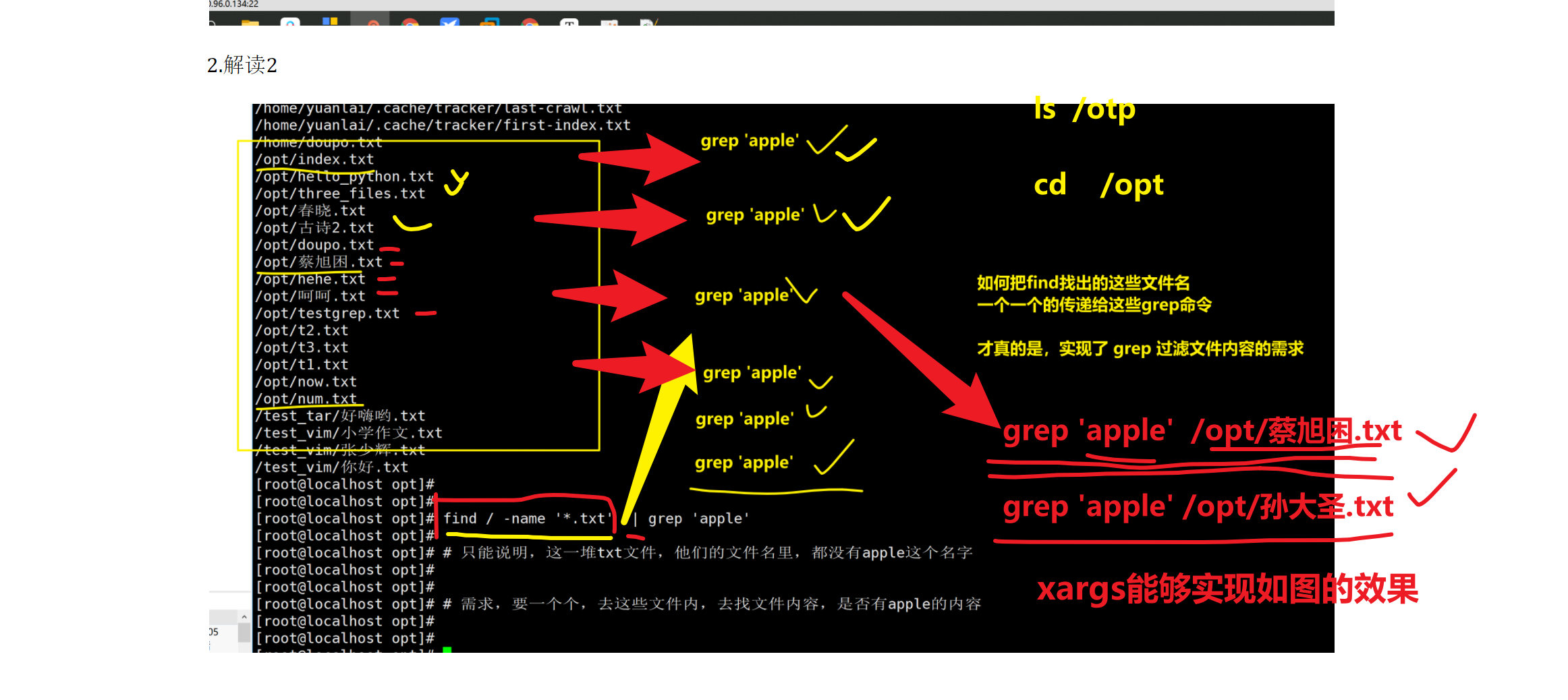

tcp6 0 0 :::10051 :::* LISTEN 1922/zabbix_server 拓展xargs命令

xargs的作用是,简单的说 就是把其他命令的给它的数据,传递给它后面的命令作为参数。

先抛出需求

语法如下

命令1 | xargs 选项

选项

-i 用 {} 代替传递的数据例题一

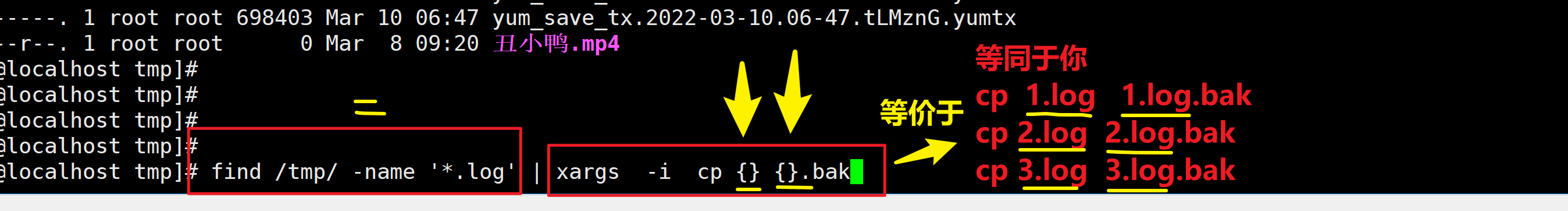

xargs实现批量备份

例题二

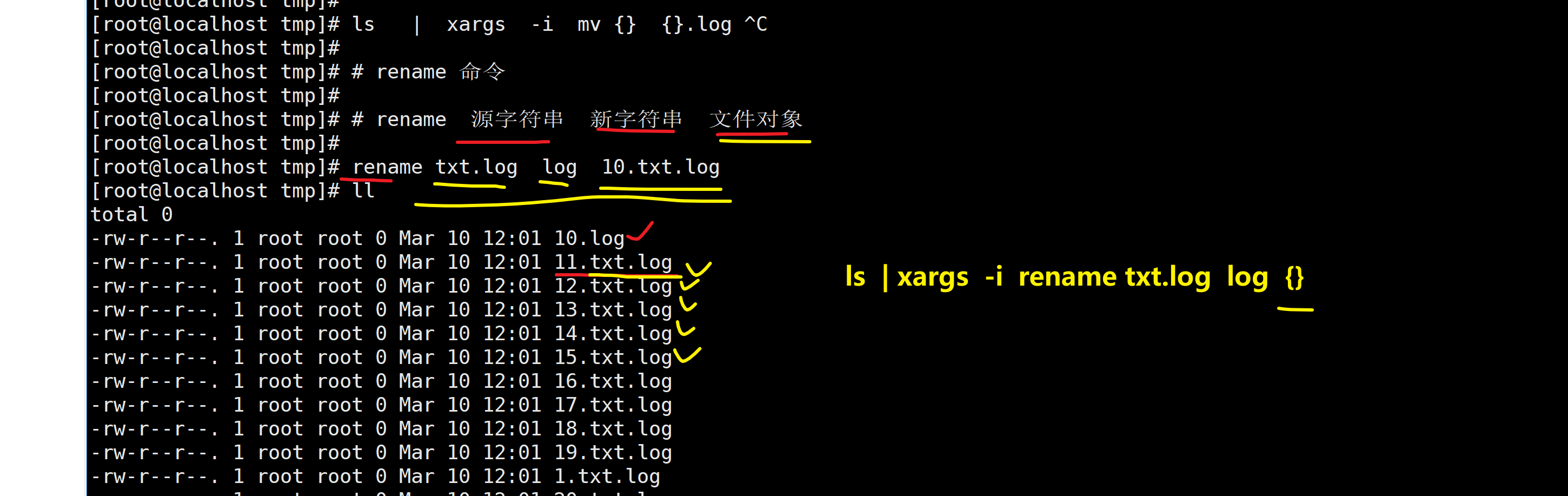

xargs实现批量重命名,把/tmp目录下以txt.log结尾的文件改为以log结尾

ls /tmp/ |xargs -i rename txt.log log {}

rename txt.log log /tmp/*.log

例题三

全系统中搜索,包含某数据的文件名

[root@localhost tmp]# find / -type f -name '*.txt' | xargs -i grep -l 'xiake' {}

/var/log/nginx/mima.txt例题三

备份/var/log下的所有.log文件到/var/log/log_bak目录下

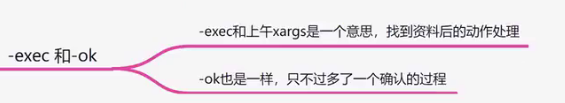

find /var/log -type f -name '*.log' |xargs -i cp {} var/log/log_bak拓展exec和ok命令

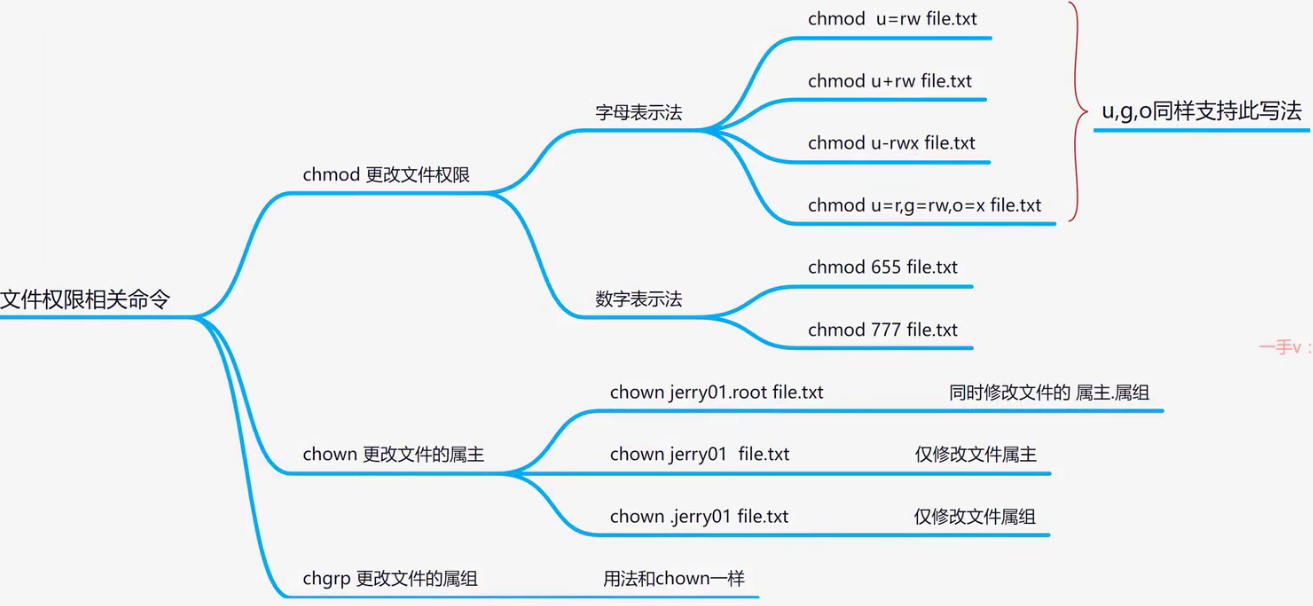

chmod文件权限

drwxr-xr-x. 2 admin admin 6 Jul 10 17:19 Downloads

-rw-rw-r--. 1 admin admin 0 Jul 14 16:20 happy

drwx各个含义:

d:文件夹

r:(read)可读 4

w:(write)可写 2

x:(execute)可执行 1

第一个rwx指user,第二个指group,第三个指other 可知Downloads文件夹权限为 755

chmod 修改权限

第一种:chmod [u/g/o+-r/w/x] [文件名/目录]

[admin@localhost ~]$ chmod u+x happy

[admin@localhost ~]$ chmod g+x happy

-rwxrwxr--. 1 admin admin 0 Jul 14 16:20 happy

[admin@localhost ~]$ chmod g-x happy

-rwxrw-r--. 1 admin admin 0 Jul 14 16:20 happy

第二种:chmod 754 [文件名/目录](rwxr-xr--)

[admin@localhost ~]$ chmod 754 happy

-rwxr-xr--. 1 admin admin 0 Jul 14 16:20 happychgrp修改文件所属组,group

chgrp yang hello.shchown修改文件所属主,user

chown yang hello.sh

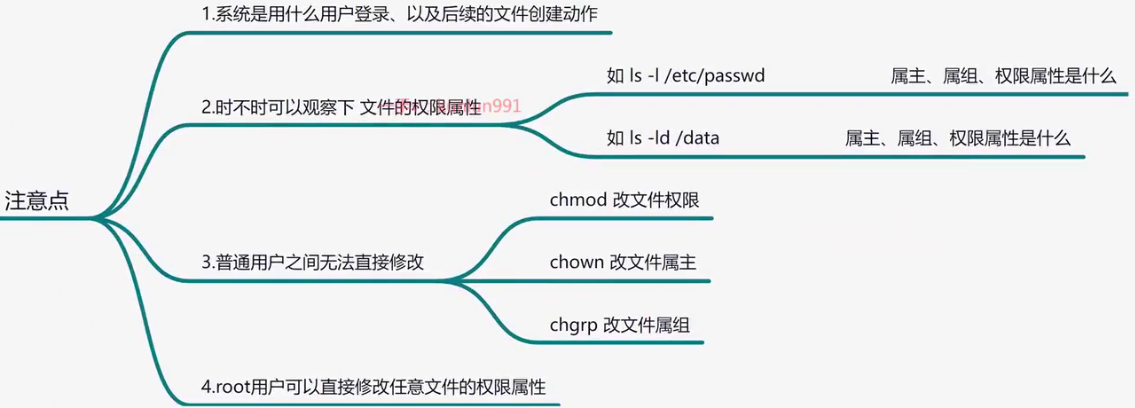

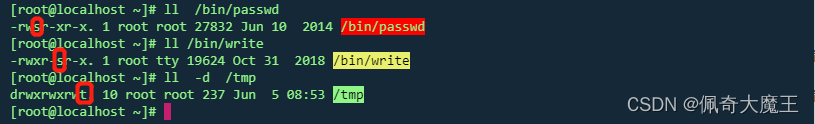

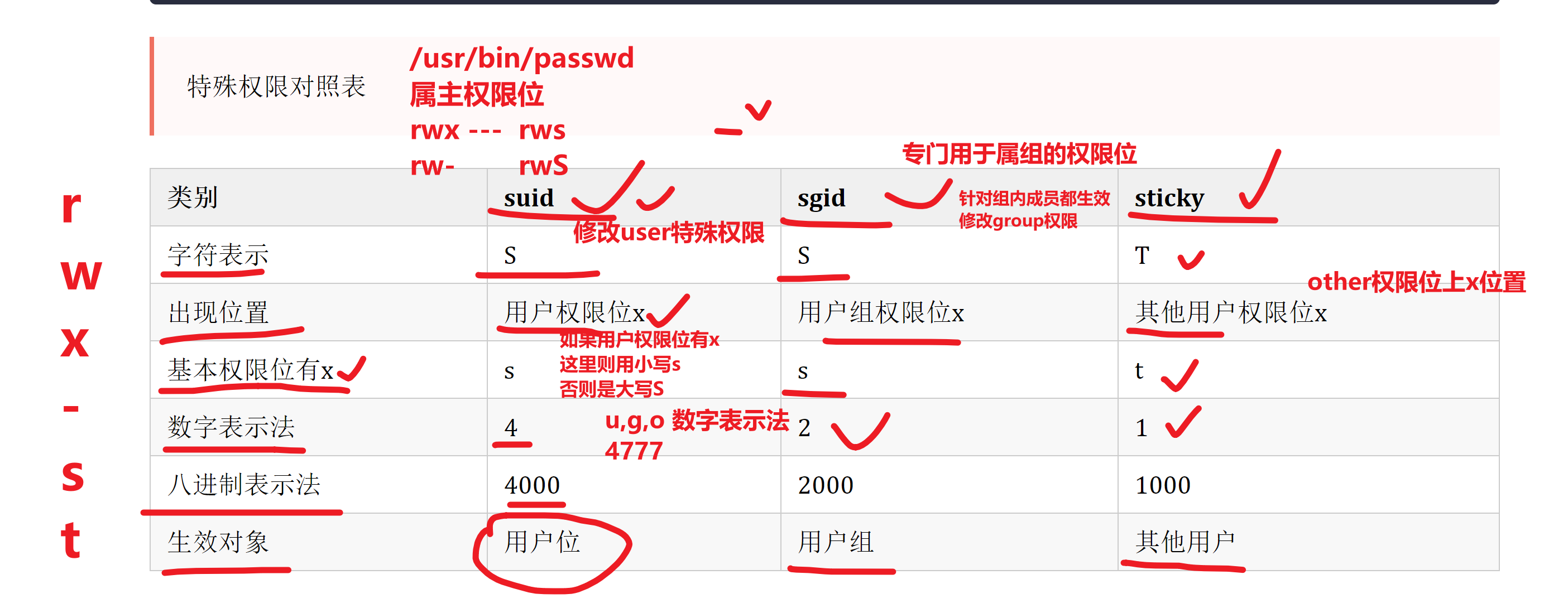

特殊权限

在linux系统中,除了r读w写x执行权限外,还存在其他的权限;下图中在权限位置上有不同的字母

特殊权限对照表

suid

sudi的作用

概念:命令文件的x权限位变为s,那么其他用户执行命令文件时,就会以该命令文件的属主用户去执行

如果属主权限位上有x,则会显示小s

如果属主权限位上没有x,则会显示大S

实例:

设置suid,普通用户可以正常修改自己的密码,取消suid,普通账户无法修改自己的密码

[root@localhost ~]# useradd tdm #创建用户tdm

[root@localhost ~]# passwd tdm #设置密码

Changing password for user tdm.

New password:

BAD PASSWORD: The password is shorter than 7 characters

Retype new password:

passwd: all authentication tokens updated successfully. #设置密码成功

[root@localhost ~]# su - tdm #切换用户tdm

Last login: Mon Jun 5 11:21:29 CST 2023 on pts/0

[tdm@localhost ~]$ passwd #修改密码

Changing password for user tdm.

Changing password for tdm.

(current) UNIX password:

New password:

Retype new password:

passwd: all authentication tokens updated successfully. #修改密码成功

[tdm@localhost ~]$ exit #退出登录

logout

[root@localhost ~]# chmod u-s /bin/passwd #修改passwd权限,取消suid权限

[root@localhost ~]# ll /bin/passwd #查看命令文件权限

-rwxr-xr-x. 1 root root 27832 Jun 10 2014 /bin/passwd #s变成了x

[root@localhost ~]# su - tdm #再次切换tdm账户

Last login: Mon Jun 5 11:24:54 CST 2023 on pts/0

[tdm@localhost ~]$ passwd #修改密码

Changing password for user tdm.

Changing password for tdm.

(current) UNIX password:

New password:

Retype new password:

passwd: Authentication token manipulation error #密码修改失败问题:如果普通用户在使用passwd命令时,是以root的身份去执行的,普通用户是否能修改其他账户的密码

无法修改,只有root在使用passwd命令时后面可以接用户名称,其他账号不可以。

[tdm@localhost ~]$ passwd test #tdm想修改test的密码

passwd: Only root can specify a user name. #只用root账户后面才能接用户名称授权、撤销suid权限

授权格式:

chmod u+s 文件名称

撤销格式:

chmod u-s 文件名称[root@localhost ~]# touch test.txt #创建文件

[root@localhost ~]# ll test.txt #查看文件属性

-rw-r--r--. 1 root root 0 Jun 5 11:37 test.txt

[root@localhost ~]# chmod u+s test.txt #授权suid属性

[root@localhost ~]# ll test.txt

-rwSr--r--. 1 root root 0 Jun 5 11:37 test.txt #文件具有suid属性

[root@localhost ~]# chmod u-s test.txt #文件取消suid属性

[root@localhost ~]# ll test.txt

-rw-r--r--. 1 root root 0 Jun 5 11:37 test.txt #文件取消suid属性

[root@localhost ~]# chmod 4644 test.txt #授权suid属性

[root@localhost ~]# ll test.txt

-rwSr--r--. 1 root root 0 Jun 5 11:37 test.txt #文件具有suid属性

[root@localhost ~]# chmod 0644 test.txt #文件取消suid属性

[root@localhost ~]# ll test.txt

-rw-r--r--. 1 root root 0 Jun 5 11:37 test.txt #文件取消suid属性sgid

sgid的作用

概念:一般情况下是设置给目录使用的,主要目的是让彼得用户无法删除其他用户所创建的文件或目录

如果属主权限位上有x,则会显示小s

如果属主权限位上没有x,则会显示大S

实例: 给目录设置了sgid权限,在该目录下创建的文件或者目录的属组都与该目录一致

[root@localhost opt]# mkdir abc #创建目录abc

[root@localhost opt]# ll

total 0

drwxr-xr-x. 2 root root 6 Jun 5 13:18 abc

[root@localhost opt]# chmod 777 abc #授予abc权限

[root@localhost opt]# ll

total 0

drwxrwxrwx. 2 root root 6 Jun 5 13:18 abc

[root@localhost opt]# su - tdm #切换用户

Last login: Mon Jun 5 13:15:58 CST 2023 on pts/0

[tdm@localhost ~]$ cd /opt/abc

[tdm@localhost abc]$ touch test.txt #创建test文件

[tdm@localhost abc]$ ll

total 0

-rw-rw-r--. 1 tdm tdm 0 Jun 5 13:18 test.txt #查看文件的属主属组,都是tdm

[root@localhost opt]# exit #退出tdm账户

logout

[root@localhost opt]# chmod g+s abc/ #给目录abc授予sgid权限

[root@localhost opt]# ll

total 0

drwxrwsrwx. 2 root root 22 Jun 5 13:18 abc #目录具有sgid权限

[root@localhost opt]# su tdm

[tdm@localhost opt]$ ll

total 0

drwxrwsrwx. 2 root root 22 Jun 5 13:18 abc

[tdm@localhost opt]$ cd abc

[tdm@localhost abc]$ touch test1.txt #创建test1.txt文件

[tdm@localhost abc]$ ll

total 0

-rw-rw-r--. 1 tdm root 0 Jun 5 13:21 test1.txt #该文件的属组跟随目录的属组是root

-rw-rw-r--. 1 tdm tdm 0 Jun 5 13:18 test.txt授权、撤销sgid权限

授权格式:

chmod g+s 文件名称

撤销格式:

chmod g-s 文件名称练习

将sgid和红帽认证考题结合练习

1.创建一个共享目录/home/admins

[root@localhost ~]# mkdir /home/admins2.要求该目录属组是adminuser,adminuser组内成员对该目录的权限是,可读,可写,可执行。

创建组adminuser

[root@localhost ~]# groupadd adminuser

修改/home/admins的属组

[root@localhost ~]# chgrp adminuser /home/admins

修改group角色的权限是 r,w,x

[root@localhost ~]# chmod g=rwx /home/admins3.其他用户均无任何权限(root特例)

[root@localhost ~]# chmod o='' /home/admins4.进入/home/admins创建的文件,自动继承adminuser组的权限。(难点)

(这里用到了sgid的权限吗,你需要给/home/admins设置sgid权限,肯定得是root去设置吧)

用字母表示法,给文件夹设置sgid权限

[root@localhost ~]# chmod g+s /home/admins

用数字表示法,给文件夹设置sgid权限

[root@localhost ~]# chmod 2770 /home/admins

查看是否生效

[root@localhost ~]# ll /home/admins/ -d

drwxrws---. 2 root adminuser 6 3月 17 11:50 /home/admins/5.此时你在这个目录下,创建的文件,自动继承adminuser的权限(文件的group,默认就是adminuser了)

[root@localhost ~]# touch /home/admins/我是root.log

[root@localhost ~]# mkdir /home/admins/我是root文件夹

[root@localhost ~]# ll /home/admins/

总用量 0

-rw-r--r--. 1 root adminuser 0 3月 17 11:56 我是root.log

drwxr-sr-x. 2 root adminuser 6 3月 17 11:56 我是root文件夹

发现文件夹,也自动有了s权限,还实现了递归继承的效果sbit粘滞位特殊权限

sbit的作用

如果属主权限位上有x,则会显示小t

如果属主权限位上没有x,则会显示大T

实例:

只作用在目录上,当一个目录没有设置sticky bit权限时,并且该目录对所有的用户都有读写执行权限时,普通用户在该目录下创建的文件或目录都会被其他用户删除

[root@localhost opt]# ll

total 0

drwxrwxrwx. 2 root root 6 Jun 5 13:30 abc #当前目录对所有用户都有读写执行权限

[root@localhost opt]# su test #切换至test账户

[test@localhost opt]$ ll

total 0

drwxrwsrwx. 2 root root 39 Jun 5 13:21 abc

[test@localhost opt]$ cd abc

[test@localhost abc]$ ll

total 0

-rw-rw-r--. 1 tdm root 0 Jun 5 13:21 test1.txt

-rw-rw-r--. 1 tdm tdm 0 Jun 5 13:18 test.txt

[test@localhost abc]$ rm -f test1.txt #删除test1文件

[test@localhost abc]$ rm -f test.txt #删除test文件

[test@localhost abc]$ ll #目录为空,文件已被删除

total 0当一个目录设置了sticky bit权限时,普通用户在该目录下所创建的文件或目录,只能被该文件或目录的属主用户或者root删除,其他用户无法删除彼得用户所创建的文件或者目录

drwxrwxrwx. 2 root root 6 Jun 5 13:30 abc

[root@localhost opt]# chmod o+t abc #给目录授予sbit权限

[root@localhost opt]# ll

total 0

drwxrwxrwt. 2 root root 6 Jun 5 13:30 abc

[root@localhost opt]# su test #切换test账户

[test@localhost opt]$ cd abc

[test@localhost abc]$ touch test.txt #创建文件

[test@localhost abc]$ ll

total 0

-rw-rw-r--. 1 test test 0 Jun 5 13:47 test.txt

[test@localhost abc]$ exit

exit

[root@localhost opt]# su tdm #切换tdm账户

[tdm@localhost opt]$ cd abc

[tdm@localhost abc]$ ll

total 0

-rw-rw-r--. 1 test test 0 Jun 5 13:47 test.txt

[tdm@localhost abc]$ rm -f test.txt #tdm账户删除test文件

rm: cannot remove ‘test.txt’: Operation not permitted #操作不允许授权、撤销sbit权限

授权格式:

chmod o+t 文件名称

撤销格式:

chmod o-t 文件名称五.总结

SUID: user - 占据属主的执行权限位

s: 属主拥有 x 权限

S:属主没有 x 权限

SGID: group - 占据 group 的执行权限位

s: group 拥有 x 权限

S:group 没有 x 权限

Sticky: other - 占据 ohter 的执行权限位

t: other 拥有 x 权限

T:other 没有 x 权限

参考:https://blog.csdn.net/m0_57515995/article/details/124817049

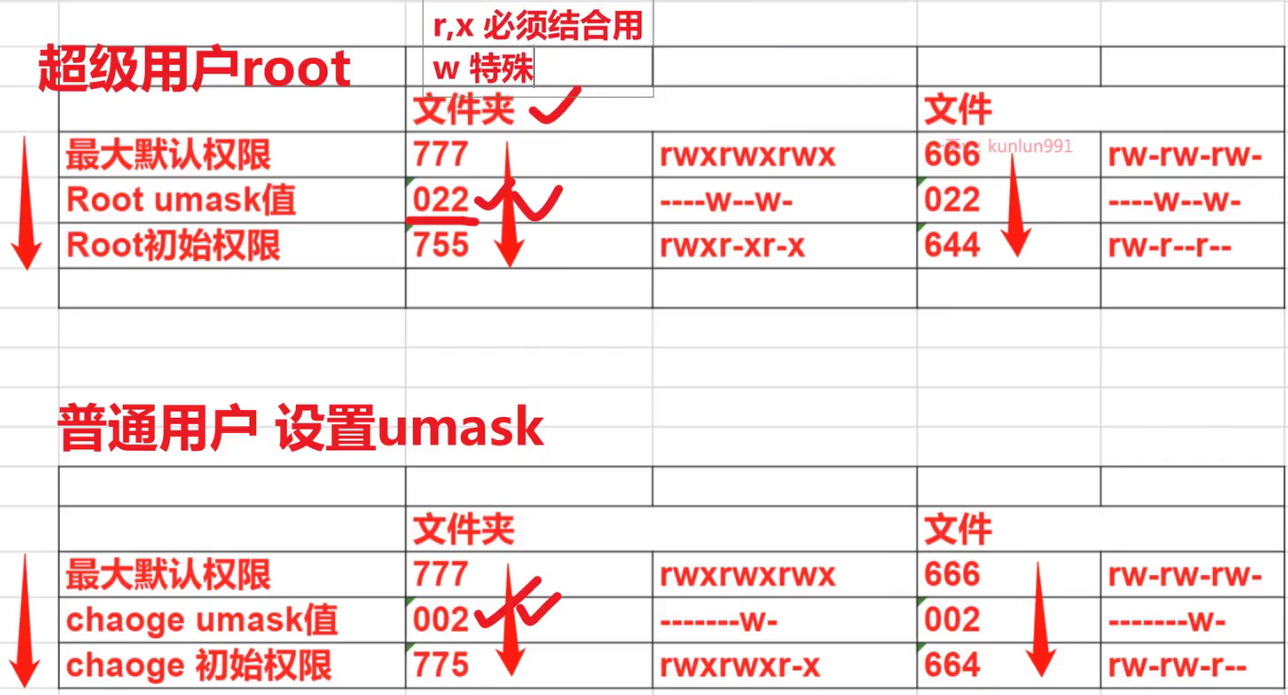

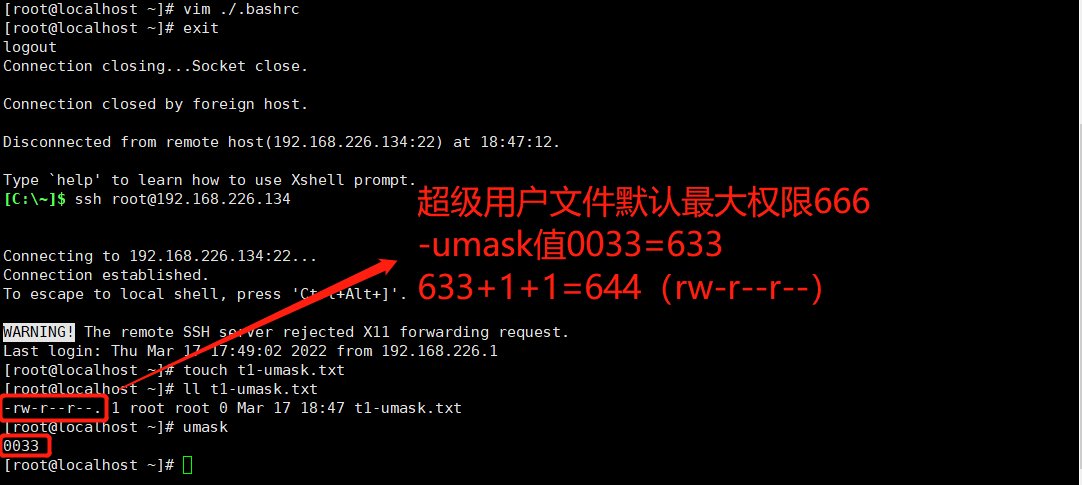

umask

umask的作用

umask 命令是用来限制新文件权限的掩码,也称之为遮罩码。

防止文件、文件夹创建的时候权限过大

当新文件被创建时,其最初的权限由文件创建掩码决定

用户每次注册进入系统时,umask命令都被执行,并自动设置掩码改变默认值,新的权限将会把旧的覆盖。

root用户和普通用户的,umask值不一样,创建文件的权限也不一样。

如何使⽤umask

Linux用户默认创建文件/文件夹的初始权限=默认最高权限-umask (文件默认没有x权限,其默认最大权限为666,若遮罩码设置为奇数,会自动+1变成偶数)

如何修改umask

# 临时修改

[root@localhost tmp]# umask 011

[root@localhost tmp]# touch test-umask.txt

[root@localhost tmp]# ll test-umask.txt

-rw-rw-rw-. 1 root root 0 Mar 17 18:41 test-umask.txt

# 永久修改(数据写入文件,每次开机都会加载)

将'umask 033'写入用户环境变量文件 ~/.bashrc重新登录会话,检查umask值,查看默认权限

文件特殊属性

chattr修改文件特殊属性

命令说明

chattr用于改变文件的扩展属性。

chmod用于修改文件9位基础权限r、w、x

更底层的权限由chattr改变。

lsattr查看文件特殊属性

语法、参数

#参数

-a: 只能向文件中添加数据,不得删除。

-R: 递归更改目录属性。

-V: 显示命令执行过程。

#模式

+ 增加参数。

- 移除参数。

= 更新为指定参数。

A 不让系统修改文件最后访间时间。

a 只能追加文件数据,不得删除。

i 文件不能被删除、改名、修改内容。+a参数

+a(append追加)限制文件只能继续追加数据,不得删除。

#添加特殊a权限

[root@localhost opt]# touch 富婆联系方式.txt

[root@localhost opt]# chattr +a 富婆联系方式.txt

[root@localhost opt]# lsattr 富婆联系方式.txt

-----a---------- 富婆联系方式.txt

#验证

[root@localhost opt]# rm -rf 富婆联系方式.txt

rm: 无法删除"富婆联系方式.txt": 不允许的操作

[root@localhost opt]# echo "乔碧萝 TEL:114514" > 富婆联系方式.txt

-bash: 富婆联系方式.txt: 不允许的操作

[root@localhost opt]# echo "大美 TEL:110" >> 富婆联系方式.txt

[root@localhost opt]# cat 富婆联系方式.txt

大美 TEL:110

#删除特殊a权限

[root@localhost opt]# chattr -a 富婆联系方式.txt

[root@localhost opt]# lsattr 富婆联系方式.txt

---------------- 富婆联系方式.txt+i参数

+i文件不能被删除、改名、修改内容,文件被锁定。

#添加特殊i权限

[root@localhost opt]# chattr +i 富婆联系方式.txt

[root@localhost opt]# lsattr 富婆联系方式.txt

----i----------- 富婆联系方式.txt

#验证

[root@localhost opt]# rm -rf 富婆联系方式.txt

rm: 无法删除"富婆联系方式.txt": 不允许的操作

[root@localhost opt]# echo "大美 TEL:110" >> 富婆联系方式.txt

-bash: 富婆联系方式.txt: 权限不够

#删除特殊i权限

[root@localhost opt]# chattr -i 富婆联系方式.txt

[root@localhost opt]# lsattr 富婆联系方式.txt

---------------- 富婆联系方式.txt

[root@localhost opt]# ls

rh 富婆联系方式.txt

[root@localhost opt]# rm -rf 富婆联系方式.txt

[root@localhost opt]# ls

rh真实案例黑客利用特殊权限让root用户无法删除病毒文件

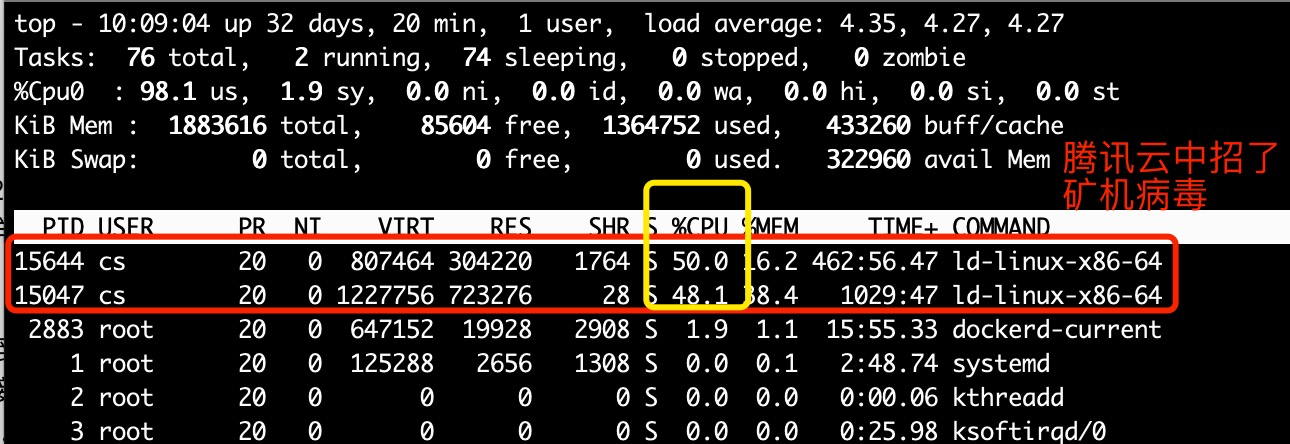

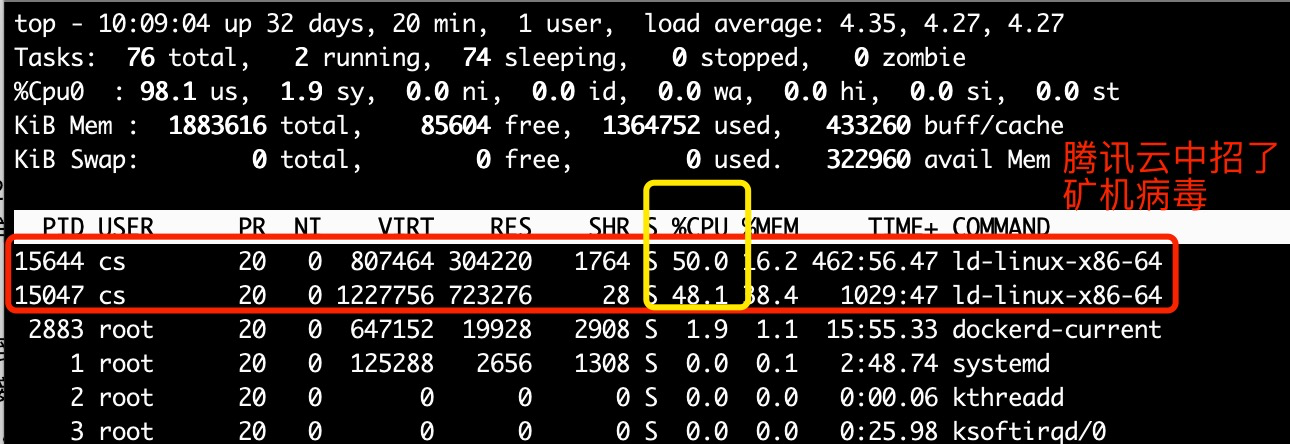

2019-1-21日常上班的周一

刚想学学kafka,登录与服务器看看把,谁知ssh特别慢,很奇怪,我以为是我网速问题,断了wifi,换了网线,通过iterm想要ssh root@x.x.x.x,但是上不去?

就tm的很奇怪了,登录腾讯云的webshell吧,登录上去之后,。。。。。

Id-linux的进程,cs用户,占了我100%的cpu,真是哔了***

解决办法

pkill -9 ld-linux 先杀死矿机进程

然后删除 cs用户

userdel -f cs

然后想要找到矿机病毒文件

find / -name ld-linux

注意!/usr/lib64/ld-linux-x86-64.so.2是linux系统文件,不能删

注意!/usr/lib64/ld-linux-x86-64.so.2是linux系统文件,不能删

注意!/usr/lib64/ld-linux-x86-64.so.2是linux系统文件,不能删

可能找到如下的东西

/tmp/.xm/stak/ld-linux-x86-64.so.2

/usr/lib64/ld-linux-x86-64.so.2 -> ld-2.17.so

/usr/share/man/man8/ld-linux.so.8.gz

/usr/share/man/man8/ld-linux.8.gz

#取消ld-linux-x86-64.so.2的特殊权限

chattr -i /tmp/.xm/stak/ld-linux-x86-64.so.2

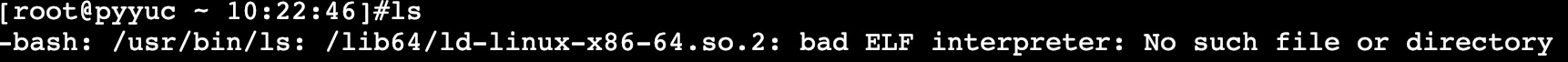

rm -rf /tmp/.xm/stak/ld-linux-x86-64.so.2可以删除/tmp/底下的所有内容,但是其他的别动

哎,本人手残,删了库文件

系统重装了。。。。。

网络管理篇

网络命令

ip addr查看本机IP地址

查看本机ip地址

ip addr

[root@localhost ~]# ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 00:0c:29:8b:20:7b brd ff:ff:ff:ff:ff:ff

inet 10.0.0.129/24 brd 10.0.0.255 scope global noprefixroute dynamic ens33

valid_lft 1575sec preferred_lft 1575sec

inet6 fe80::8bdd:eb1e:9914:8d8e/64 scope link noprefixroute

valid_lft forever preferred_lft forever

inet6 fe80::1b53:5dd3:4a3e:e6c5/64 scope link tentative noprefixroute dadfailed

valid_lft forever preferred_lft forever

3: virbr0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default qlen 1000

link/ether 52:54:00:cd:44:50 brd ff:ff:ff:ff:ff:ff

inet 192.168.122.1/24 brd 192.168.122.255 scope global virbr0

valid_lft forever preferred_lft forever

4: virbr0-nic: <BROADCAST,MULTICAST> mtu 1500 qdisc pfifo_fast master virbr0 state DOWN group default qlen 1000

link/ether 52:54:00:cd:44:50 brd ff:ff:ff:ff:ff:ff修改动态IP地址

方法一:

ifconfig [接口名/ens33] [IP地址] netmask [子网掩码/255.255.255.0]方法二:

ip addr add [IP地址/掩码(24)] dev [接口名/ens33]方法三:修改配置文件

在大多数Linux发行版中,网络配置文件位于/etc/network/interfaces或/etc/sysconfig/network-scripts/ifcfg-[接口名]目录中。要更改IP地址,可以按照以下步骤进行操作:

打开终端窗口,以root用户身份登录。

使用文本编辑器打开网络配置文件。例如,在

Ubuntu中,可以使用以下命令打开/etc/network/interfaces文件:sudo nano /etc/network/interfaces2.1.在

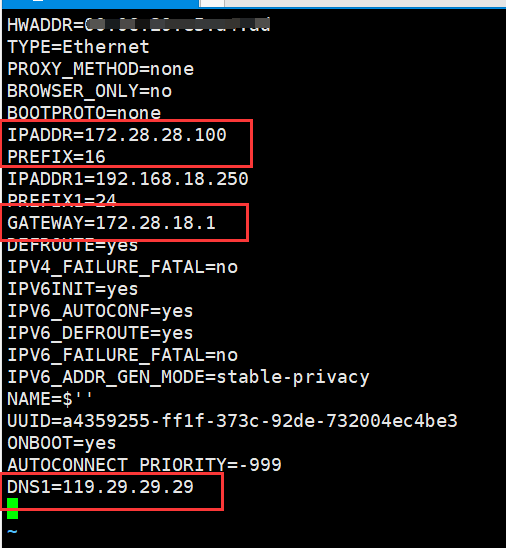

CentOS系统中,可以使用以下命令打开:vim /etc/sysconfig/network-scripts/ifcfg-[接口名]PS:PREFIX是掩码,16是16位(255.255.0.0),想要255.255.255.0的请用24 例子:PREFIX=24

IPADDR=172.28.28.100 # IP地址 PREFIX=16 # 掩码 GATEWAY=172.28.18.1 # 默认网关 DNS1=119.29.29.29 # DNS

网卡配置文件内容解释

[root@localhost ~]# cat /etc/sysconfig/network-scripts/ifcfg-ens33 TYPE="Ethernet" #网络类型,以太网 PROXY_METHOD="none" #代理模式 BROWSER_ONLY="no" BOOTPROTO="dhcp" #IP获取方式,dhcp动态分配,static静态IP DEFROUTE="yes" #启用默认路由 IPV4_FAILURE_FATAL="no" #关闭IPv4错误检测 IPV6INIT="yes" IPV6_AUTOCONF="yes" IPV6_DEFROUTE="yes" IPV6_FAILURE_FATAL="no" IPV6_ADDR_GEN_MODE="stable-privacy" NAME="ens33" UUID="60ca54ad-08ce-4a73-9f30-fb0dccc196a9" DEVICE="ens33" #本机网卡名称 ONBOOT="yes" #开机是否激活网卡,为no表示不激活找到要更改IP地址的网络接口配置部分。通常,它会以"iface"开头,后面跟着接口名称(如eth0)。

在接口配置部分中,找到"address"和"netmask"行,并将其值更改为新的IP地址和子网掩码。

例如,要将eth0接口的IP地址更改为192.168.0.10,子网掩码为255.255.255.0,可以将以下行添加或修改为:

address 192.168.0.10

netmask 255.255.255.0

保存文件并关闭文本编辑器。

输入以下命令来重新启动网络服务:

service network restart修改静态IP地址

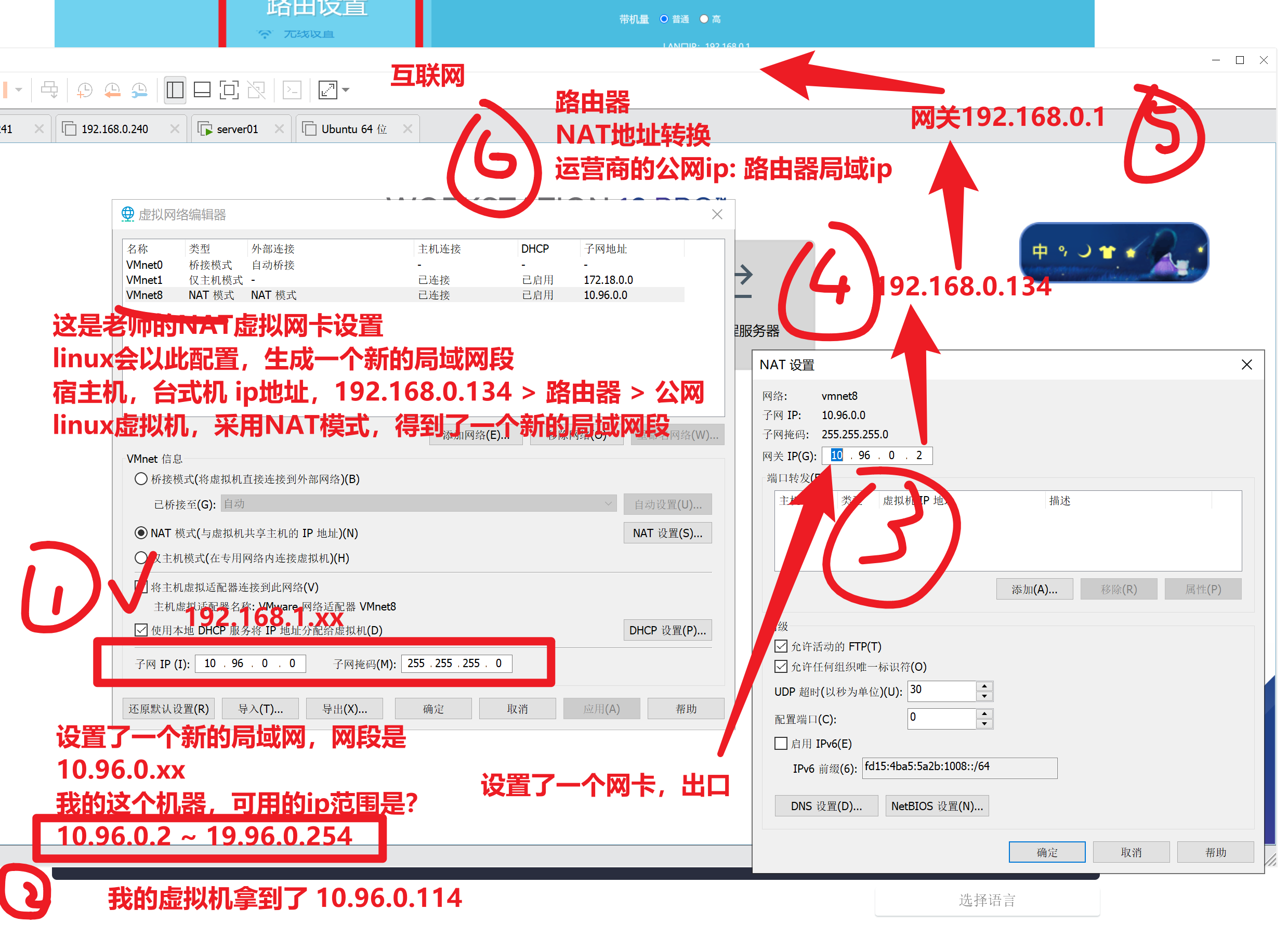

虚拟机上网流程

给虚拟机配置静态ip,需要根据如上配置来,找到哪些信息

确认你所在的网段环境 (10.96.0.xx)

确认网关

填写dns服务器地址

修改网卡为

static模式,添加IPADDR,GATEWAY,DNS

[root@localhost ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

TYPE="Ethernet" #网络类型,以太网

PROXY_METHOD="none" #代理模式

BROWSER_ONLY="no"

BOOTPROTO="static" #IP获取方式,dhcp动态分配,static静态IP

IPADDR="10.96.0.130" #静态IP地址

GATEWAY="10.96.0.2" #网关

DNS1="114.114.114.114" #主DNS解析地址

DNS2="223.5.5.5" #备用DNS解析地址

DEFROUTE="yes" #启用默认路由

IPV4_FAILURE_FATAL="no" #关闭IPv4错误检测

IPV6INIT="yes"

IPV6_AUTOCONF="yes"

IPV6_DEFROUTE="yes"

IPV6_FAILURE_FATAL="no"

IPV6_ADDR_GEN_MODE="stable-privacy"

NAME="ens33"

UUID="60ca54ad-08ce-4a73-9f30-fb0dccc196a9"

DEVICE="ens33" #本机网卡名称

ONBOOT="yes" #开机是否激活网卡,为no表示不激活

[root@localhost ~]# service network restartlinux网卡配置文件删掉了如何恢复?

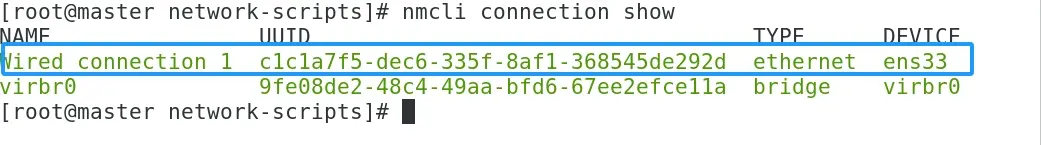

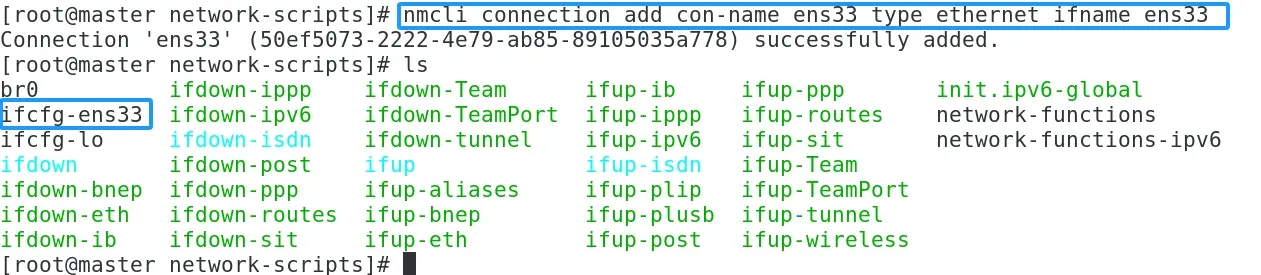

一、解决方法

1.通过nmcli connection show 命令查看所有网络连接信息

nmcli connection show

可以看到有个网卡的名字叫,ens33

2.重新生成网卡配置文件,命令如下:

nmcli con add con-name ens33 type ethernet ifname ens33

执行完命令后,通过ls命令可以看到,多了一个ifcfg-ens33的网卡配置文件。

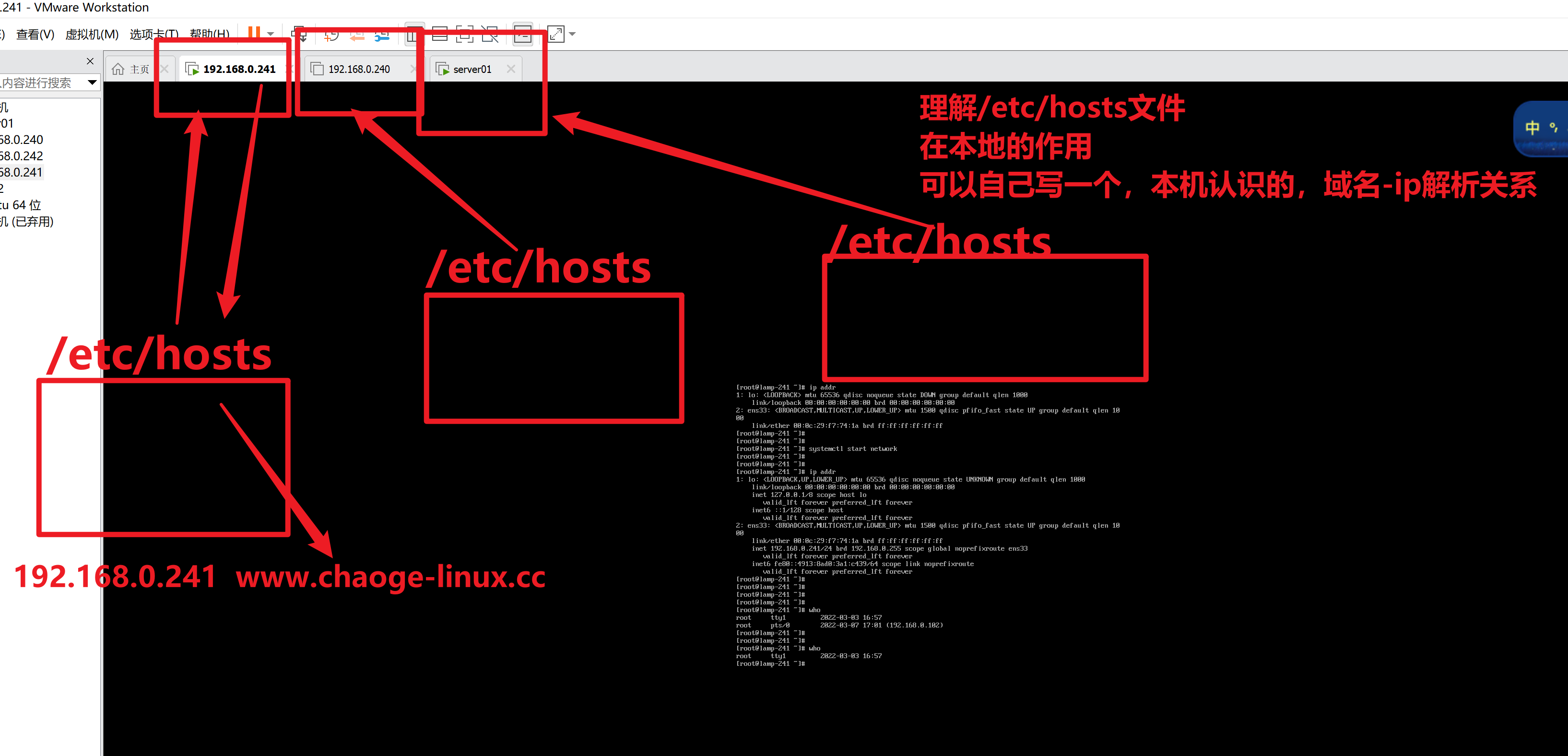

域名

域名

域名映射 : C:\Windows\System32\drivers\etc

在windows上配置虚拟机的ip映射

C:\Windows\System32\drivers\etc\hosts

192.168.133.33 linux01

在linux上配置windows的域名映射

vi /etc/hosts

192.168.133.2 windowsnslookup域名查找

交互式

[root@yuanlai-0224 test_tar]# nslookup

> www.yuchaoit.cn

Server: 114.114.114.114

Address: 114.114.114.114#53

Non-authoritative answer:

Name: www.yuchaoit.cn

Address: 123.206.16.61非交互式

[root@yuanlai-0224 test_tar]# nslookup apecome.com

Server: 114.114.114.114

Address: 114.114.114.114#53

Non-authoritative answer:

Name: apecome.com

Address: 123.57.242.10dig

用法

dig @[DNS] [域名]

[root@yuanlai-0224 test_tar]# dig @8.8.8.8 apecome.comnetstat查看网络端口号

网络端口查看

netstat

英文:network statistics 命令路径:/bin/netstat 执行权限:所有用户

作用:主要用于检测主机的网络配置和状况

-a all显示所有连接和监听端口

-t (tcp)仅显示tcp相关连接

-u (udp)仅显示udp相关连接

-n 使用数字方式显示地址和端口号

-l (listening) 显示监控中的服务器的socket

-p port

-- 执行命令

[root@linux01 ~]# netstat -nltp | grep 3306

tcp6 0 0 :::3306 :::* LISTEN 1748/mysqld

[root@linux01 ~]# service mysqld stop

Redirecting to /bin/systemctl stop mysqld.service

[root@linux01 ~]# netstat -nltp | grep 3306

查看系统上所有端口信息↓

[root@linux01 ~]# netstat -tunlp

注意:如果netstat命令报错 notfound 下载安装

-- 安装网络工具

yum -y install net-tools ss命令

用法和netstat一模一样

ss -tunlp |grep nginx在高并发场景下,也就是机器的链接数特别多的时候,使用ss性能比netstat更高一些。

DNS

CensOS的DNS域名解析文件目录: "/etc/resolv.conf"

cat /etc/resolv.conf ← Linux系统DNS配置文件

[root@root ~]# cat /etc/resolv.conf

# Generated by NetworkManager

search localdomain

nameserver 10.0.0.2

公网DNS列举

114.114.114.114

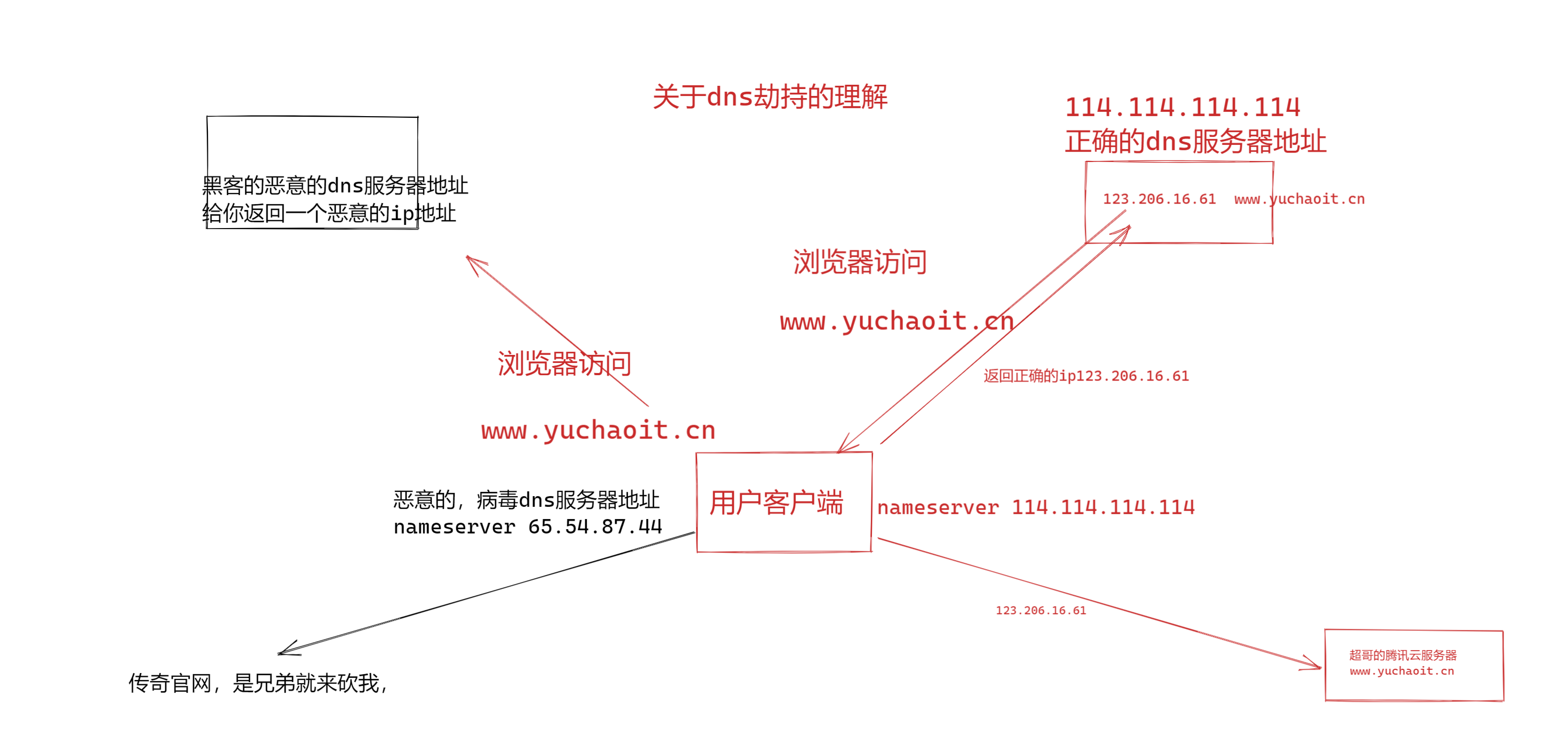

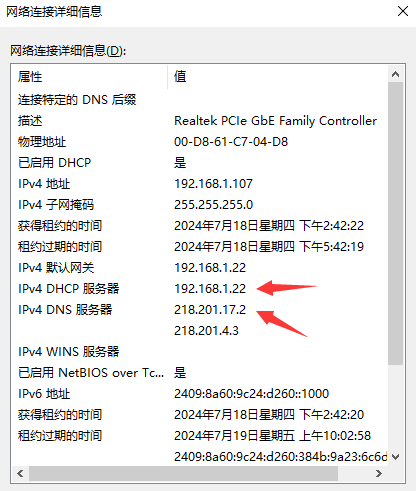

223.5.5.5 #阿里DNS解析DNS劫持原理

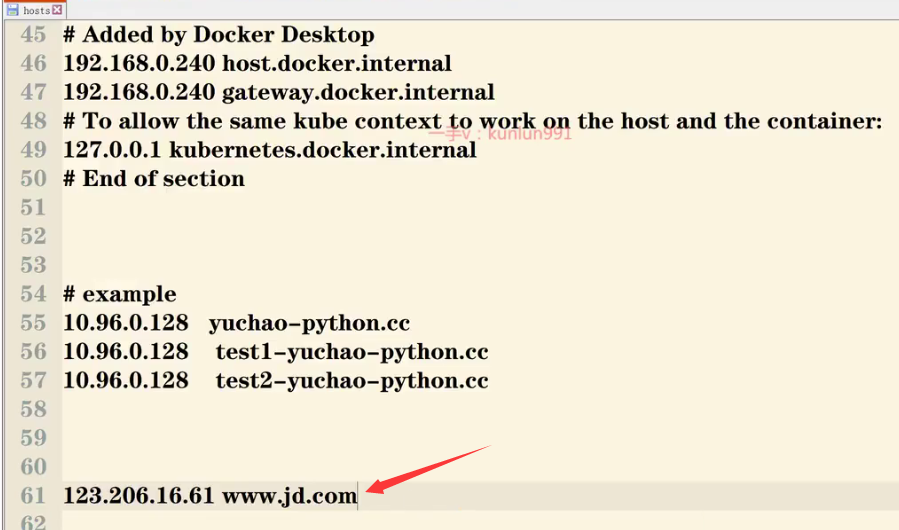

黑客攻击劫持你的DNS方式

1.关闭你本地的公网dns服务器设置

2.修改hosts文件(Windows本地hosts文件路径>>C:\Windows\System32\drivers\etc\host)

网站IP地址与域名要一一对应。

解决方法

1.去掉hosts里的恶意解析

2.配置正确的dns地址

Windows:

Linux:

/etc/resolv.conf3.涉及你本地机器,会有dns解析缓存,使用命令强制刷新

关于/etc/hosts文件

systemctl服务管理

centos7,用这个命令,同时对服务进行启停管理,以及开机自启

systemctl start/stop/restart/reload/enable/disable/is-enabled [服务的名]

这个命令属于对centos6提供的2个命令,做了一个整合

service

这个命令,linux的命令,大多数都是去机器上找到某个文件,然后读取文件配置,加载功能

service旧的命令,是默认去 /etc/init.d/目录下寻找(服务管理脚本文件)

然后根据你的指令 service start/stop network (/etc/init.d/network)

service [服务名] [启停指令]

然后会去读取 /etc/init.d目录下的脚本

我们在用centos6的时候,自己安装了某软件,比如nginx网站,但是没有方便的启停管理脚本

自己写nginx启停脚本,然后放到/etc/init.d/nginx

然后就可以调用

serivce nginx start

chkconfig

两个命令整合了

现在,都用这个指令了更方便,强大

# 这个命令是去

systemctl [启停指令] [服务名] 查找服务

[root@server ~]# systemctl list-units实例

查找防火墙服务是否运行

[root@server ~]# systemctl list-units |grep fire

firewalld.service loaded active running firewalld - dynamic firewall daemon

# 这个命令,其实是找到一个服务脚本文件

systemctl status firewalld.service

# 这个firewalld.service文件在哪?

[root@yuchao-linux01 ~]# find / -type f -name 'firewalld.service'

/usr/lib/systemd/system/firewalld.service

这个脚本,其实就是执行了运行防火墙命令的一个脚本文件

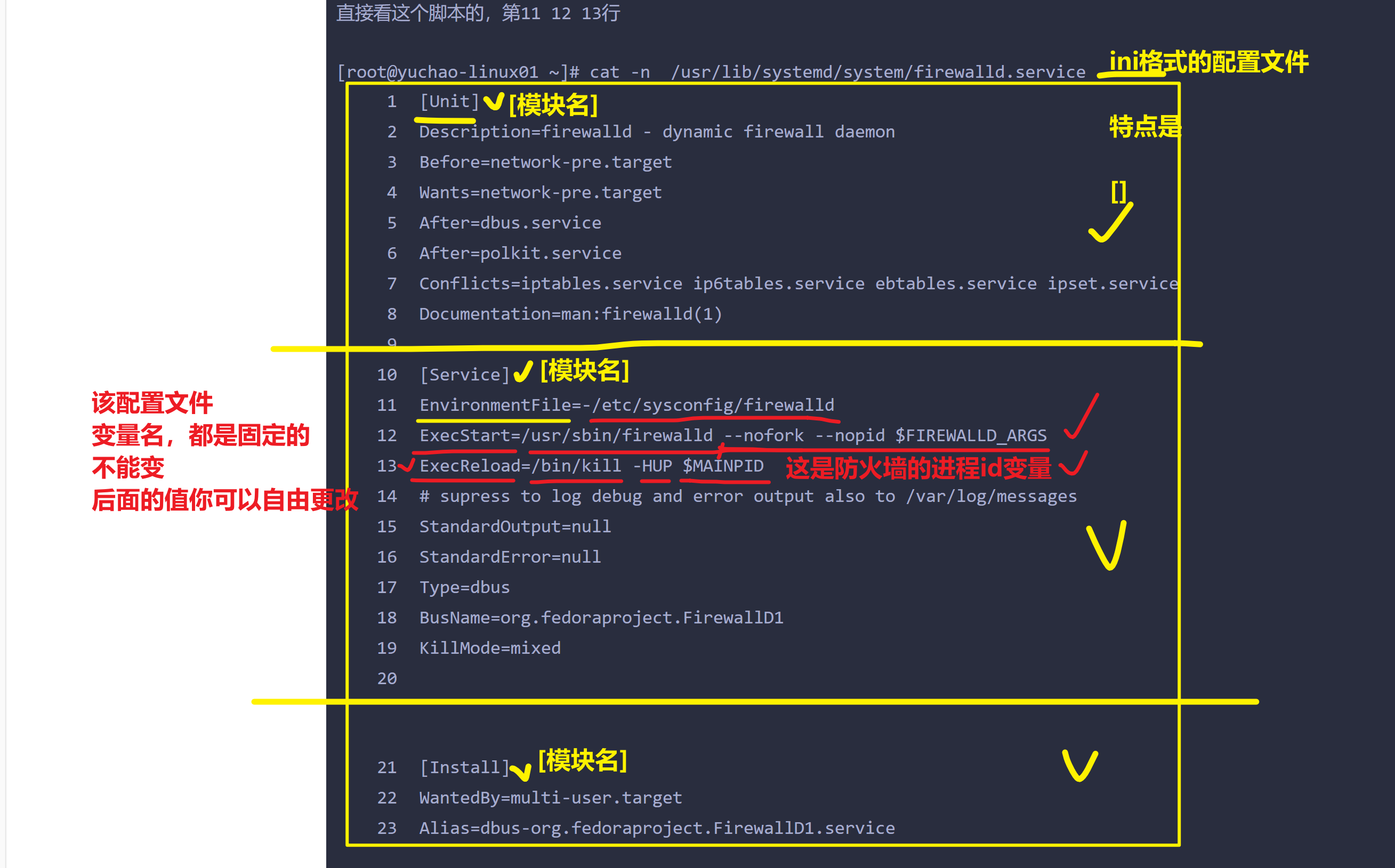

直接看这个脚本的,第11 12 13行

[root@yuchao-linux01 ~]# cat -n /usr/lib/systemd/system/firewalld.service

11 EnvironmentFile=-/etc/sysconfig/firewalld

12 ExecStart=/usr/sbin/firewalld --nofork --nopid $FIREWALLD_ARGS

13 ExecReload=/bin/kill -HUP $MAINPID解释服务管理脚本的作用

其实就是帮你执行了软件提供的二进制命令

firewalld如此 /usr/sbin/fireawlld

nginx也如此 /usr/sbin/nginx

其他软件也都是这样

网络服务network

-- service [服务名] [start|stop|restart|reload|status|enable|is-enable]

service network start 启动网络服务

service network stop 关闭网络服务

service network restart 重启网络服务

service network reload 重新加载网络服务

service network status 显示网络服务状态

service network enable 开机自启网络服务(持久化)

service network is-enable 查询是否持久化(开机自启)

-- systemctl [status|stop|start|restart|disable|enable] [服务名]

systemctl status network 查看网络管理状态

systemctl stop network 关闭网络管理服务

systemctl start network 启用网络管理服务

systemctl restart network 重启网络管理服务

systemctl disable network 开机禁用网络管理服务

systemctl enable network 开机启动网络管理服务

systemctl is-enable 查看是否持久化(是否开机自启)

-- 关闭NetworkManager网络管理服务 避免和network冲突

systemctl status NetworkManager

systemctl stop NetworkManager

systemctl disable NetworkManager

systemctl is-enable NetworkManager #查看是否开机自启图形化网络服务。

[root@localhost ~]# systemctl is-enabled NetworkManager

disabled防火墙服务firewalld

[root@localhost ~]# systemctl status firewalld

Active: active (running) since Fri 2021-10-08 23:02:24 CST; 10h ago -- 防火墙在运行

systemctl start firewalld

systemctl stop firewalld 关闭防火墙

systemctl restart firewalld

systemctl disable firewalld 配置开启禁用

systemctl enable firewalld 开机关闭

systemctl status firewalld 查看防火墙服务状态

如果报错 重新安装防火墙 yum -y install firewalld.service

关闭服务器的防火墙

[root@localhost ~]# iptables -F

关闭系统默认防火墙

[root@localhost ~]# setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config防火墙的概念

区域

Cent0s6x中防火场叫做iptables CentOS7.x中默认使用的防火墙是firewalld,但是依然更多的是使用iptables,firewalld默认都关了。 friewalld增加了区域的概念,所谓区域是指,firewalld预先准备了几套防火墙策略的集合,类似于策略的模板,用户可以根据需求选择区域。

常见区域及相应策略规则

运行模式和永久模式

运行模式:此模式下,配置的防火墙策略立即生效,但是不写入配置文件 永久模式:此模式下,配置的防火墙策略写入配置文件,但是需要reload重新加载才能生效。 frewall默认采用运行模式

解释永久生效的概念

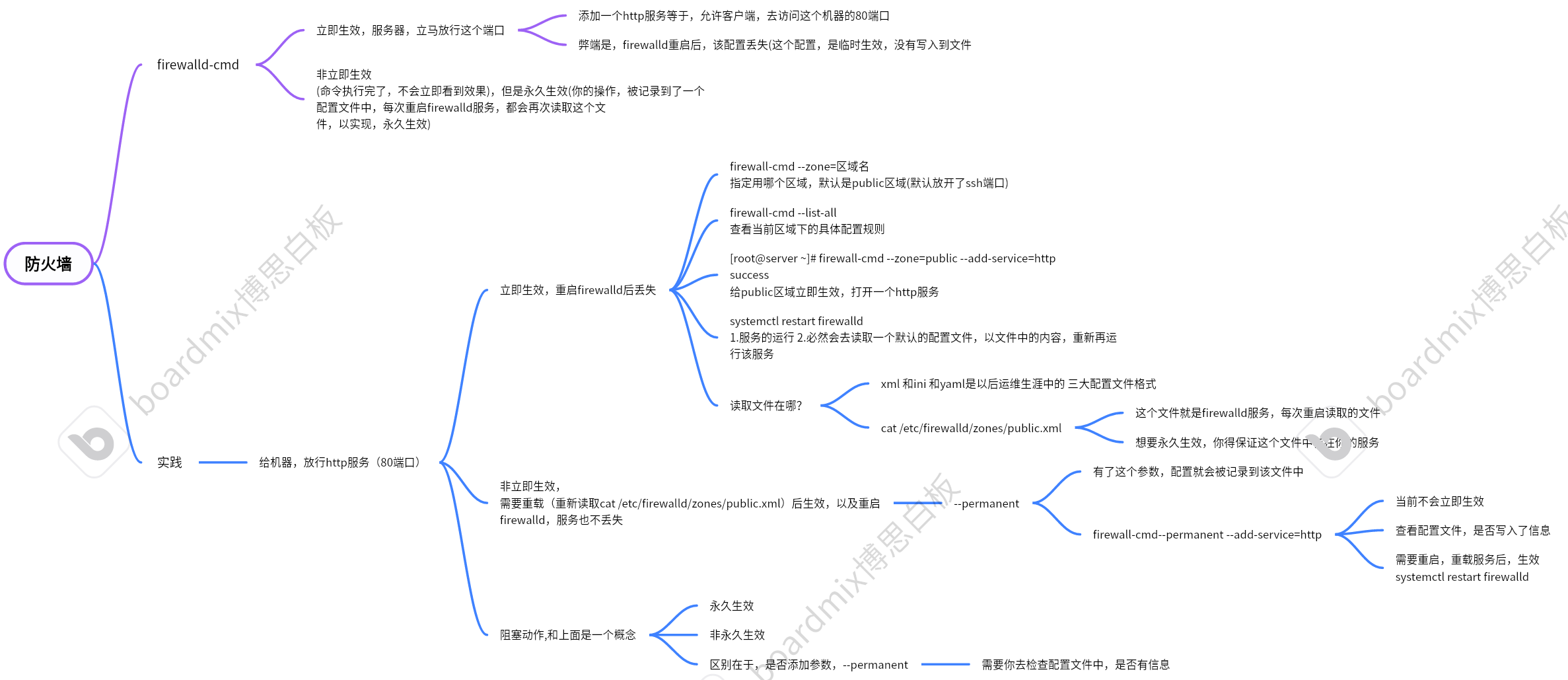

firewalld-cmd

立即生效,服务器,立马放行这个端口

添加一个http服务等于,允许客户端,去访问这个机器的80端口

弊端是,firewalld重启后,该配置丢失(这个配置,是临时生效,没有写入到文件

非立即生效

(命令执行完了,不会立即看到效果),但是永久生效(你的操作,被记录到了一个配置文件中,每次重启firewalld服务,都会再次读取这个文件,以实现永久生效)

实践

给机器,放行http服务(80端口)

立即生效,重启firewalld后丢失

firewall-cmd --zone=区域名

指定用哪个区域,默认是public区域(默认放开了ssh端口)

firewall-cmd --list-all

查看当前区域下的具体配置规则

[root@server ~]# firewall-cmd --zone=public --add-service=http

success

给public区域立即生效,打开一个http服务

systemctl restart firewalld

1.服务的运行 2.必然会去读取一个默认的配置文件,以文件中的内容,重新再运行该服务

读取文件在哪?

xml 和ini 和yaml是以后运维生涯中的 三大配置文件格式

cat /etc/firewalld/zones/public.xml

这个文件就是firewalld服务,每次重启读取的文件

想要永久生效,你得保证这个文件中存在你的服务

非立即生效,

需要重载(重新读取cat /etc/firewalld/zones/public.xml)后生效,以及重启firewalld,服务也不丢失

--permanent

有了这个参数,配置就会被记录到该文件中

firewall-cmd--permanent --add-service=http

当前不会立即生效

查看配置文件,是否写入了信息

需要重启,重载服务后,生效

systemctl restart firewalld

阻塞动作,和上面是一个概念

永久生效

非永久生效

区别在于,是否添加参数,--permanent

需要你去检查配置文件中,是否有信息

firewalld防火墙的配置

管理firewall配置

命令:firewall-cmd

作用:管理firewall具体配置

语法:firewall-cmd [参数选项1]...[参数选项n]

常用选项:

查看当前使用的区域是哪一个

[root@server ~]# firewall-cmd --get-default-zone

public查看所有可用的区域

[root@server ~]# firewall-cmd --get-zones

block dmz drop external home internal public trusted work列出当前使用区域配置

[root@server ~]# firewall-cmd --list-all

public

target: default

icmp-block-inversion: no

interfaces:

sources:

services: dhcpv6-client ssh

ports:

protocols:

masquerade: no

forward-ports:

source-ports:

icmp-blocks:

rich rules: 列出所有区域的配置信息

[root@server ~]# firewall-cmd --list-all-zones查看端口状态

对于使用

iptables的系统:

sudo iptables -L -n | grep 端口号对于使用

firewalld的系统:

sudo firewall-cmd --list-ports | grep 端口号放行端口

用法

对于iptables,可以使用以下命令来放行一个特定端口:

sudo iptables -A INPUT -p tcp --dport 端号 -j ACCEPT请将"端口号”替换为要放行的端口号。此命令将添加一个规则来放行任何TCP连接通过指定的端口。如果您还希望放行UDP连接,请将-p tcp更改为-p udp

对于firewalld,可以使用以下命令来放行一个特定端口:

sudo firewall-cmd --permanent --add-port=端口号/tcp

sudo firewall-cmd --reload同样,请将“端口号”替换为要放行的端口号。此命令将从系统的防火墙规则中添加指定端口的访问权限。

实例:

放行UDP端口123的开放设置。添加相应的规则来允许NTP流量通过。

对于iptables,添加规则的示例:

sudo iptables -I INPUT -p udp --dport 123 -j ACCEPT对于firewalld,添加规则的示例:

sudo firewall-cmd --permanent --add-port=123/udp

sudo firewall-cmd --reload阻塞端口

种常见的方式来关闭端口是通过配置防火墙,[inux系统中最常用的防火墙工具是iptables和frewald。根据您使用的Lnux发行版的不同,可以选择使用其中一种或两种 防火墙工具。

在关闭端口之前,首先需要确定要关闭的特定端口。可以通过使用以下命令来查看当前打开的端口:

sudo netstat -tuln通过执行上述命令,系统将返回当前所有开放的端口及其状态。仔细检查列表,找出需要关闭的端口。值得注意的是,在确定要关闭的端口之前,请确保您已经了解该端口所提供的服务和其关闭可能导致的影响。

用法

对于iptables,可以使用以下命令来关闭一个特定端口:

sudo iptables -A INPUT -p tcp --dport 端号 -j DROP请将"端口号”替换为要关闭的端口号。此命令将添加一个规则来禁止任何TCP连接通过指定的端口。如果您还希望禁止UDP连接,请将-p tcp更改为-p udp

对于firewalld,可以使用以下命令来关闭一个特定端口:

sudo firewall-cmd --zone=public --remove-port=端口号/tcp同样,请将“端口号”替换为要关闭的端口号。此命令将从系统的防火墙规则中删除指定端口的访问权限。

实例

例题一:Linux防火墙阻塞NTP服务端口:udp 123命令

在Linux系统中,可以使用iptables命令来阻止对NTP服务端口123的访问。以下是一个示例命令,它将阻止所有到达端口123的UDP流量:

sudo iptables -A INPUT -p udp --dport 123 -j REJECT/DROP这条命令的含义是:

iptables: 这是操作Linux防火墙的命令。-A INPUT: 添加一条规则到输入链。-p udp: 指定协议为UDP。--

--dport 123: 指定目标端口为123。-j REJECT: 拒绝匹配的流量,并返回一个拒绝的响应。

请确保你有足够的权限来执行这个命令,通常需要root权限。执行后,任何尝试通过UDP端口123访问服务器的NTP请求都会被拒绝。

例题二:添加允许通过的服务或端口(Python,ntp)

你的Linux机器,当前使用的是public区域的规则

默认信任的服务是。ssh,dhcp

准备一个web服务,通过Python提供的简单命令。

1,先运行一个80端口的服务

python -m SimpleHTTPServer 802,给当前的防火墙区域,添加一个策略,允许80端口通过

[root@server ~]# firewall-cmd --add-port=80/tcp

success

[root@server ~]# firewall-cmd --list-all

public

target: default

icmp-block-inversion: no

interfaces:

sources:

services: dhcpv6-client ssh

ports: 80/tcp 8000/tcp

protocols:

masquerade: no

forward-ports:

source-ports:

icmp-blocks:

rich rules:

3.再添加一个8000端口的规则,我们接触的绝大多数,都是端口号/tcp 这个即可.

[root@server ~]# firewall-cmd --add-port=8000/tcp

success4.删除,添加的端口规则

[root@server ~]# firewall-cmd --remove-port=80/tcp

success

[root@server ~]# firewall-cmd --list-all

public

target: default

icmp-block-inversion: no

interfaces:

sources:

services: dhcpv6-client ssh

ports: 8000/tcp

protocols:

masquerade: no

forward-ports:

source-ports:

icmp-blocks:

rich rules: 5.针对服务名添加,比如ntp服务

[root@server ~]# firewall-cmd --add-service=ntp

success

[root@server ~]# firewall-cmd --list-all

public

target: default

icmp-block-inversion: no

interfaces:

sources:

services: dhcpv6-client ntp ssh

ports: 80/tcp

protocols:

masquerade: no

forward-ports:

source-ports:

icmp-blocks:

rich rules:

删除ntp服务

[root@server ~]# firewall-cmd --remove-service=ntp

success6.firewalld,作用其实是添加iptables的规则

#查看系统上所有iptables的命令

iptables -Ltcp 是一个安全可靠的连接,需要双向确认,客户端,和服务端,都要确认对方以及连接上了。

udp 是一个不可靠的额连接协议,客户端可以随便给服务端发,不需要对方确认。

比如一个很差的网络环境下,网页无法访问,无法做dns解析(网络服务,网站服务,用的都是tcp协议) 但是qq可以收发消息(qq用的是udp协议,以及ntp用的也是udp协议)

#查看到firewalld命令,添加的防火墙规则如下

[root@yuchao-linux01 ~]# iptables -L |grep ntp

ACCEPT udp -- anywhere anywhere udp dpt:ntp ctstate NEW7.清空防火墙规则

iptables -F远程登录服务sshd

#1. ssh服务

[root@localhost ~]# netstat -tnlp | grep sshd

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 1116/sshd

tcp6 0 0 :::22 :::* LISTEN 1116/sshd

#2. 我可以自由启动,关闭,重启该服务,查看效果

#3. 学习centos7,启动的强大,服务管理命令

systemctl stop sshd 停止ssh服务

systemctl status sshd 查看ssh服务状态

systemctl start sshd 启动ssh服务

systemctl restart sshd 重启ssh服务

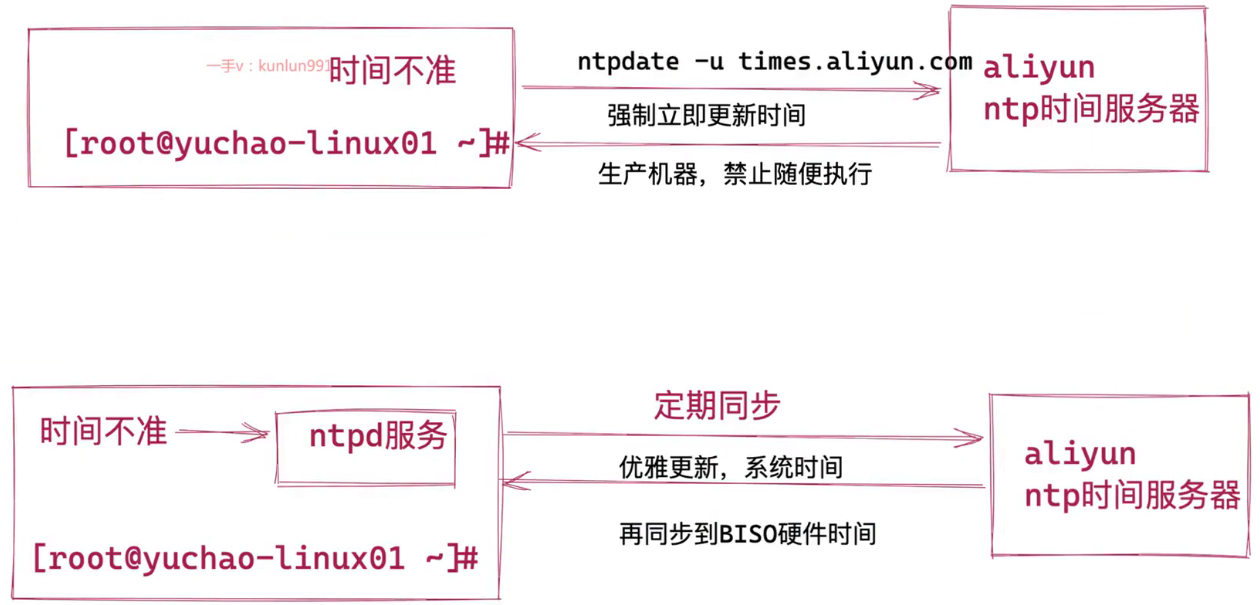

#4. sshd服务,运行后,即可去访问该服务时间同步服务ntp

NTP是网络时间协议(Network Time Protocol)它是用来同步网络中各个计算机的时间的协议在计算机的世里,时间非常地重要

例如:对于火箭发射这种科研活动,对时间的统一性和准确性要求就非常地高,是按照A这台计算机的时间,还是按照B这台计算机的时间?

NTP就是用来解决这个问题的,NTP (NetworkTime Protocol),网络时间协议)是用来使网络中的各个计算机时间同步的一种协议。

它的用途是把计算机的时钟同步到世界协调时UTC,其精度在局域网内可达0.1ms,在互联网上绝大多数的地方其精度可以达到1-50ms。

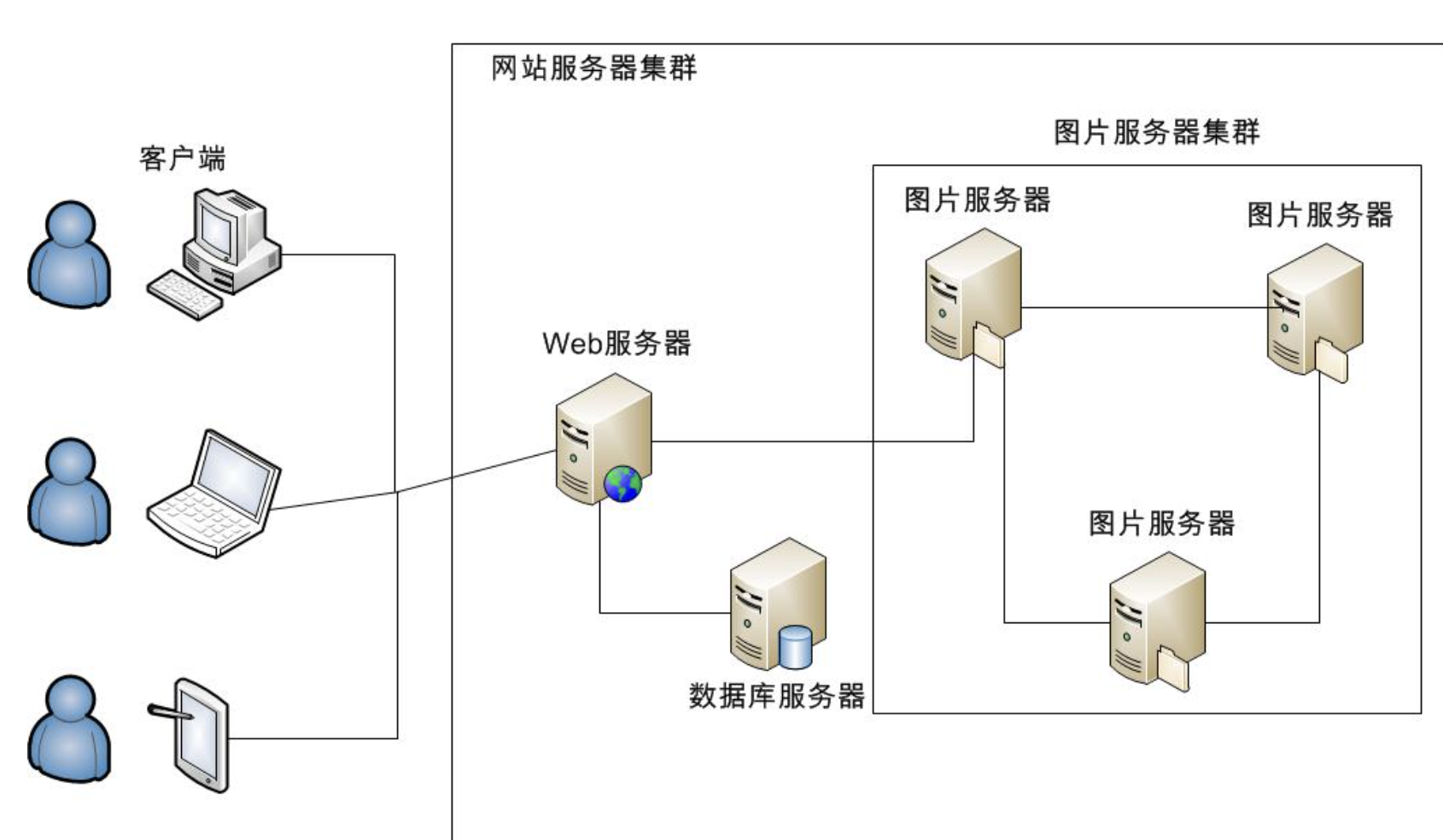

工作场景:

公司开发了一个电商网站,由于访问量很大,网站后端由100台服务器组成集群。 50台负责接收订单,50台负责安排发货,接收订单的服务器需要记录用户下订单的具体时间,把数据传给负 责发货的服务器,由于100台服务器时间各不相同,记录的时间经常不一致,甚至会出现下单时间是明天发货时间是昨天的情况。

时间是很重要的一个单位概念,很多新手、老手,都可能在时间同步服务上翻车,很多服务部署,因为时间的不同步,都会导致出错,增加排错难度。 特别是在集群下,多台服务器,需要部署联调,由于时间不正确,可能导致通信异常。 需要时间的应用。

定时任务的执行

数据同步,时间不一致等。

因此保证服务器之间的时间一致,非常重要。

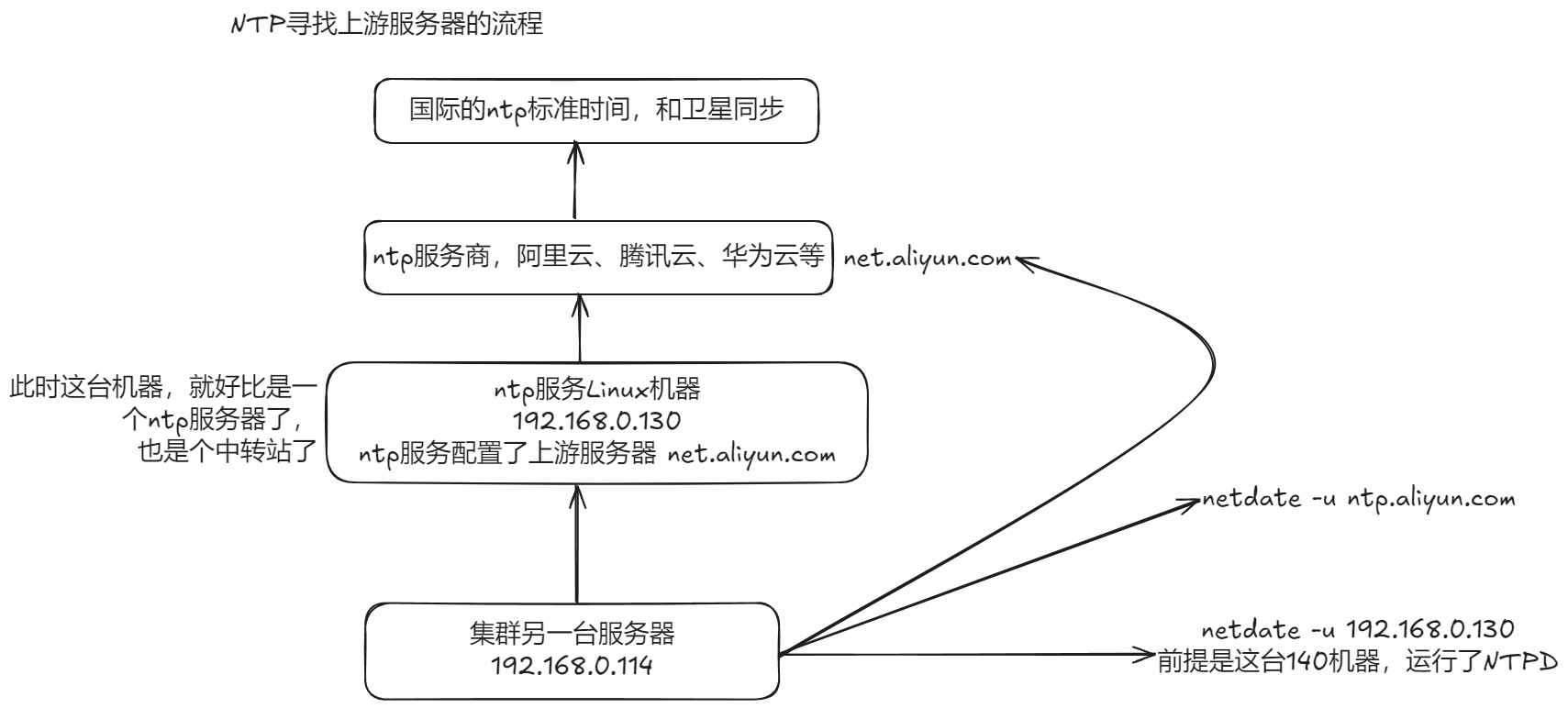

1)NTP同步服务器原理

标准时间是哪里来的? 现在的标准时间是由原子钟报时的国际标准时间UTC(Universal Time Coordinated,世界协调时),所以NTP获得UTC的时间来源可以是原子钟、天文台、卫星,也可以从Internet上获取。 在NTP中,定义了时间按照服务器的等级传播,Stratum层的总数限制在15以内工作中,通常我们会直接使用各个组织提供的,现成的NTP服务器。

2)到哪里去找NTP服务器

NTP授时网站:http://www.ntp.org.cn/pool

hwclock命令

hwclock命令用于显示与设定硬件时钟。

在Linux中有硬件时钟与系统时钟等两种时钟。硬件时钟是指主机板上的时钟设备,也就是通常可在BIOS画面设定的时钟。系统时钟则是指kernel中的时钟。当Linux启动时,系统时钟会去读取硬件时钟的设定,之后系统时钟即独立运作。所有Linux相关指令与函数都是读取系统时钟的设定。

用法

[root@server ~]# hwclock

2018年11月08日 星期四 10时05分32秒 -0.346864 秒

[root@server ~]# hwclock -v

hwclock from util-linux-2.12adate命令

date 命令可以用来显示或设定系统的日期与时间。

用法

[root@server ~]# date

2024年 08月 19日 星期一 16:49:41 CSTtimedatectl命令

timedatectl(英文全拼:timedate control)命令用于在 Linux 中设置或查询系统时间、日期和时区等配置

centos7,cetnso6

systemctl

service

chkconfig

在centos7提供了更强大的timedatectl命令,整合了时、时区操作。

timedatectl

date 改时间日期(软件时间,你的系统运行了,程序计算的时间)

[root@server ~]# date

2024年 08月 19日 星期一 16:49:41 CST

hwclock 改硬件时间(计算的主板上,有一个BISO系统,以及纽扣电池,提供电量)

[root@server ~]# hwclock

2018年11月08日 星期四 10时05分32秒 -0.346864 秒

centos6时代,修改系统的时区、时间,需要用到

修改时间、日期、date命令

#centos6的修改时区的操作,时区就以亚洲上海为准了

修改时区,cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

# 查看系统中有哪些时区文件

ls /usr/share/zoneinfo/

ll /usr/share/zoneinfo/Asia/Shanghai

修改硬件时间、hwclock命令在 Linux 运维中,通常使用此命令来设置或更改当前的日期、时间和时区,或启用自动系统时钟与远程 NTP服务器同步,以确保 Linux 系统始终保持正确的时间。

语法

timedatectl [OPTIONS ...] COMMAND ...

命令COMMAND

status : 显示当前的时间设置。

show : 显示systemd-timedated的性。

set-time TIME : 设置系统时间。

set-timezone ZONE : 设置系统时区。

1ist-timezones : 显示已知时区。

set-local-rtc BOOL : 控制RTC是否在当地时间。(BOOL的值可以是1/true或/false)

set-ntp BOOL : 启用或禁用网络时间同步。(BOOL的值可以是1/true或/false)

timesync-status : 显示systemd-timesyncd的状态。

show-timesync : 显示systemd-timesyncd的属性。

选项OPTIONS

-h,--help : 显示帮助信息。

--version : 显示软件包版本。

--no-pager : 不用将输出通过管道传输到寻呼机(pager)。

--no-ask-password : 不提示输入常码。

-H,--host=[USER@]HOST : 在远程主机上操作。

-M,--machine=CONTAINER : 在本地容器上操作。

--adjust-system-clock : 更改本地RTC模式时调整系统时钟。

--monitor : 监控systemd-timesyncd 的状态。

-P,--property=NAME : 仅显示此名称的属性。

-a,--a11 : 显示所有属性,包括空属性。

--value : 显示属性时,只打印值。timedatectl实例

显示当前系统时间、日期 世界时间查询,http://www.stl56.com/shicha/

查看时间

[root@server ~]# timedatectl status

Local time: Mon 2024-08-19 16:01:16 CST

Universal time: Mon 2024-08-19 08:01:16 UTC

RTC time: Mon 2024-08-19 08:01:17

Time zone: Asia/Shanghai (CST, +0800)

NTP enabled: no

NTP synchronized: no

RTC in local TZ: no

DST active: n/a

解释:

当地时间

世界时间

RTC时间,本地硬件时钟(主板上的绍扣电池供电,提供机器的时间正确,在主板的集成电路上)默认以UTC为准了

时区,亚洲上海

是否启用NTP

NTP国步状态

本地时区的RTC

DST是否激活

CST解释

CST(北京时间)

北京时间,China standard Time,中国标准时间。

在时区划分上,属东八区,比协调世界时早8小时,记为UTC+8。

UTC

UTC(世界标准时间)

协调世界时,又称世界标准时间或世界协调时间,简称UTC(从英文“CoordinatedUniversal Time”)

整个地球分为二十四时区,每个时区都有自己的本地时间,在国际无线电通信场合,为了统一起见,使用一个统一的时间,称为

GMT

格林威治标准时间指位于英国伦敦郊区的皇家格林尼治天文台的标准时问,因为本初子午线被定义在通过那里的经线(UTC与GMT)

DST

夏令时指在复天太阳升起的比较早时,将时间拨快一小时,以提早日光的使用,中国不使用。列出机器上支持的所有时区

[root@server ~]# timedatectl list-timezones

Africa/Abidjan

Africa/Accra

Africa/Addis_Ababa

Africa/Algiers

...

[root@server ~]# timedatectl list-timezones | wc -l

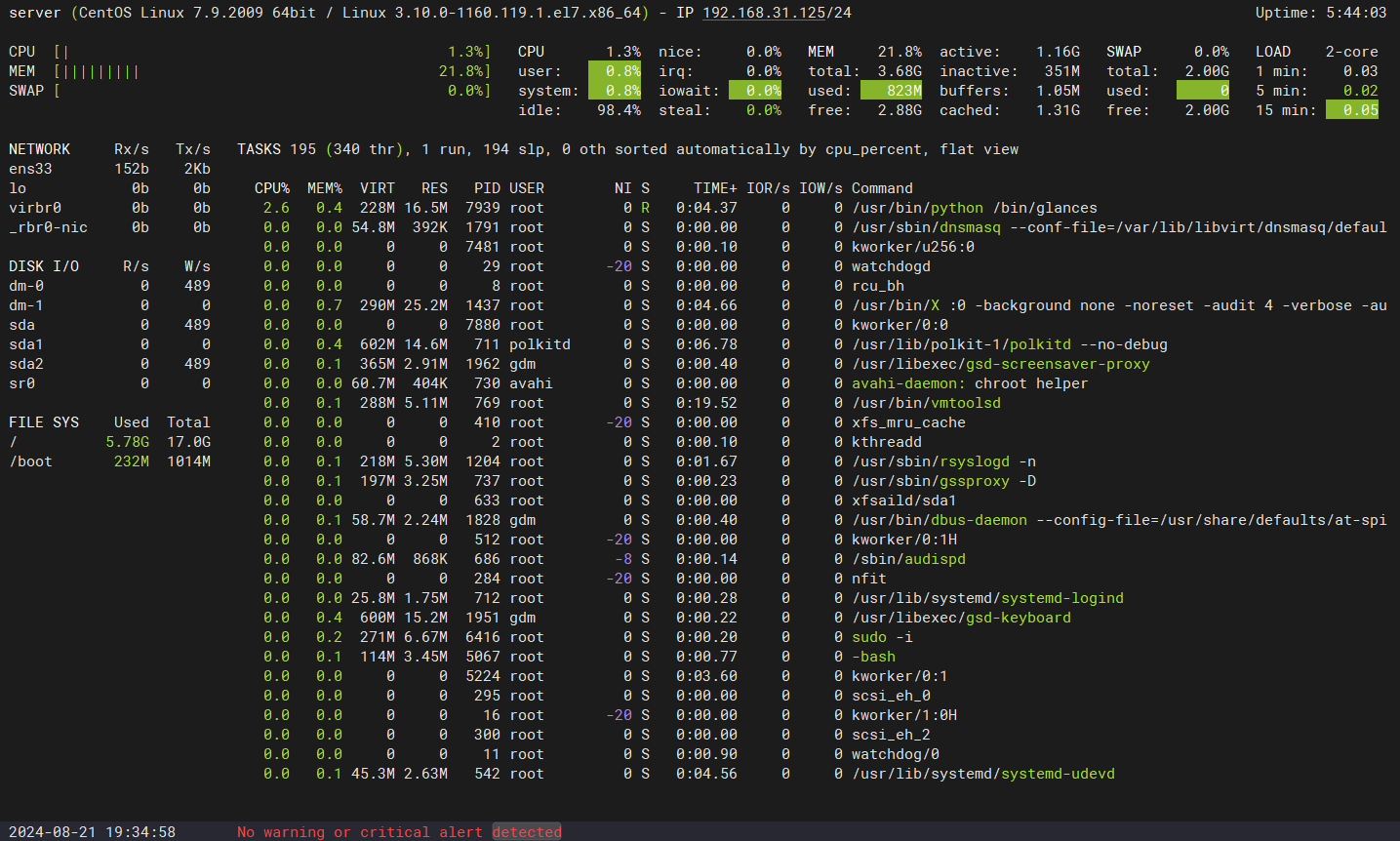

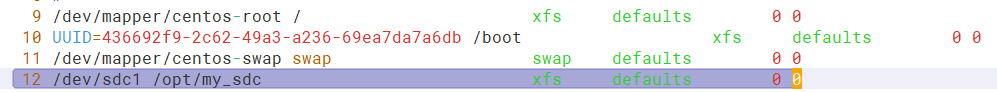

419